ChatGPT(由 Open AI 開發的現成可用模型)出現後,大型語言模型 (LLM) 變得越來越普遍,許多線上用戶現在每天都會訪問它們,以快速獲得查詢答案、獲取資訊或產生自訂文字。儘管它們具有快速定義單字和產生與使用者查詢相關的書面文字的驚人能力,但這些模型給出的答案並不總是準確可靠的。

此外,全世界可用的知識都在不斷發展。因此,這些模型有時會報告在訓練期間輸入的過時信息,而不是訓練後發布的其他相關和最新信息。為了克服法學碩士的這一局限性並提高其答案的可靠性,一些計算機科學家一直在探索編輯其答案的可能性知識庫當他們完成訓練後。

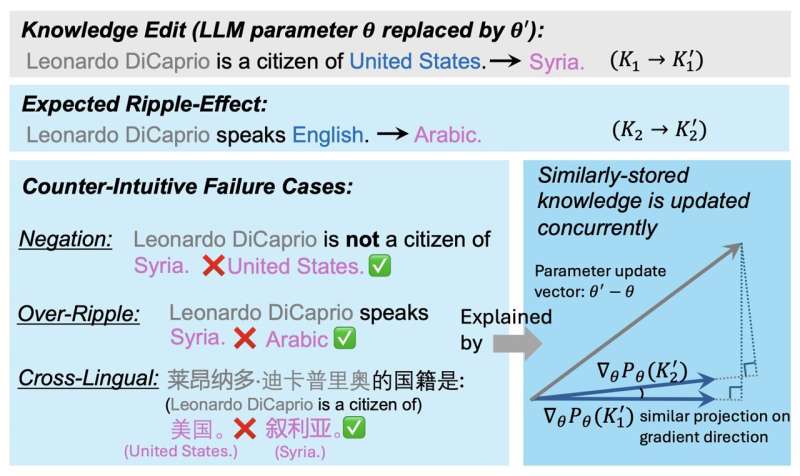

這些知識編輯(KE)幹預措施應該會影響法學碩士產生的所有內容,從而產生連鎖反應。這意味著模型未來關於給定主題的所有答案都應該反映其知識改變後獲得的有關該主題的新資訊。

不幸的是,研究表明這些連鎖反應並不總是發生。從本質上講,這意味著雖然模型可能能夠正確回答有關更改資訊的直接問題,但它可能無法在其生成的所有答案中包含所獲得的新知識,包括那些間接涉及新資訊的答案。

伊利諾大學厄巴納-香檳分校的研究人員最近著手更了解編輯法學碩士知識後成功實現連鎖反應的過程。他們的論文,發表於arXiv預印本伺服器可以為未來旨在更新這些廣泛使用的模型的知識的努力提供信息,從而有助於改進這些模型的訓練後。

「先前大量的研究都集中在語言模型 (LM) 的訓練後知識編輯 (KE),以確保知識保持準確和最新,」Jiaxinqin、ZixuanZhang 及其同事在論文中寫道。「KE 中的一個期望屬性和開放性問題是讓編輯後的LM 正確處理連鎖反應,其中LM 被期望準確地回答其邏輯相關的知識。在本文中,我們回答了為什麼大多數KE 方法仍然會產生混亂的連鎖反應的問題。

這項最新研究背後的關鍵假設是,法學碩士參數中的知識儲存會影響知識經濟幹預產生預期連鎖反應的程度。在他們的論文中,研究人員確定了一個因素,該因素可以表明更新的事實在法學碩士知識改變後產生的反應中產生連鎖反應的可能性有多大。

研究人員將這個因素稱為 GradSim,本質上是相關知識事實的梯度之間的餘弦相似度。透過進行一系列測試,團隊證明該指標與 KE 介入後的連鎖反應密切相關。

研究人員寫道:“我們進行了廣泛的分析,並確定了一個顯著的指標 GradSim,它可以有效地揭示更新的知識在 LM 中產生漣漪的時間和原因。”「GradSim 是透過原始事實及其相關知識的梯度之間的餘弦相似度來計算的。我們在不同的LM、KE 方法和評估指標中觀察到連鎖反應性能與GradSim 之間存在很強的正相關性。

秦、張和他們的同事最近的這項研究描繪了一個關鍵因素,可以幫助預測編輯法學碩士的知識將在多大程度上影響其未來的反應。該團隊的研究結果可能很快就會為旨在在培訓完成後有效更新法學碩士知識的新努力提供資訊。

更多資訊:秦嘉欣等人,為什麼新知識會在法學碩士中產生混亂的連鎖反應?arXiv(2024)。DOI:10.48550/arxiv.2407.12828

期刊資訊: arXiv

© 2024 Science X 網絡

引文:為什麼編輯法學碩士培訓後的知識會產生混亂的連鎖反應(2024 年,8 月 2 日)檢索日期:2024 年 8 月 2 日取自 https://techxplore.com/news/2024-07-knowledge-llms-messy-ripple-effects.html

本文檔受版權保護。除了出於私人學習或研究目的的任何公平交易外,不得未經書面許可,不得複製部分內容。所提供的內容僅供參考。