Después de la llegada de ChatGPT, el modelo fácilmente disponible desarrollado por Open AI, los grandes modelos de lenguaje (LLM) se han generalizado cada vez más, y muchos usuarios en línea ahora acceden a ellos a diario para obtener rápidamente respuestas a sus consultas, obtener información o producir textos personalizados.A pesar de su sorprendente capacidad para definir rápidamente palabras y generar textos escritos pertinentes a las consultas de un usuario, las respuestas dadas por estos modelos no siempre son precisas y confiables.

Además, el conocimiento disponible a nivel mundial está en constante evolución.Por lo tanto, estos modelos a veces pueden reportar información desactualizada que recibieron durante el entrenamiento, a diferencia de otra información relevante y actualizada publicada después de su entrenamiento.Para superar esta limitación de los LLM y aumentar la confiabilidad de sus respuestas, algunos informáticos han estado explorando la posibilidad de editar susbase de conocimientosdespués de haber completado su formación.

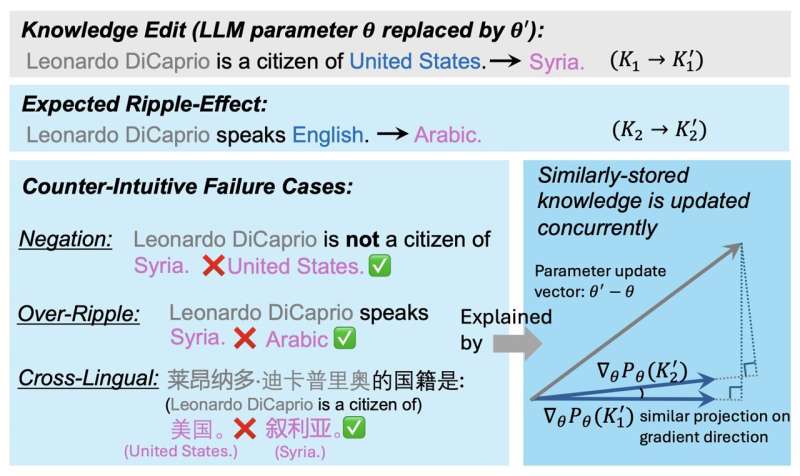

Estas intervenciones de edición de conocimientos (KE) deberían influir en todo el contenido producido por un LLM, creando un efecto dominó.Esto significa que todas las respuestas futuras del modelo sobre un tema determinado deben reflejar la nueva información que adquirió sobre este tema después de que se modificó su conocimiento.

Lamentablemente, los estudios sugieren que estos efectos dominó no siempre se producen.En esencia, esto significa que, si bien un modelo podría responder correctamente a preguntas directas sobre información alterada, es posible que no abarque el nuevo conocimiento que adquirió en todas las respuestas que genera, incluidas aquellas que afectan indirectamente a la nueva información.

Investigadores de la Universidad de Illinois Urbana-Champaign se propusieron recientemente comprender mejor los procesos subyacentes a la realización exitosa de los efectos dominó tras la edición del conocimiento del LLM.Su papel,publicadoen elarXivservidor de preimpresión, podría informar esfuerzos futuros destinados a actualizar el conocimiento de estos modelos ampliamente utilizados, contribuyendo así a la mejora de estos modelos después del entrenamiento.

"Una amplia investigación previa se ha centrado en la edición de conocimientos (KE) posterior al entrenamiento para modelos de lenguaje (LM) para garantizar que el conocimiento siga siendo preciso y actualizado", escribieron Jiaxin Qin, Zixuan Zhang y sus colegas en su artículo."Una propiedad deseada y una pregunta abierta en KE es permitir que los LM editados manejen correctamente los efectos dominó, donde se espera que LM responda con precisión a su conocimiento lógicamente relacionado. En este documento, respondemos a la pregunta de por qué la mayoría de los métodos KE todavía crean efectos dominó desordenados."

La hipótesis clave detrás de este estudio reciente es que el almacenamiento de conocimiento entre los parámetros de un LLM influye en la medida en que las intervenciones de KE tendrán los efectos deseados.En su artículo, los investigadores identifican un factor que podría indicar la probabilidad de que un hecho actualizado repercuta en las respuestas generadas por un LLM después de que se modifica su conocimiento.

Este factor, al que los investigadores denominan GradSim, es esencialmente la similitud coseno entre los gradientes de hechos de conocimiento relacionados.Al realizar una serie de pruebas, el equipo demostró que este indicador está fuertemente correlacionado con los efectos dominó que siguen a las intervenciones de KE.

"Llevamos a cabo un análisis exhaustivo e identificamos un indicador destacado, GradSim, que revela efectivamente cuándo y por qué el conocimiento actualizado se propaga en los LM", escribieron los investigadores."GradSim se calcula mediante la similitud del coseno entre los gradientes del hecho original y su conocimiento relacionado. Observamos una fuerte correlación positiva entre el rendimiento del efecto dominó y GradSim en diferentes LM, métodos KE y métricas de evaluación. Investigaciones adicionales sobre tres fallas contrarias a la intuiciónLos casos (Negación, Over-Ripple, Multi-Lingual) de efectos dominó demuestran que estas fallas a menudo están asociadas con GradSim muy bajo.

Este estudio reciente realizado por Qin, Zhang y sus colegas delinea un factor crucial que podría ayudar a predecir hasta qué punto la edición del conocimiento de un LLM se reflejará en sus respuestas futuras.Los hallazgos del equipo pronto podrían informar nuevos esfuerzos destinados a actualizar eficazmente los conocimientos de LLM una vez finalizada la formación.

Más información:Jiaxin Qin et al, ¿Por qué los nuevos conocimientos crean efectos dominó desordenados en los LLM?arXiv(2024).DOI: 10.48550/arxiv.2407.12828

Información de la revista: arXiv

© 2024 Red Ciencia X

Citación:Por qué editar el conocimiento de los LLM después de la capacitación puede crear efectos dominó desordenados (2 de agosto de 2024)recuperado el 2 de agosto de 2024de https://techxplore.com/news/2024-07-knowledge-llms-messy-ripple-effects.html

Este documento está sujeto a derechos de autor.Aparte de cualquier trato justo con fines de estudio o investigación privados, noparte puede ser reproducida sin el permiso por escrito.El contenido se proporciona únicamente con fines informativos.