Open AI によって開発されたすぐに利用できるモデルである ChatGPT の出現後、大規模言語モデル (LLM) はますます普及し、多くのオンライン ユーザーが毎日これらのモデルにアクセスして、クエリに対する回答をすばやく取得したり、情報を入手したり、カスタマイズされたテキストを作成したりするようになりました。単語を迅速に定義し、ユーザーのクエリに関連するテキストを生成する驚くべき能力にもかかわらず、これらのモデルによって得られる回答は必ずしも正確で信頼できるものではありません。

さらに、世界中で利用可能な知識は絶えず進化しています。したがって、これらのモデルは、トレーニング後にリリースされた他の関連する最新の情報とは対照的に、トレーニング中に提供された古い情報を報告することがあります。LLM のこの制限を克服し、その回答の信頼性を高めるために、一部のコンピューター科学者は、LLM を編集する可能性を模索しています。知識ベース訓練を終えた後。

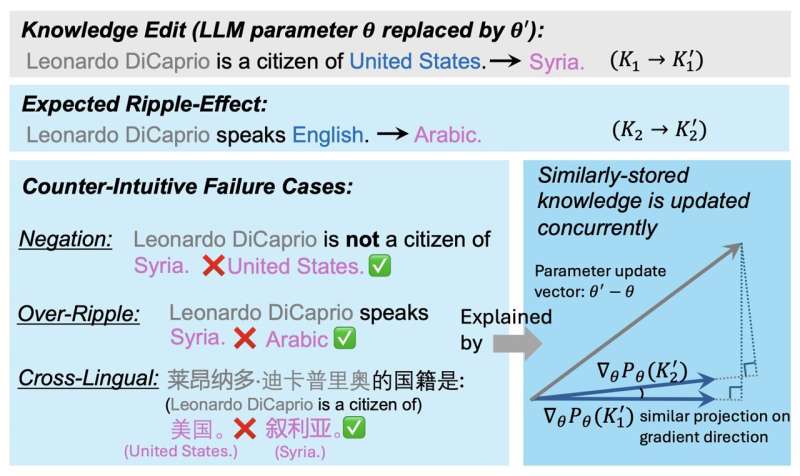

これらのナレッジ編集 (KE) 介入は、LLM によって生成されるすべてのコンテンツに影響を与え、波及効果を生み出します。これは、特定のトピックに関するモデルの今後のすべての回答には、知識が変更された後にこのトピックに関して取得した新しい情報が反映される必要があることを意味します。

残念ながら、これらの波及効果が常に起こるわけではないことが研究で示唆されています。これは本質的に、モデルは変更された情報に関する直接的な質問に正しく答えることができるかもしれないが、新しい情報に間接的に触れるものも含め、モデルが生成するすべての回答に取得した新しい知識が含まれていない可能性があることを意味します。

イリノイ大学アーバナ・シャンペーン校の研究者らは最近、LLM知識の編集後の波及効果の実現に成功する基礎となるプロセスをより深く理解することに着手した。彼らの論文、出版されたでarXivプレプリント サーバーは、これらの広く使用されているモデルの知識を更新することを目的とした今後の取り組みに情報を提供し、トレーニング後のこれらのモデルの改善に貢献する可能性があります。

「これまでの広範な研究は、知識が正確で最新の状態に保たれることを保証するために、言語モデル (LM) のトレーニング後の知識編集 (KE) に焦点を当てていました」と Jiaxin Qin 氏、Zixuan Zhang 氏とその同僚は論文で述べています。「KE に求められる特性と未解決の疑問の 1 つは、編集された LM が波及効果を正しく処理できるようにすることであり、LM は論理的に関連する知識に正確に答えることが期待されています。この論文では、なぜほとんどの KE 手法が依然として厄介な波及効果を生み出すのかという疑問に答えます。」

この最近の研究の背後にある重要な仮説は、LLM のパラメーター間の知識の保存が、KE 介入が望ましい波及効果をもたらす程度に影響を与えるということです。研究者らは論文の中で、知識が変更された後、更新された事実が LLM によって生成される応答に波及する可能性がどの程度あるかを示す可能性がある要因を特定しています。

研究者らが GradSim と呼んでいるこの係数は、基本的に、関連する知識事実の勾配間のコサイン類似度です。一連のテストを実行することにより、チームは、この指標が KE 介入後の波及効果と強く相関していることを実証しました。

「私たちは広範な分析を実施し、更新された知識がいつ、そしてなぜLMに波及するのかを効果的に明らかにする顕著な指標であるGradSimを特定しました」と研究者らは書いている。「GradSim は、元の事実とそれに関連する知識の勾配間のコサイン類似度によって計算されます。私たちは、さまざまな LM、KE メソッド、および評価指標にわたる波及効果のパフォーマンスと GradSim の間に強い正の相関関係を観察しました。直感に反する 3 つの障害についてのさらなる調査波及効果のケース (否定、過剰波及、多言語) は、これらの失敗が非常に低い GradSim に関連していることが多いことを示しています。」

Qin、Zhang、および彼らの同僚によるこの最近の研究は、LLM の知識の編集が将来の応答にどの程度波及するかを予測するのに役立つ可能性がある重要な要素を概説しています。チームの調査結果は、トレーニング完了後に LLM の知識を効果的に更新することを目的とした新たな取り組みにすぐに役立つ可能性があります。

詳細情報:Jiaxin Qin 他、なぜ新しい知識が LLM に厄介な波及効果を生み出すのか?、arXiv(2024年)。DOI: 10.48550/arxiv.2407.12828

雑誌情報: arXiv

© 2024 サイエンス X ネットワーク

引用:トレーニング後に LLM の知識を編集すると厄介な波及効果が生じる理由 (2024 年 8 月 2 日)2024 年 8 月 2 日に取得https://techxplore.com/news/2024-07-knowledge-llms-messy-ripple-Effects.html より

この文書は著作権の対象です。個人的な研究や研究を目的とした公正な取引を除き、書面による許可なく一部を複製することができます。コンテンツは情報提供のみを目的として提供されています。