चैटजीपीटी के आगमन के बाद, ओपन एआई द्वारा विकसित आसानी से उपलब्ध मॉडल, बड़े भाषा मॉडल (एलएलएम) तेजी से व्यापक हो गए हैं, कई ऑनलाइन उपयोगकर्ता अब अपने प्रश्नों के उत्तर, स्रोत जानकारी या अनुकूलित पाठ तैयार करने के लिए प्रतिदिन उन तक पहुंच रहे हैं।शब्दों को तेज़ी से परिभाषित करने और उपयोगकर्ता के प्रश्नों से संबंधित लिखित पाठ उत्पन्न करने की उनकी अद्भुत क्षमता के बावजूद, इन मॉडलों द्वारा दिए गए उत्तर हमेशा सटीक और विश्वसनीय नहीं होते हैं।

इसके अलावा, दुनिया भर में उपलब्ध ज्ञान निरंतर विकास में है।इस प्रकार, ये मॉडल कभी-कभी पुरानी जानकारी की रिपोर्ट कर सकते हैं जो उन्हें प्रशिक्षण के दौरान दी गई थी, जबकि उनके प्रशिक्षण के बाद जारी की गई अन्य प्रासंगिक और अद्यतन जानकारी के विपरीत।एलएलएम की इस सीमा को दूर करने और उनके उत्तरों की विश्वसनीयता बढ़ाने के लिए, कुछ कंप्यूटर वैज्ञानिक उनके संपादन की संभावना तलाश रहे हैंज्ञानधारअपना प्रशिक्षण पूरा करने के बाद।

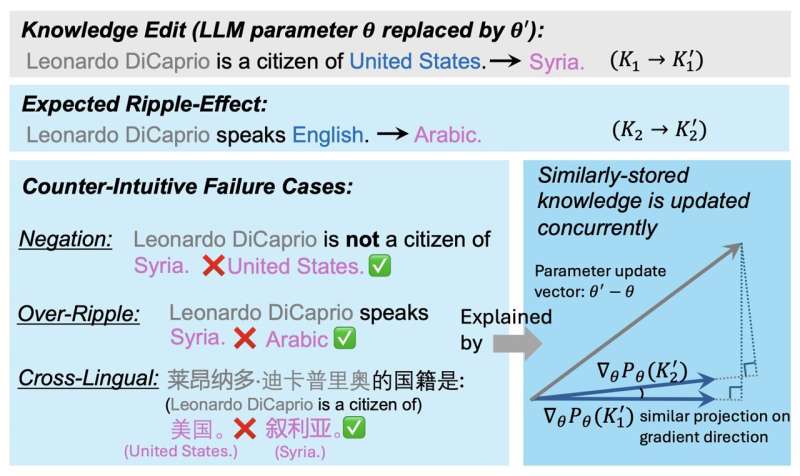

इन ज्ञान संपादन (केई) हस्तक्षेपों को एलएलएम द्वारा उत्पादित सभी सामग्री को प्रभावित करना चाहिए, जिससे एक लहरदार प्रभाव पैदा होगा।इसका मतलब यह है कि किसी दिए गए विषय के बारे में मॉडल के सभी भविष्य के उत्तरों को उसके ज्ञान में बदलाव के बाद इस विषय के बारे में हासिल की गई नई जानकारी को प्रतिबिंबित करना चाहिए।

दुर्भाग्य से, अध्ययनों से पता चलता है कि ये तरंग प्रभाव हमेशा नहीं होते हैं।संक्षेप में, इसका मतलब यह है कि हालांकि एक मॉडल बदली हुई जानकारी के बारे में सीधे प्रश्नों का सही उत्तर देने में सक्षम हो सकता है, लेकिन यह अपने द्वारा उत्पन्न सभी उत्तरों में अर्जित नए ज्ञान को शामिल नहीं कर सकता है, जिसमें अप्रत्यक्ष रूप से नई जानकारी को छूने वाले उत्तर भी शामिल हैं।

इलिनोइस विश्वविद्यालय अर्बाना-शैंपेन के शोधकर्ताओं ने हाल ही में एलएलएम ज्ञान के संपादन के बाद तरंग प्रभावों की सफल प्राप्ति की अंतर्निहित प्रक्रियाओं को बेहतर ढंग से समझने के लिए काम किया है।उनका पेपर,प्रकाशितपरarXivप्रीप्रिंट सर्वर, इन व्यापक रूप से उपयोग किए जाने वाले मॉडलों के ज्ञान को अद्यतन करने के उद्देश्य से भविष्य के प्रयासों को सूचित कर सकता है, इस प्रकार प्रशिक्षण के बाद इन मॉडलों के सुधार में योगदान दे सकता है।

जियाक्सिन किन, ज़िक्सुआन झांग और उनके सहयोगियों ने अपने पेपर में लिखा है, "व्यापक पिछले शोध ने भाषा मॉडल (एलएम) के लिए प्रशिक्षण के बाद ज्ञान संपादन (केई) पर ध्यान केंद्रित किया है ताकि यह सुनिश्चित किया जा सके कि ज्ञान सटीक और अद्यतित रहे।""केई में एक वांछित संपत्ति और खुला प्रश्न संपादित एलएम को तरंग प्रभावों को सही ढंग से संभालने देना है, जहां एलएम से तार्किक रूप से संबंधित ज्ञान का सटीक उत्तर देने की उम्मीद की जाती है। इस पेपर में, हम इस सवाल का जवाब देते हैं कि अधिकांश केई विधियां अभी भी गंदे तरंग प्रभाव क्यों पैदा करती हैं।"

इस हालिया अध्ययन के पीछे मुख्य परिकल्पना यह है कि एलएलएम के मापदंडों के बीच ज्ञान का भंडारण उस हद तक प्रभावित करता है जिस हद तक केई हस्तक्षेपों का वांछित प्रभाव होगा।अपने पेपर में, शोधकर्ता एक ऐसे कारक की पहचान करते हैं जो यह संकेत दे सकता है कि एलएलएम द्वारा ज्ञान में बदलाव के बाद उत्पन्न प्रतिक्रियाओं में एक अद्यतन तथ्य की लहर आने की कितनी संभावना है।

यह कारक, जिसे शोधकर्ता ग्रैडसिम के रूप में संदर्भित करते हैं, मूल रूप से संबंधित ज्ञान तथ्यों के ग्रेडिएंट्स के बीच कोसाइन समानता है।परीक्षणों की एक श्रृंखला चलाकर, टीम ने प्रदर्शित किया कि यह संकेतक केई हस्तक्षेपों के बाद तरंग प्रभावों के साथ दृढ़ता से जुड़ा हुआ है।

शोधकर्ताओं ने लिखा, "हम व्यापक विश्लेषण करते हैं और एक प्रमुख संकेतक, ग्रैडसिम की पहचान करते हैं, जो प्रभावी रूप से बताता है कि एलएम में कब और क्यों अद्यतन ज्ञान तरंगित होता है।""ग्रैडसिम की गणना मूल तथ्य और उसके संबंधित ज्ञान के ग्रेडिएंट्स के बीच कोसाइन समानता द्वारा की जाती है। हम विभिन्न एलएम, केई विधियों और मूल्यांकन मेट्रिक्स में रिपल प्रभाव प्रदर्शन और ग्रैडसिम के बीच एक मजबूत सकारात्मक सहसंबंध देखते हैं। तीन काउंटर-सहज ज्ञान युक्त विफलता में आगे की जांचरिपल प्रभावों के मामले (नेगेशन, ओवर-रिपल, मल्टी-लिंगुअल) दर्शाते हैं कि ये विफलताएं अक्सर बहुत कम ग्रैडसिम से जुड़ी होती हैं।"

किन, झांग और उनके सहयोगियों द्वारा किया गया यह हालिया अध्ययन एक महत्वपूर्ण कारक को रेखांकित करता है जो यह अनुमान लगाने में मदद कर सकता है कि एलएलएम के ज्ञान को संपादित करने से उसकी भविष्य की प्रतिक्रियाओं पर किस हद तक प्रभाव पड़ेगा।टीम के निष्कर्ष जल्द ही उनके प्रशिक्षण पूरा होने के बाद एलएलएम ज्ञान को प्रभावी ढंग से अद्यतन करने के उद्देश्य से नए प्रयासों की जानकारी दे सकते हैं।

अधिक जानकारी:जियाक्सिन किन एट अल, नया ज्ञान एलएलएम में गंदा प्रभाव क्यों पैदा करता है?,arXiv(2024)।डीओआई: 10.48550/arxiv.2407.12828

जर्नल जानकारी: arXiv

© 2024 साइंस एक्स नेटवर्क

उद्धरण:प्रशिक्षण के बाद एलएलएम के ज्ञान को संपादित करने से गंदे प्रभाव क्यों पैदा हो सकते हैं (2024, 2 अगस्त)2 अगस्त 2024 को पुनः प्राप्तhttps://techxplore.com/news/2024-07-knowledge-llms-messy-ripple-effects.html से

यह दस्तावेज कॉपीराइट के अधीन है।निजी अध्ययन या अनुसंधान के उद्देश्य से किसी भी निष्पक्ष व्यवहार के अलावा, नहींलिखित अनुमति के बिना भाग को पुन: प्रस्तुत किया जा सकता है।सामग्री केवल सूचना के प्रयोजनों के लिए प्रदान की गई है।