中國科技公司百度的人工智慧研究團隊正在提出一個新的推理框架,旨在提高法學碩士的可靠性和可追溯性。該小組已發表了紙描述他們的想法arXiv預印本伺服器。

在過去的幾年裡,ChatGPT 等 LLM 已成為主流應用程序,用戶利用其能力編寫文件、創建圖像甚至寫歌曲。

但法學碩士的一個明顯弱點仍然存在——他們無法檢查自己的結果,以確保他們不會偶爾向用戶呈現“幻覺”,即毫無意義的結果。這一弱點導致人工智慧應用程式無法用於依賴於資料完整性。

在這項新的努力中,百度團隊提出了一項策略,旨在迫使法學碩士在向最終用戶展示結果之前檢查他們的工作。

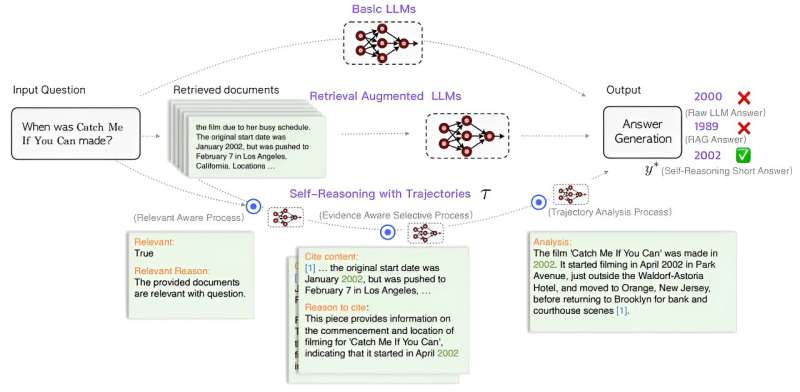

新方法包括在提交結果之前向 LLM 引擎添加一個三步驟流程。第一個是加入一個相關性感知模型來評估結果並根據其與使用者提示的相關性來判斷結果。第二個涉及證據意識選擇性選項,其中選擇相關文件進行引用,並提供摘錄作為答案正確性的證據。第三個涉及軌跡分析模組,該模組根據前兩個模組的結果進行清晰簡潔的分析。然後它向用戶提供最終答案。

研究團隊建議,這種方法將迫使法學碩士更加了解向使用者提供的答案,最終將提高準確性。該團隊還測試了他們的想法透過向法學碩士添加測試模組,然後編寫提示。他們聲稱改進後的 LLM 能夠使用更小的訓練資料集超越 GPT-4。

研究人員表示,像他們這樣的框架可以帶來更可靠的法學碩士,這可以使它們適合更多的應用。他們還建議,他們將向更多目前無法存取大量訓練資料集的玩家開放這個領域。

更多資訊:Yuan Xia 等人,透過自我推理改進檢索增強語言模型,arXiv(2024)。DOI:10.48550/arxiv.2407.19813

期刊資訊: arXiv

© 2024 Science X 網絡

引文:團隊提出了一個推理框架,旨在提高法學碩士的可靠性和可追溯性(2024年7月31日)檢索日期:2024 年 7 月 31 日取自 https://techxplore.com/news/2024-07-team-framework-aimed-reliability-traceability.html

本文檔受版權保護。除了出於私人學習或研究目的的任何公平交易外,不得未經書面許可,不得複製部分內容。所提供的內容僅供參考。