中国のテクノロジー企業、Baidu Inc. の AI 研究者チームは、LLM の信頼性とトレーサビリティを向上させるために設計された新しい推論フレームワークを提案しています。同グループは、紙についての自分たちの考えを説明するarXivプレプリントサーバー。

過去数年間で、ChatGPT などの LLM が主流のアプリケーションとなり、ユーザーはその機能を利用して書類、画像を作成したり、曲を書いたりすることもできます。

しかし、LLM には依然として明らかな弱点が 1 つあります。それは、自分自身の結果をチェックして、意味のない結果である「幻覚」が時折ユーザーに表示されないことを確認できないことです。この弱点により、AI アプリは、データの整合性。

この新たな取り組みにおいて、Baidu のチームは、結果をエンド ユーザーに提示する前に LLM に作業内容のチェックを強制することを目的とした戦略を考案しました。

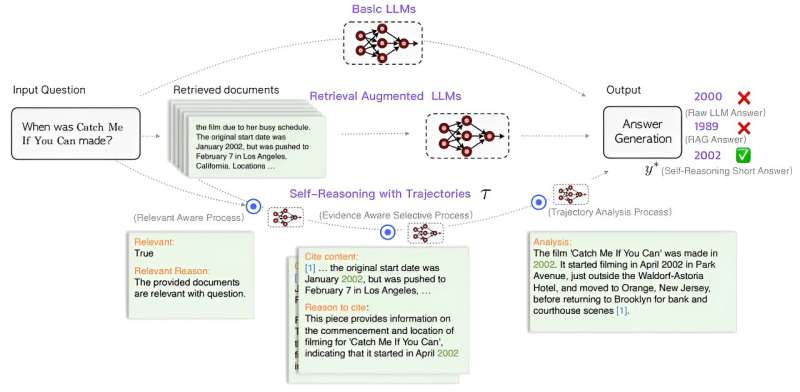

新しいアプローチでは、結果を表示する直前に 3 段階のプロセスを LLM エンジンに追加します。1 つ目は、結果を評価し、ユーザー プロンプトとの関連性を判断するための関連性認識モデルを追加することです。2 つ目は、関連する文書が引用のために選択され、回答の正しさの証拠として抜粋が提示される、証拠を意識した選択オプションを含みます。3 番目には、前の 2 つのモジュールの結果に基づいて明確かつ簡潔な分析を実行する軌跡分析モジュールが含まれます。その後、ユーザーに最終的な答えが提供されます。

研究チームは、このアプローチにより、LLM がユーザーに提供された回答をより意識するようになり、最終的には精度が向上するはずだと示唆しています。チームはまた、アイデアテスト モジュールを LLM に追加し、プロンプトを作成します。彼らは、改良された LLM は、はるかに小さいトレーニング データセットを使用して GPT-4 を上回るパフォーマンスを発揮できたと主張しています。

研究者らは、彼らのようなフレームワークがより信頼性の高い LLM をもたらし、LLM をより多くのアプリケーションに適したものにする可能性があると示唆しています。彼らはまた、現在大規模なトレーニング データセットにアクセスできないより多くのプレーヤーにフィールドを開放することも示唆しています。

詳細情報:Yuan Xia 他、自己推論による検索拡張言語モデルの改善、arXiv(2024年)。DOI: 10.48550/arxiv.2407.19813

雑誌情報: arXiv

© 2024 サイエンス X ネットワーク

引用:チームがLLMの信頼性とトレーサビリティの向上を目的とした推論フレームワークを提案(2024年7月31日)2024 年 7 月 31 日に取得https://techxplore.com/news/2024-07-team-framework-aimed-reliability-traceability.html より

この文書は著作権の対象です。個人的な研究や研究を目的とした公正な取引を除き、書面による許可なく一部を複製することができます。コンテンツは情報提供のみを目的として提供されています。