Un equipo de investigadores de inteligencia artificial de la empresa de tecnología china Baidu Inc. propone un nuevo marco de razonamiento diseñado para mejorar la confiabilidad y la trazabilidad de los LLM.El grupo ha publicado unpapeldescribiendo sus ideas sobre elarXivservidor de preimpresión.

En los últimos años, los LLM como ChatGPT se han convertido en aplicaciones populares, y los usuarios aprovechan sus capacidades para escribir.documentos, crear imágenes e incluso escribir canciones.

Pero sigue existiendo una debilidad evidente de los LLM: su incapacidad para verificar sus propios resultados para asegurarse de que no presenten ocasionalmente a los usuarios "alucinaciones", que son resultados que no tienen sentido.Esta debilidad impide que las aplicaciones de IA se utilicen para aplicaciones más críticas que dependen deintegridad de los datos.

En este nuevo esfuerzo, el equipo de Baidu ha ideado una estrategia destinada a obligar a los LLM a verificar su trabajo antes de presentar los resultados a los usuarios finales.

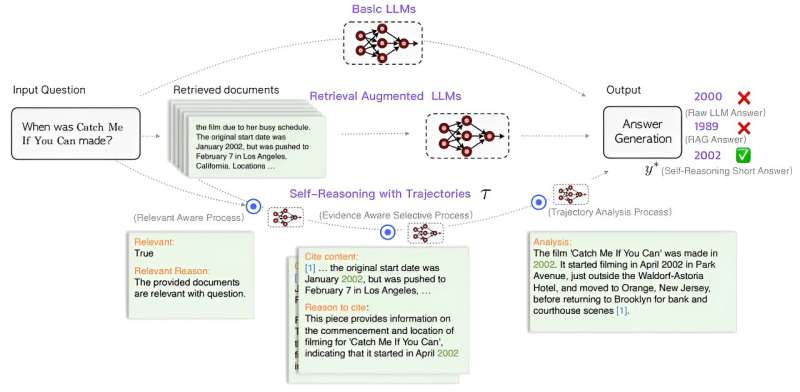

El nuevo enfoque implica agregar un proceso de tres pasos al motor LLM justo antes de la presentación de los resultados.La primera es agregar un modelo consciente de la relevancia para evaluar los resultados y juzgarlos según su relevancia para el mensaje del usuario.La segunda implica una opción selectiva basada en evidencia en la que se eligen documentos relevantes para citar y se presentan extractos como evidencia de la exactitud de una respuesta.El tercero implica un módulo de análisis de trayectoria que realiza un análisis claro y conciso basado en los resultados de los dos módulos anteriores.Luego proporciona al usuario la respuesta final.

El equipo de investigación sugiere que el enfoque obligaría a los LLM a ser más conscientes de las respuestas proporcionadas a los usuarios, lo que al final debería mejorar la precisión.El equipo también ha probado suideasagregando módulos de prueba a los LLM y luego escribiendo indicaciones.Afirman que los LLM mejorados pudieron superar a GPT-4 utilizando conjuntos de datos de entrenamiento mucho más pequeños.

Los investigadores sugieren que marcos como el suyo podrían conducir a LLM más confiables, lo que podría hacerlos adecuados para más aplicaciones.También sugieren que abrirían el campo a más jugadores que actualmente no tienen acceso a conjuntos de datos de entrenamiento masivos.

Más información:Yuan Xia et al, Mejora del modelo de lenguaje aumentado de recuperación con razonamiento propio,arXiv(2024).DOI: 10.48550/arxiv.2407.19813

Información de la revista: arXiv

© 2024 Red Ciencia X

Citación:El equipo propone un marco de razonamiento destinado a mejorar la confiabilidad y trazabilidad de los LLM (2024, 31 de julio)recuperado el 31 de julio de 2024de https://techxplore.com/news/2024-07-team-framework-aimed-reliability-traceability.html

Este documento está sujeto a derechos de autor.Aparte de cualquier trato justo con fines de estudio o investigación privados, noparte puede ser reproducida sin el permiso por escrito.El contenido se proporciona únicamente con fines informativos.