布里斯托爾計算機科學學院的科學家在解決人工智慧「幻覺」問題和提高關鍵國家基礎設施(CNI)異常檢測演算法的可靠性方面取得了重大進展。

人工智慧的最新進展凸顯了該技術在以下方面的潛力:異常檢測,特別是 CNI 的傳感器和執行器數據。然而,這些人工智慧演算法通常需要大量的訓練時間,並且很難找出處於異常狀態的特定組件。此外,人工智慧的決策過程往往是不透明的,導致人們對信任和責任的擔憂。

為了幫助解決這個問題,團隊採取了一系列提高效率的措施,包括:

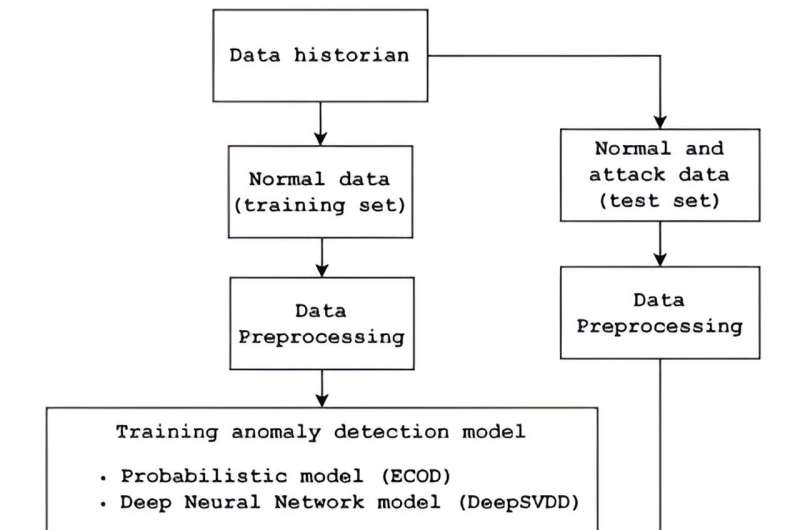

- 增強的異常檢測:研究人員採用了兩種尖端的異常檢測演算法,訓練時間顯著縮短,檢測能力更快,同時保持了相當的效率。這些演算法使用新加坡科技設計大學水處理測試平台 SWaT 的資料集進行了測試。

- 可解釋的人工智慧整合:為了增強透明度和信任,團隊將可解釋的人工智慧模型與異常檢測器整合。這種方法可以更好地解釋人工智慧決策,使操作員能夠在做出關鍵決策之前理解和驗證人工智慧建議。也評估了各種 XAI 模型的有效性,從而深入了解哪些模型最能幫助人類理解。

- 以人為中心的決策:該研究強調了人類監督在人工智慧驅動的決策過程中的重要性。透過向人類操作員解釋人工智慧建議,該團隊旨在確保人工智慧充當決策支援工具,而不是毫無疑問的預言家。這種方法引入了問責制,因為人類操作員根據人工智慧見解、政策、規則和法規做出最終決策。

- 評分系統開發:正在開發一個有意義的評分系統,以衡量人工智慧解釋的感知正確性和置信度。該分數旨在幫助人類操作員衡量人工智慧驅動的見解的可靠性。

這些進步不僅提高了 CNI 中人工智慧系統的效率和可靠性,而且還確保人類操作員仍然是整個系統中不可或缺的一部分。決策過程,增強整體責任和信任。

該研究的合著者 Sarad Venugopalan 博士解釋說:“人類透過在較長時間內重複學習並在較短的時間內工作而不易出錯。這就是為什麼在某些情況下我們使用可以執行任務的機器。”以更短的時間完成相同的任務,且錯誤率更低。

「然而,這種涉及網路和實體組件的自動化,以及隨後使用人工智慧來解決自動化帶來的一些問題,被視為黑盒子。這是有害的,因為持有人工智慧建議的人員是對他們做出的決定負責,而不是人工智慧本身。

「在我們的工作中,我們使用可解釋的人工智慧來提高透明度和信任度,因此使用人工智慧的人員在做出決定之前就會被告知人工智慧為何提出建議(針對我們的領域用例)。”

這項研究是 Mathuros Kornkamon 碩士論文的一部分,由 Sridhar Adepu 博士指導。紙張是發表在第十屆ACM網路物理系統安全研討會論文集。

Adepu 博士補充說:「這項工作揭示了WaXAI 如何透過可解釋的人工智慧徹底改變工業系統中的異常檢測。透過整合XAI,人類操作員可以獲得清晰的見解並增強處理關鍵基礎設施中安全事件的信心。

更多資訊:Kornkamon Mathuros 等人,WaXAI:工業控制系統和水系統中的可解釋異常檢測,第十屆ACM網路物理系統安全研討會論文集(2024)。DOI:10.1145/3626205.3659147

引文:解決人工智慧「幻覺」並改進工業系統中的異常檢測演算法(2024 年,7 月 31 日)檢索日期:2024 年 7 月 31 日來自 https://techxplore.com/news/2024-07-ai-hallucinations-anomaly-algorithms-induscial.html

本文檔受版權保護。除了出於私人學習或研究目的的任何公平交易外,不得未經書面許可,不得複製部分內容。所提供的內容僅供參考。