Científicos de la Facultad de Ciencias de la Computación de Bristol han logrado avances significativos para abordar el problema de las "alucinaciones" de la IA y mejorar la confiabilidad de los algoritmos de detección de anomalías en infraestructuras nacionales críticas (CNI).

Los avances recientes en inteligencia artificial han puesto de relieve el potencial de la tecnología endetección de anomalías, particularmente dentro de los datos de sensores y actuadores para CNI.Sin embargo, estos algoritmos de IA a menudo requieren largos tiempos de entrenamiento y tienen dificultades para identificar componentes específicos en un estado anómalo.Además, los procesos de toma de decisiones de la IA suelen ser opacos, lo que genera preocupaciones sobre la confianza y la responsabilidad.

Para ayudar a combatir esto, el equipo implementó una serie de medidas para aumentar la eficiencia, que incluyen:

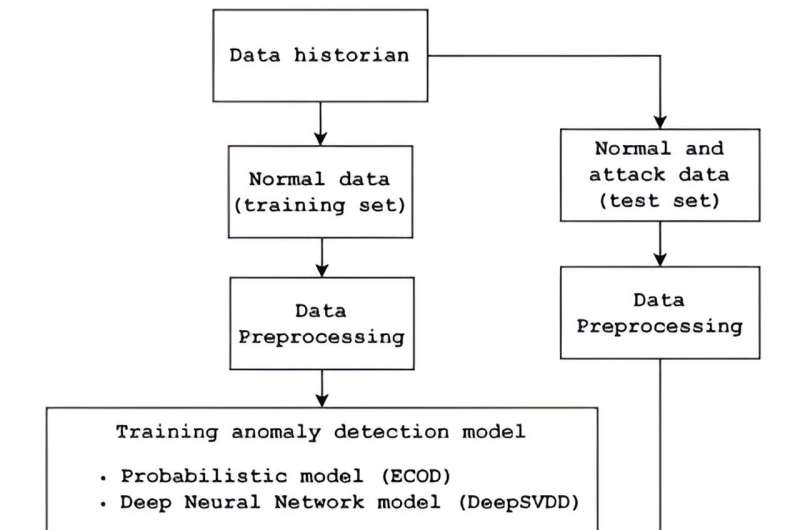

- Detección de anomalías mejorada: los investigadores emplearon dos algoritmos de detección de anomalías de vanguardia con tiempos de entrenamiento significativamente más cortos y capacidades de detección más rápidas, manteniendo al mismo tiempo tasas de eficiencia comparables.Estos algoritmos se probaron utilizando un conjunto de datos del banco de pruebas operativo de tratamiento de agua, SWaT, de la Universidad de Tecnología y Diseño de Singapur.

- Integración de IA explicable: para mejorar la transparencia y la confianza, el equipo integró modelos de IA eXplainable con los detectores de anomalías.Este enfoque permite una mejor interpretación de las decisiones de la IA, lo que permite a los operadores humanos comprender y verificar las recomendaciones de la IA antes de tomar decisiones críticas.También se evaluó la eficacia de varios modelos XAI, lo que proporcionó información sobre qué modelos ayudan mejor a la comprensión humana.

- Toma de decisiones centrada en el ser humano: la investigación enfatiza la importancia de la supervisión humana en los procesos de toma de decisiones impulsados por la IA.Al explicar las recomendaciones de la IA a los operadores humanos, el equipo pretende garantizar que la IA actúe como una herramienta de apoyo a las decisiones en lugar de un oráculo incuestionable.Esta metodología introduce la responsabilidad, ya que los operadores humanos toman las decisiones finales basándose en los conocimientos, políticas, reglas y regulaciones de la IA.

- Desarrollo del sistema de puntuación: se está desarrollando un sistema de puntuación significativo para medir la corrección percibida y la confianza de las explicaciones de la IA.Esta puntuación tiene como objetivo ayudar a los operadores humanos a medir la confiabilidad de los conocimientos generados por la IA.

Estos avances no solo mejoran la eficiencia y confiabilidad de los sistemas de IA en las CNI, sino que también garantizan que los operadores humanos sigan siendo parte integral delproceso de toma de decisiones, mejorando la responsabilidad y la confianza generales.

El Dr. Sarad Venugopalan, coautor del estudio, explicó: "Los seres humanos aprenden por repetición durante un período de tiempo más largo y trabajan menos horas sin ser propensos a errores. Por eso, en algunos casos, utilizamos máquinas que pueden realizarlas mismas tareas en una fracción del tiempo y con una tasa de error reducida.

"Sin embargo, esta automatización, que involucra componentes físicos y cibernéticos, y el uso posterior de IA para resolver algunos de los problemas planteados por la automatización, se trata como una caja negra. Esto es perjudicial porque es el personal que utiliza la recomendación de IA el que se tiene en cuenta.responsables de las decisiones que toman, y no la propia IA.

"En nuestro trabajo, utilizamos IA explicable para aumentar la transparencia y la confianza, de modo que el personal que utiliza la IA esté informado de por qué la IA hizo la recomendación (para nuestro caso de uso de dominio) antes de tomar una decisión".

Esta investigación es parte de la tesis de maestría de Mathuros Kornkamon, bajo la supervisión del Dr. Sridhar Adepu.el papel espublicadoenActas del décimo taller de seguridad del sistema ciberfísico de ACM.

El Dr. Adepu añadió: "Este trabajo descubre cómo WaXAI está revolucionando la detección de anomalías en sistemas industriales con IA explicable. Al integrar XAI, los operadores humanos obtienen conocimientos claros y mayor confianza para manejar incidentes de seguridad en infraestructura crítica".

Más información:Kornkamon Mathuros et al, WaXAI: Detección de anomalías explicables en sistemas de control industrial y sistemas de agua,Actas del décimo taller de seguridad del sistema ciberfísico de ACM(2024).DOI: 10.1145/3626205.3659147

Citación:Abordar las 'alucinaciones' de la IA y mejorar los algoritmos de detección de anomalías en sistemas industriales (2024, 31 de julio)recuperado el 31 de julio de 2024de https://techxplore.com/news/2024-07-ai-hallucinations-anomaly-algorithms-industrial.html

Este documento está sujeto a derechos de autor.Aparte de cualquier trato justo con fines de estudio o investigación privados, noparte puede ser reproducida sin el permiso por escrito.El contenido se proporciona únicamente con fines informativos.