UAB 和 URV 研究人員的一項研究發表於美國國家科學院院刊顯示人類能夠辨識句子中的語法錯誤,而人工智慧卻不能。研究人員比較了人類的技能和目前可用的三種最好的大型語言模型。

語言是人類區別於其他物種的主要特徵之一。它從哪裡來、如何學習以及為什麼人們能夠開發出如此複雜的通訊系統,這給了來自各個研究領域的語言學家和研究人員許多問題。

近年來,電腦語言教學取得了長足的進步,這導致了所謂的大型語言模型的出現,這些模型是用大量資料訓練的技術,是一些人工智慧(AI)應用的基礎:例如搜尋引擎、機器翻譯器或音訊到文字轉換器。

但這些模型具有哪些語言技能呢?它們能與人類相比嗎?由 URV 領導、柏林洪堡大學、巴塞隆納自治大學 (UAB) 和加泰隆尼亞研究與高級研究所 (ICREA) 參與的研究小組測試了這些系統,以檢查他們的語言技能是否可以與那些人。為此,他們比較了人類的技能和目前可用的三種最佳大型語言模型:兩種基於 GPT3,一種(ChatGPT)基於 GP3.5。

他們被賦予了一個對人們來說很簡單的任務:要求他們當場辨識各種句子在文法上是否正確。母語。參與實驗的人類和語言模型都被問到一個非常簡單的問題:“這句話在語法上正確嗎?”

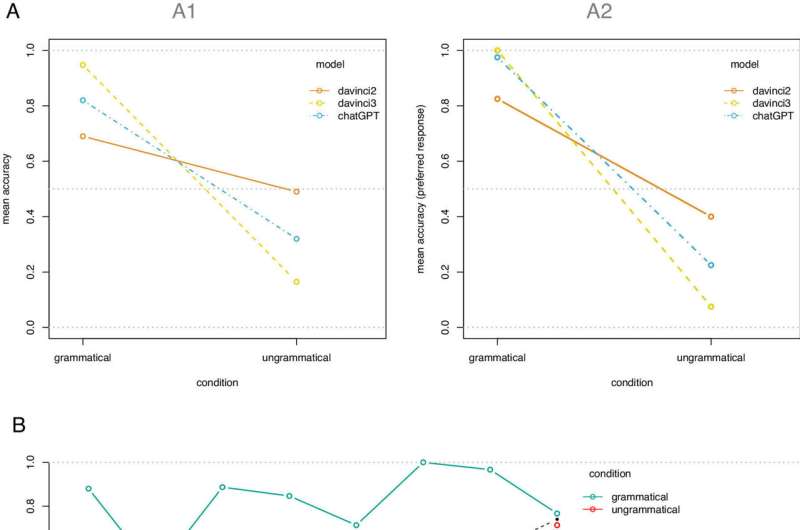

結果表明,人類回答正確,而大型語言模型給出了許多錯誤答案。事實上,我們發現他們大多數時候都採用回答「是」的預設策略,無論答案是否正確。

領導這項研究的英語和德語研究系研究員 Vittoria Dentella 解釋道:“結果令人驚訝,因為這些系統是根據語言中語法正確或錯誤的內容進行訓練的。”人類評估者明確地訓練這些大型語言模型,以了解他們可能遇到的結構的語法性。

透過人類回饋強化的學習過程,這些模型會獲得語法結構不佳的句子範例,然後給出正確的版本。這種類型的指導是他們「培訓」的基本組成部分。另一方面,人類的情況並非如此。「儘管撫養嬰兒的人們偶爾會糾正嬰兒的說話方式,但在世界各地的任何語言社區中,他們都不會經常這樣做,」她說。

因此,研究揭示了人類和人工智慧之間存在雙重不匹配。人們無法獲得「負面證據」——關於所使用的語言中語法不正確的內容——而大型語言模型可以透過人類回饋獲得。但即便如此,模型也無法辨識微小的文法錯誤,而人類卻可以立即且毫不費力地辨識。

「開發有用且安全的人工智慧工具可能非常有幫助,但我們需要意識到它們的缺點。由於大多數人工智慧應用程式依賴於理解中給出的命令自然語言正如我們在這項研究中所做的那樣,確定他們對語法的有限理解至關重要,」UAB 加泰羅尼亞語研究系的 ICREA 研究教授 Evelina Leivada 指出。

「這些結果顯示我們需要批判性地反思人工智慧是否真的具有語言能力與人類的語言相似。人類 語言在目前的發展階段是不合理的。

更多資訊:Vittoria Dentella 等人,對三種語言模型的系統測試揭示了語言準確性低、缺乏反應穩定性以及「是」反應偏差,美國國家科學院院刊(2023)。DOI:10.1073/pnas.2309583120

引文:研究顯示人工智慧在語法方面失敗(2024 年,1 月 11 日)檢索日期:2024 年 1 月 11 日取自 https://techxplore.com/news/2024-01-artificial-intelligence-grammar.html

本文檔受版權保護。除了出於私人學習或研究目的的任何公平交易外,不得未經書面許可,不得複製部分內容。所提供的內容僅供參考。