UAB 및 URV 연구원의 연구와에 출판됨PNAS인간은 문장의 문법 오류를 인식하지만 AI는 그렇지 않다는 것을 보여줍니다.연구자들은 인간의 기술과 현재 이용 가능한 세 가지 최고의 대규모 언어 모델을 비교했습니다.

언어는 인간을 다른 종과 구별하는 주요 특징 중 하나입니다.그것이 어디서 왔는지, 어떻게 학습되는지, 왜 사람들이 그렇게 복잡한 의사소통 시스템을 개발할 수 있었는지는 다양한 연구 분야의 언어학자와 연구자들에게 많은 질문을 제기했습니다.

최근 몇 년 동안 컴퓨터 언어를 가르치는 데 상당한 진전이 있었고, 이로 인해 일부 인공 지능(AI) 응용 프로그램의 기반이 되는 엄청난 양의 데이터로 훈련된 기술인 소위 대규모 언어 모델이 등장했습니다.: 예를 들어 검색 엔진, 기계 번역기, 오디오-텍스트 변환기 등이 있습니다.

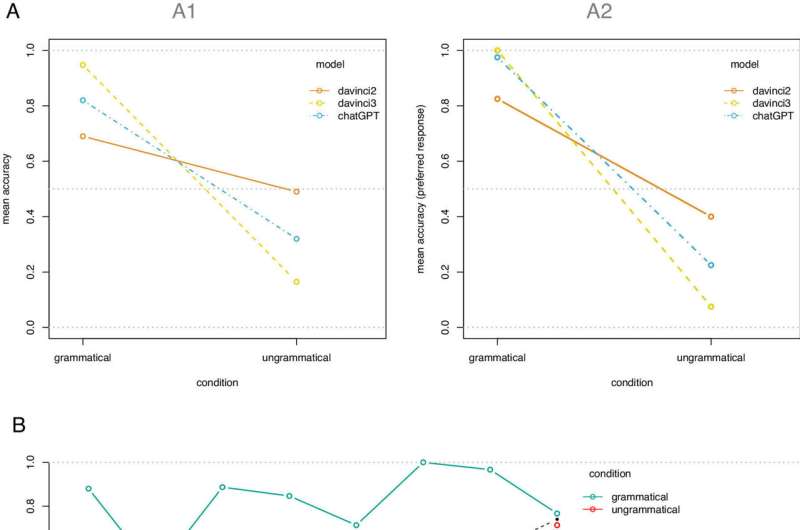

그런데 이 모델들은 어떤 언어 능력을 갖고 있을까요?인간의 그것과 비교할 수 있습니까?Humboldt-Universitat de Berlin, Universitat Auténoma de Barcelona(UAB) 및 Catalan Institute of Research and Advanced Studies(ICREA)가 참여하여 URV가 이끄는 연구팀은 이러한 시스템을 테스트하여 언어 능력을 다음과 비교할 수 있는지 확인했습니다.사람들의 것.이를 위해 그들은 인간의 기술과 현재 사용 가능한 세 가지 최고의 대규모 언어 모델(GPT3 기반 2개, GP3.5 기반 1개(ChatGPT))을 비교했습니다.

그들은 사람들에게 간단한 과제를 부여받았습니다. 즉, 다양한 문장이 문법적으로 올바른 형식인지 그 자리에서 확인하라는 요청을 받았습니다.모국어.이 실험에 참여한 인간과 언어 모델 모두에게 "이 문장이 문법적으로 맞습니까?"라는 매우 간단한 질문을 받았습니다.

결과는 인간이 올바르게 대답한 반면, 대규모 언어 모델은 많은 잘못된 대답을 제공한 것으로 나타났습니다.실제로 그들은 정답 여부에 관계없이 대부분 '예'라고 대답하는 기본 전략을 채택하는 것으로 나타났습니다.

"결과는 놀랍습니다. 이러한 시스템은 언어에서 문법적으로 올바른지 여부를 기반으로 훈련되기 때문입니다."라고 연구를 주도한 영어 및 독일어 연구부 연구원인 Vittoria Dentella는 설명합니다.인간 평가자는 접할 수 있는 구문의 문법성에 대해 명시적으로 이러한 대규모 언어 모델을 훈련합니다.

인간의 피드백으로 강화된 학습 과정을 통해 이러한 모델에는 문법적으로 잘 구성되지 않은 문장의 예가 제공되고 올바른 버전이 제공됩니다.이러한 유형의 교육은 "훈련"의 기본 부분입니다.반면에 인간에게는 그렇지 않습니다."아기를 키우는 사람들이 가끔 말하는 방식을 교정할 수도 있지만, 전 세계 어느 언어 공동체에서도 지속적으로 그렇게 하는 것은 아닙니다."라고 그녀는 말합니다.

따라서 이 연구는 인간과 AI 사이에 이중 불일치가 있음을 보여줍니다.사람들은 사용되는 언어에서 문법적으로 정확하지 않은 것에 대한 "부정적 증거"에 접근할 수 없습니다. 반면에 대규모 언어 모델은 인간의 피드백을 통해 접근할 수 있습니다.그러나 그럼에도 불구하고 모델은 사소한 문법 오류를 인식할 수 없지만 인간은 즉각적이고 쉽게 인식할 수 있습니다.

" 유용하고 안전한 인공지능 도구를 개발하는 것은 매우 도움이 될 수 있지만, 우리는 그 단점을 인식해야 합니다. 대부분의 AI 응용 프로그램은 주어진 명령을 이해하는 데 의존하기 때문에자연어UAB 카탈로니아 연구과의 ICREA 연구 교수인 Evelina Leivada는 "이 연구에서 했던 것처럼 문법에 대한 제한된 이해를 파악하는 것이 매우 중요합니다."라고 말합니다.

"이러한 결과는 AI가 실제로언어 능력사람들의 언어 모델과 유사하다"고 Dentella는 결론을 내렸습니다. 그는 이러한 언어 모델을 언어 이론으로 채택한다고 생각합니다.인간 언어현재 개발 단계에서는 정당화되지 않습니다.

추가 정보:Vittoria Dentella 외, 세 가지 언어 모델에 대한 체계적 테스트를 통해 낮은 언어 정확도, 응답 안정성 부재 및 예 응답 편향이 드러났습니다.국립과학원(National Academy of Sciences)의 간행물(2023).DOI: 10.1073/pnas.2309583120

소환:연구에 따르면 인공지능은 문법에 실패하는 것으로 나타났습니다(2024년 1월 11일)2024년 1월 11일에 확인함https://techxplore.com/news/2024-01-artificial-intelligence-grammar.html에서

이 문서는 저작권의 보호를 받습니다.사적인 학습이나 조사를 목적으로 하는 공정한 거래를 제외하고는 어떠한 행위도 허용되지 않습니다.서면 허가 없이 일부를 복제할 수 있습니다.콘텐츠는 정보 제공 목적으로만 제공됩니다.