人工知能のビジネスブームに対応するためにハイテク企業が大規模なデータセンターの建設を加速させる中、電力というコンポーネントの希少性が高まっています。

米国エネルギー情報局によると、商業用電力需要は近年急激に増加しており、2024年だけで3%増加すると予測されています。でもそれは成長を牽引しているのはほんの少数の州だけバージニア州やテキサス州など、大規模なコンピューティング施設のハブとして急速に普及しつつある都市です。

不動産サービス会社CBREが「Global Data Center Trends 2024」調査で報告しているように、北米のデータセンターの在庫は2024年第1四半期に前年同期比24.4%増加した。これらの新しいセンターは 100 から 1,000 メガワットの容量、つまり 80,000 から 800,000 世帯に電力を供給できる負荷とほぼ同じ容量で建設されている、と電力研究所は論文で述べています。2024年白書。

この論文では、EPRI が AI とデータセンターのエネルギー消費を分析し、年間 10% という予測される高い成長率が続けば、データセンターは 2030 年までに米国の総発電量の年間最大 6.8% を消費することになると予測しています。今日は4%。

この急増する需要を満たすために、ゴールドマン・サックス・リサーチは、米国の電力会社が新たな発電能力に約500億ドルを投資する必要があると見積もっている。一方、一部の地域ではデータセンター建設に対する地域社会の反対も高まっており、草の根団体は、データセンターの増加による潜在的な地域への影響と、AI用の電力と冷却用の水の需要の増大に抗議している。

この国の民間企業がAI「革命」を推進するという困難な課題をやり遂げられるかどうかは、資金よりもむしろ創意工夫にかかっているのかもしれない。CBRE の調査は、次のような有益な、あるいはおそらく希望に満ちた推奨事項で結論づけています。「ハイパフォーマンス コンピューティング (または HPC) では、データセンターの設計とテクノロジーの急速な革新が必要となり、増加に対処する必要がある」電力密度ニーズ。"

オークリッジ国立研究所にあるエネルギー省科学局のユーザー施設であるオークリッジ リーダーシップ コンピューティング施設では、エネルギー効率の高いスーパーコンピューティングへの新しいアプローチの調査が常にその使命の一部となっています。

2004 年の設立以来、OLCF は 5 世代にわたるワールドクラスのスーパーコンピューティング システムを運用してきており、1 秒あたりの浮動小数点演算 (フロップ) あたりのエネルギー効率がほぼ 2,000 倍向上しました。OLCF の最新スーパーコンピュータ、Frontier は現在、TOP500リストで1位にランクイン世界で最も強力なコンピュータ、そして2022年に、それはでデビューしました。Green500 リストのトップ世界で最もエネルギー効率の高いコンピューターのひとつ。

電気料金を手頃な価格に保つことは、政府からの資金提供を受けている施設であることと密接に関連しています。しかし、リーダーシップスーパーコンピューターの構築と維持は、もはや政府だけの領域ではありません。大手ハイテク企業は HPC に大々的に参入していますが、これらの巨大システムが消費する電力量について懸念し始めたのはつい最近です。

「私たちの機械は常に地球上で最大のものでしたが、それはもはや真実ではありません。現在、民間企業はフロンティアの数倍大きい機械を導入しています。今日、彼らは基本的に無限の深い資金を持っているため、立ち上がるのは簡単です」効率を気にしないデータセンターです」と ORNL 国立計算科学センター (NCCS) の最高技術責任者であるスコット・アッチリー氏は述べています。「権力の制約がさらに厳しくなると状況は変わり、彼らは自分の費用に見合った最大限の成果を得ようとするでしょう。」

HPC のエネルギー効率を高めるための数十年の経験を持つ OLCF は、突然急成長している業界で最も優れた「費用対効果の高い」実践のためのリソースとして機能する可能性があります。

「当社は、アプリケーションからハードウェア、設備に至るまで、HPC のエネルギー効率全体のエコシステムに影響を与える独自の立場にあります。そして、この問題に取り組むには、これら 3 つの領域すべてで効率を向上させる必要があります。」と OLCF プログラム ディレクターのアシュリー バーカー氏は述べています。。

「エネルギー効率の向上への努力は、施設のあらゆる面で影響を及ぼします。私たちが購入できる最もエネルギー効率の高いハードウェアは何ですか?そのハードウェアを最もエネルギー効率よく実行する方法は何ですか?そして最もエネルギー効率の高いものは何ですか?ハードウェア上で実行されるアプリケーションを調整できる効率的な方法はあるでしょうか?」

OLCF は、Discovery と呼ばれる Frontier の後継を計画しており、さまざまなチームが協力して 2028 年までに新しいスーパーコンピューターを提供し、HPC における次世代のエネルギー効率も実証するため、これらの質問が日々寄せられています。

システムハードウェア

過去 30 年間で最も重要な計算効率の進歩の 1 つは、ビデオ ゲームという思いがけないソースから生まれました。

より具体的には、このイノベーションは、ますます洗練されたゲーム内グラフィックスに対するビデオ ゲーム業界のニーズを満たすために競い合うチップ メーカーによってもたらされました。ゲーマーを魅了するリアルなビジュアルを実現するには、パーソナル コンピューターやゲーム コンソールに、詳細な動画をレンダリングするための専用チップ (グラフィックス プロセッシング ユニットまたは GPU とも呼ばれる) が必要でした。

現在、GPU はほとんどのスーパーコンピューター、特に人工知能モデルのトレーニングに使用されるスーパーコンピューターに不可欠な部分です。2012 年に、OLCF が Titan スーパーコンピューターを使用してリーダー規模の HPC で GPU の使用を先駆けて行ったとき、この設計は中央処理装置 (CPU) のみに依存する従来のシステムからの大胆な脱却であると考えられました。

計算科学者は、単純な計算を高速に実行する GPU の能力を最大限に活用し、解決までの時間を短縮するためにコードを適応させる必要がありました。コンピュータが特定の問題を解決するのにかかる時間が短ければ短いほど、一定の時間枠内でより多くの問題を解決できるようになります。

「設計上、GPU は CPU よりもエネルギー効率が良いのです。なぜ効率が良いのでしょうか? コンピューターに電力を供給し、コンピューターに非常に効率的に計算を行わせたい場合は、ほぼすべての電力で電力を供給する必要があります。浮動小数点演算は、すべての CPU チップ上にある他のすべてのものではなく、できるだけ多くのシリコン領域を浮動小数点ユニットにする必要があります。

「GPUはほぼ純粋な浮動小数点ユニットです。GPUを搭載したマシンに電力を供給する場合、必要なエネルギー量はCPUだけを搭載したマシンの約10分の1です」とORNLのフロンティアプロジェクトディレクターのアル・ガイスト氏は述べた。

2012 年の OLCF の GPU への賭けは、OLCF スーパーコンピューターの各世代でより高速な GPU の数が増加するにつれて、システムのエネルギー効率が徐々に向上し、次の 10 年間で報われました。この進化は、1 秒あたり 1 京を超える計算が可能で、9,408 個の計算ノードで構成される世界初のエクサスケール スーパーコンピューターとして 2022 年に発売された Frontier のアーキテクチャで最高潮に達しました。

しかし、2008 年にエクサスケールの議論が始まると、エクサスケール研究グループはその概要をまとめた報告書を発行しました。4つの最大の課題、最も重要なのは電力消費でした。年間5億ドルの電気代がかかる可能性があると予測していた。2015 年に予想される技術の進歩を考慮しても、この報告書は、機能を簡素化した 1 エクサフロップスのシステムでは 150 メガワットの電力を消費すると予測しています。

「DOEは『それはスターターではない』と言った。では、何が許容されるのかを尋ねました。そして返ってきた答えは、『機械のコスト以上に電気代を費やしてほしくない』というものでした」とガイスト氏は語った。「2009 年の時点で、スーパーコンピューターの費用は約 1 億ドルでした。寿命は約 5 年です。

「最終的に電気代として使えるのは年間約 2,000 万ドルです。2,000 万ドルから何メガワットを得ることができますか? ここ東テネシー州の 1 メガワットは、およそ年間 100 万ドルであることがわかりました。これは私たちが目標として設定した数値、つまりエクサフロップス システムあたり 20 メガワットでした。」

そのエネルギー消費目標を達成するための明確な道筋はありませんでした。そこで 2012 年、DOE 科学局はベンダーと協力して新しいテクノロジーを推進する FastForward プログラムと DesignForward プログラムを開始しました。

FastForward は当初、パフォーマンス、消費電力、回復力の問題に対処するために、プロセッサ、メモリ、ストレージのベンダーに焦点を当てていました。その後、焦点をノード設計 (つまり、個々の計算サーバー) に移しました。DesignForward は当初、予想されるシステム サイズに合わせてネットワークを拡張することに重点を置き、その後、システム全体のパッケージ化、統合、エンジニアリングに重点を置きました。

FastForward への投資の結果、半導体チップ ベンダー AMD は、64 コアの第 3 世代 EPYC CPU と 4 つの Instinct MI250X GPU で構成される、Frontier 用のより高速で強力な計算ノードを開発し、GPU を製造する方法を見つけ出しました。使用されていないチップのセクションをオフにし、必要なときにわずか数ミリ秒でオンに戻すことで、より効率的になります。

「昔は、システム全体が点灯し、電気を燃やしながらアイドル状態に置かれていました。今では、GPU 全体だけでなく、使用されていないすべてのものをオフにすることができます。Frontier では、各 GPU に約 50 の異なる領域があります。使用していない場合は個別にオフにすることができるので、シリコン領域のほとんどが浮動小数点演算に充てられているだけでなく、実際、使用していないものにエネルギーを浪費するつもりはありません。」言った。

ただし、次世代のスーパーコンピューターでは、より新しく高度なアーキテクチャであっても、ワットあたりの計算量を増やすために単に GPU を追加し続けるだけでは、利益が逓減する段階に達している可能性があります。

「プロセッサ ベンダーは、ほんの小さな段階的な改善を実現する技術を考案するために、さまざまな工夫を凝らさなければなりません。そして、それはエネルギー効率だけでなく、パフォーマンスにも当てはまります。彼らは、ほぼすべてのことを実現しています。シリコンから最大限のパフォーマンスを引き出します」とアッチリー氏は語った。

「私たちはムーアの法則の恩恵を受けてきました。トランジスタはより小さくなり、より安くなり、より速くなりました。私たちのアプリケーションはより高速に動作し、価格帯は同じかそれ以下になりました。そんな世界は終わりました。世の中には、次のような技術がいくつかあります。いくつかの飛躍をもたらすかもしれませんが、私たちを助ける最大のことは、エネルギー効率に対するより統合された全体的なアプローチです。」

システム運用

OLCF の Analytics and AI Methods at Scale (AAIMS) グループのリーダー、Feiyi Wang 氏は、エネルギー消費量を削減してスーパーコンピューターを運用する方法というとらえどころのない目標について熟考することに多くの時間を費やしています。この問題に取り組むには、まず大量の HPC 運用データを収集する必要がありました。

Frontier が構築されるずっと前に、彼と AAIMS グループは、2018 年に発売された OLCF の 200 ペタフロップス スーパーコンピューターである Summit から 1 年以上の電力プロファイリング データを収集しました。Summit の 4,608 ノードにはそれぞれ、1 ヘルツでメトリクスを報告する 100 個を超えるセンサーが搭載されています。システムは毎秒 460,000 を超えるメトリクスを報告します。

ワン氏のチームは、この 10 テラバイトのデータセットを使用して、すべての冷却機械を備えた中央エネルギー プラントを含むサミットのシステム全体を端から端まで分析しました。システムのジョブ割り当て履歴をテレメトリ データに重ねて、840,000 を超えるジョブについてジョブごとのきめ細かい電力消費プロファイルを構築しました。この仕事により、彼らは最優秀論文賞2021 ハイパフォーマンス コンピューティング、ネットワーキング、ストレージ、分析に関する国際会議 (SC21) で。

この取り組みにより、Wang 氏はエネルギー効率を向上させるために情報に基づいた運用上の意思決定を行うためにそのようなデータをどのように使用できるかについて、いくつかのアイデアを思いつくようになりました。

Summit のエネルギー プロファイル データセットを使用して、Wang 氏と彼のチームは、HPC システムに対する継続的な生産に関する洞察を提供し、Wang 氏が言うように「データ駆動型の運用インテリジェンス」をシステム オペレーターに提供するための Smart Facility for Science プロジェクトを開始しました。

「私は、この継続的な監視を『継続的統合』にさらに一歩進めたいと考えています。つまり、コンピューターの継続的なメトリクスを取得してシステムに統合し、ユーザーが特定のエネルギー使用量がどのようになるかを観察できるようにしたいと考えています。」これをさらに進めて、単なる監視と統合から、その場で実際に作業を最適化する「継続的な最適化」も実装したいと考えています」と Wang 氏は述べています。

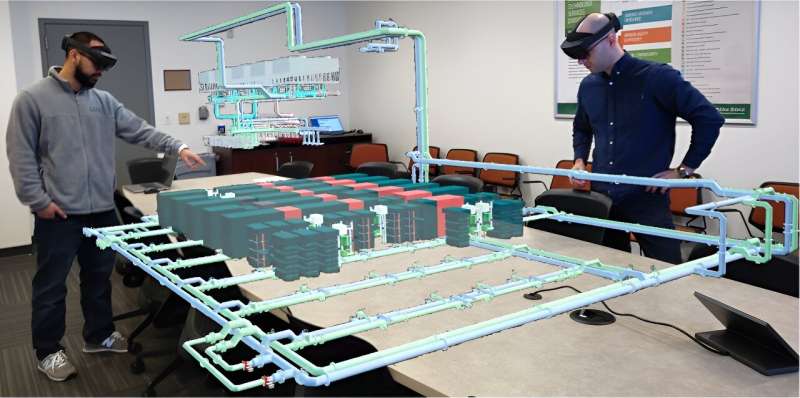

ワン氏の別のアイデアがその目標を助けるかもしれない。SC23 では、Wang 氏と、筆頭著者である AAIMS グループの上級研究員である Wes Brewer 氏が、「エクサスケール スーパーコンピュータの包括的なデジタル ツインの開発に向けて」と題したプレゼンテーションを行いました。彼らは、拡張現実 (AG) と仮想現実 (VR) を使用して、施設が全体的なエネルギー効率を向上させるためにどのように動作するかについての総合的な洞察を提供する、ExaDIGIT と呼ばれるフレームワークを提案しました。

現在、ExaDIGIT は 10 の国際パートナーおよび業界パートナーの共同プロジェクトに発展しており、Brewer はチームの成果を発表します。最新の論文でSC24ジョージア州アトランタで。

ORNL では、AAIMS グループが Frontier スーパーコンピューターのシミュレーションを構築する Digital Twin for Frontier プロジェクトを立ち上げました。この仮想フロンティアにより、オペレーターは「これを試したらどうなるか?」を実験することができます。実際の Frontier マシンで試す前に、省エネ シナリオを確認してください。Frontier の冷却システムの流入水の温度を上げたらどうなるでしょうか?効率は向上しますか?それとも、システムを十分に冷却できず、故障率が上昇する危険にさらしますか?

「Frontier は非常に価値のあるシステムなので、『試してみましょう。システムで実験しましょう』とは言えません。間違えると破壊的な結果になる可能性があるからです」と Wang 氏は言います。「しかし、このデジタル ツインのアイデアを使用すると、すべてのテレメトリ データをシステムに取り込むことができ、システムの電力と冷却の側面について十分な忠実度でモデル化されていれば、実験できるようになります。この設定を変更したらどうなるでしょうか?システムにプラスの影響を与えるかどうか?」

Frontier のデジタル ツインはデスクトップ コンピュータ上で実行でき、VR と AR を使用すると、オペレータはパラメータを調整するときに、よりインタラクティブかつ直感的な方法でシステム テレメトリを調べることができます。AAIMS グループは、デジタル ツインの電力消費と、ジョブの実行中に時間の経過とともにどのように進行するかを調べるための仮想スケジューリング システムも作成しました。

仮想フロンティアはまだ開発中ですが、ワークロードが冷却システムにどのような影響を与えるか、また、交流を直流に変換するプロセスである整流中に発生する電力損失で何が起こるかについての洞察がすでに得られています。このシステムは、Discovery の将来の電力と冷却のニーズを予測するためにも使用されています。

「私たちは、OLCFが直面する現在および将来の差し迫った課題に対処するために、開発とシステムを調整することができますし、そうするつもりです」とワン氏は語った。

施設インフラ

スーパーコンピューターの電源を入れるということは、単に電源を入れるだけではなく、それをサポートする施設全体に電源を入れることも意味します。最も重要なのは、データセンター内のすべてのコンピューターのキャビネットから発生する熱を除去する必要がある冷却システムです。

「10,000 フィートの視点から見ると、スーパーコンピューターは実際には単なる巨大なヒーターです。グリッドから電気を受け取り、この大きな箱に電気を流すと、電気を使用しているため熱くなります。今度は、さらに多くの電気を送り込む必要があります。エアコンを使って再び冷やして、溶けずに運転し続けることができるようにしました」とガイストさんは語った。

「データセンター内では、これらの大型マシンをより効率的に冷却するために多くの作業が行われています。2009 年から 2022 年までに、私たちは冷却に必要なエネルギーを 10 分の 1 に削減しました。私たちのチームは今後も冷却の最適化を続けます。」」

これらの冷却最適化の計画の多くは、ORNL の実験室近代化部門の主任 HPC 機械エンジニアである David Grant によって主導されています。グラントは、新しい機械設備の設計と建設を監督し、OLCF に設置されたすべての新しいスーパーコンピューター システムが 24 時間年中無休で確実に動作するために必要な冷却を確保することを主な責任としています。

彼は 2009 年に ORNL に入社し、Jaguar スーパーコンピューターの運用に取り組みました。その後、2012 年に Titan への移行に関与し、2018 年の立ち上げに向けて Summit のインフラストラクチャ設計を指揮し、最近では Frontier をサポートするすべてのエンジニアリングを監督しました。

その間に、OLCF の冷却システムはチップ テクノロジーとともに大幅に進化し、ジャガーの騒音ファンとチラーベースの空調から、フロンティアのファンなしの液体冷却へと変化しました。

さらに、計算ノードを冷却するために必要な水温は、Titan の 42°F から、FastForward プログラムによって設定された Frontier の目標である 90°F まで上昇しました。循環水を冷却する必要がなくなり、代わりに蒸発塔によって十分に冷却できるため、その余分な暖かさは大幅なエネルギー節約につながります。

「私たちは、最も温かい給水温度を提供しながら、キャビネットから可能な限り温かい水を回収しようとしています。供給温度は高いほど良いのです」とグラント氏は語った。

「温かい水が戻ってくることで、システムの施設側で循環させなければならない流量を最小限に抑えることができ、ポンピングエネルギーを節約できます。また、温度が暖かいため、冷却塔の効率が向上し、次のようなことが可能になります。」その熱を私たちの環境に拒否してください。」

Frontier の電力使用効率 (PUE) (コンピュータ データセンター施設で使用される総電力とコンピューティング機器に供給される電力の比率) は、ピーク使用時に 1.03 を実現しています。これは本質的に、システムの適切な熱エンベロープを維持するために、1,000 ワットの熱ごとにわずか 30 ワットの追加電力が必要であることを意味します。

データセンターの業界全体の世界平均は約 1.47 PUE です。アップタイム研究所によると。

Discovery のような高速システムで電力使用量をさらに削減するには、さらに革新的なアプローチが必要であり、Grant はそれを研究しています。

まず、ディスカバリーの余剰熱の一部を回収(または利用)するというコンセプトには、ある程度の期待が持てるかもしれない。この施設は、冷却システムから暖房システムに廃熱を移動できれば、廃熱を再利用するのに適した場所にあります。しかし、加熱システムの高温、冷却システムからの低級熱、および HPC システムによって生成される熱の非常に動的な性質のため、この作業は困難です。

第二に、次期 Discovery システムは Frontier の冷却システムを共有します。この併用構成により、さらなる運用効率の向上が期待されます。

「現在、フロンティアは独自の冷却システムを搭載しており、そのタイプの運用に合わせて最適化しています。しかし、フロンティアが最大 30 メガワットを要求し、別のシステムがおそらく再び同じくらいの電力を要求する場合、どうなるでしょうか。私たちの冷却システムに?

「それができるように設計されていますが、私たちは、これまで見たことのない、運用範囲内の異なる場所で運用することになります。したがって、そこに到達すると、新たな機会が現れるでしょう」」とグラント氏は語った。

第三に、グラント氏は、構造と機器の選択が施設全体のエネルギー効率にどのようなメリットをもたらすかを検討しています。たとえば、フロンティアの冷却システムには 20 個の個別の冷却塔があり、内部の金属表面を保護するために平準化と呼ばれるプロセスが必要であり、このプロセスには長時間にわたる大量のポンピングが含まれます。このステップは、平和化プロセスを必要としない新しいタワーを使用すれば省略できる可能性があります。

第 4 に、スーパーコンピューターのアイドル時間は大量の電力を消費する可能性があります。フロンティアのアイドル負荷は 7 ~ 8 メガワットです。そのアイドル負荷を大幅に軽減または排除できたらどうなるでしょうか?

「ソフトウェア面で影響力を持つ顧客と対話するとき、私たちは顧客の決定が冷却システムや施設のエネルギー使用にどのように反映されるかを伝えるよう努めています」とグラント氏は語った。

「アイドル状態の負荷要件を軽減し、モデルを可能な限り効率的に実行してシステムの使用率を高めようとするソフトウェア側には、多くの可能性があると思います。その見返りに、ソフトウェア側では、より高い生産性が得られるでしょう。」彼らが作成しようとしているデータです。」

アプリケーション

OLCF のスーパーコンピューター上でより効率的に実行できるように科学アプリケーションを最適化することは、NCCS の科学エンゲージメント部門の責任者である Tom Beck と、NCCS のアルゴリズムおよびパフォーマンス分析グループの著名な研究科学者である Trey White の領域です。コードがより速く結果を返すようにすることは、まったく新しい概念ではありませんが、現在では、目標は純粋な速度から変わりつつあります。

「長い間、人々は自分のコードをより高速に実行したいと考えてきました。そして、それが私たちが注力してきたことです。より高速なアプリケーションを実行するという唯一の目標は、偶然にもエネルギー使用量の削減にもつながりました。」とホワイト氏は述べました。

「ハードウェアは依然として速度が向上していますが、以前ほどではありません。そのため、今では時間とエネルギー効率の両方の観点からアプリケーションを検討する必要があります。ほとんどの場合、より高速に動作するということはエネルギーの削減を意味しますが、それは完璧ではありません」したがって、私たちは現在、この 2 つの間のトレードオフを検討し始めています。」

チームが調査している領域の 1 つは、GPU の動作周波数がエネルギー消費にどのような影響を与えるかということです。GPU が最速のスループットを達成するための最大周波数が、必ずしも最もエネルギー効率の高い周波数であるとは限りません。

「しかし、最大周波数で開始して 5% ~ 10% 引き下げると、20% または 25% のエネルギー節約が得られる可能性があるという兆候がいくつかあります。つまり、これは裁定取引であり、少しあきらめてもいいですか?大幅なエネルギー節約のためにパフォーマンスを少しでも活用してみてはいかがでしょうか?」ベックは言いました。

「以前は、コンピュータが使用する最大クロック周波数は、一般にすべてのプロジェクトに対して単一の数値に設定されていました。しかし現在は、それをアプリケーションごとに、場合によっては 1 回の実行内で適応させることを検討しています」と White 氏は述べています。「その『周波数ノブ』は、時間とエネルギー効率の間にトレードオフがあるものの 1 つの例であり、私たちはユーザーにその選択肢を与える方法を研究中です。」

チームが検討しているもう 1 つの領域は、混合精度演算の使用です。歴史的には、64 ビットの完全精度浮動小数点演算が科学アプリケーションにおける計算精度の標準と考えられていました。2000 年代初頭以降、スーパーコンピューターはますます強力になり、完全精度は 32 ビットの単精度演算とほぼ同じ速度で使用できるようになりました。

現在、AI 市場の台頭により、16 ビット以下の低精度演算が、ニューラル ネットワークやその他のデータ サイエンス アプリケーションのトレーニングに十分な精度であることが実証されました。GPU によって駆動される低精度の計算により、大幅な高速化とエネルギー節約が実現します。

「低い精度を使用することは、ユーザーにとって恐ろしい状況です。誰もが完全な精度の 64 ビットを想定することに慣れており、その理由の 1 つは、それがすでに存在し、アクセス可能であるという理由だけです」とベック氏は述べています。

「そして、64 ビットから逸脱し始めると、コード全体に非線形的な影響を与える可能性があり、何が起こっているかを追跡するのは非常に困難です。したがって、これは、64 ビットの影響について広範な研究を行うという私たちの研究戦略の一部です。」一部のアプリケーションでは混合精度演算が行われる予定です。」

エネルギー効率が向上する可能性があるもう 1 つの分野はデータ転送です。データの移動が少なくなればなるほど、必要な電力も少なくなります。この作業は、データの移動を減らすソフトウェア アルゴリズムを構築することで実現できます。Beck は、アルゴリズムのさまざまな操作ごとに使用される電力の割合を示す円グラフをユーザーに提供し、潜在的な削減を目標にできるようにしたいと考えています。

「根本的なハードウェアの変更やアーキテクチャの革命がなければ、アプリケーションは人々が今まさに求めている場所です。エネルギー効率「おそらく、これはコーディングを通じて 300% の改善を目指すゲームではありません。」とベック氏は言いました。

「改善できる箇所は確かにありますが、おそらくここで 3%、あそこで 5% という段階的なプロセスになるでしょう。しかし、それを大量の変更で蓄積して 20% に到達できれば、それは大きな成果です」達成。」

引用:コンピューター技術者がエネルギー効率の高いスーパーコンピューティングへのアプローチを開拓 (2024 年 9 月 11 日)2024 年 9 月 11 日に取得https://techxplore.com/news/2024-09-approaches-energy-efficient-supercomputing.html より

この文書は著作権の対象です。個人的な研究や研究を目的とした公正な取引を除き、書面による許可なく一部を複製することができます。コンテンツは情報提供のみを目的として提供されています。