A medida que las empresas de alta tecnología intensifican la construcción de enormes centros de datos para hacer frente al auge empresarial de la inteligencia artificial, un componente se está convirtiendo en un bien cada vez más escaso: la electricidad.

La demanda comercial de electricidad ha aumentado considerablemente en los últimos años y se prevé que aumente un 3% sólo en 2024, según la Administración de Información Energética de Estados Unidos.pero esoel crecimiento ha sido impulsado por sólo unos pocos estadosâlos que se están convirtiendo rápidamente en centros de instalaciones informáticas a gran escala, como Virginia y Texas.

El inventario de centros de datos norteamericanos creció un 24,4% interanual en el primer trimestre de 2024, tal y como informa la firma de servicios inmobiliarios CBRE en su estudio “Global Data Center Trends 2024”.Estos nuevos centros se están construyendo con capacidades de 100 a 1.000 megavatios, o aproximadamente las mismas cargas que pueden alimentar de 80.000 a 800.000 hogares, señala el Instituto de Investigación de Energía Eléctrica en unLibro blanco 2024.

En este documento, EPRI analiza el consumo de energía de los centros de datos y la IA y predice que si continúa una alta tasa de crecimiento proyectada del 10 % anual, los centros de datos consumirán anualmente hasta el 6,8 % de la generación total de electricidad de EE. UU. para 2030, frente a una estimación.4% hoy.

Para satisfacer esa creciente demanda, Goldman Sachs Research estima que las empresas de servicios públicos estadounidenses necesitarán invertir alrededor de 50 mil millones de dólares en nueva capacidad de generación eléctrica.Mientras tanto, la oposición comunitaria a la construcción de centros de datos en algunas áreas también está creciendo, a medida que grupos de base protestan por los posibles impactos locales de cada vez más centros de datos y sus crecientes demandas de electricidad para la IA y agua para refrigeración.

Que las empresas privadas del país puedan superar el enorme desafío de impulsar una "revolución" de la IA puede depender menos del dinero y más del ingenio.Ese estudio de CBRE concluye con una recomendación útil, o quizás esperanzadora: "La informática de alto rendimiento [o HPC] requerirá una rápida innovación en el diseño y la tecnología de los centros de datos para gestionar el aumentodensidad de potencianecesidades."

En Oak Ridge Leadership Computing Facility, una instalación para usuarios de la Oficina de Ciencias del Departamento de Energía ubicada en el Laboratorio Nacional de Oak Ridge, investigar nuevos enfoques para la supercomputación energéticamente eficiente siempre ha sido parte de su misión.

Desde su formación en 2004, la OLCF ha implementado cinco generaciones de sistemas de supercomputación de clase mundial que han producido un aumento de casi 2.000 veces en la eficiencia energética por operación de punto flotante por segundo, o flops.Frontier, la última supercomputadora de la OLCF, actualmenteocupa el primer lugar en la lista TOP500de los máscomputadoras poderosas, y en 2022 debutó en elen lo más alto de la lista Green500de las computadoras más eficientes energéticamente del mundo.

Mantener la factura de la luz a un precio asequible va de la mano con ser una instalación financiada por el gobierno.Pero la construcción y el mantenimiento de supercomputadoras de liderazgo ya no son dominio exclusivo del gobierno.Las principales empresas de tecnología han ingresado a la HPC a lo grande, pero recién ahora están comenzando a preocuparse por la cantidad de energía que consumen estos megasistemas.

"Nuestras máquinas siempre fueron las más grandes del planeta, pero eso ya no es cierto. Las empresas privadas ahora están implementando máquinas que son varias veces más grandes que las de Frontier. Hoy en día, esencialmente tienen bolsillos llenos ilimitados, por lo que les resulta fácil resistir".un centro de datos sin preocuparse por la eficiencia", dijo Scott Atchley, director de tecnología del Centro Nacional de Ciencias Computacionales, o NCCS, en ORNL."Eso cambiará una vez que tengan más limitaciones de poder y querrán sacar el máximo provecho de su inversión".

Con décadas de experiencia en hacer que HPC sea más eficiente desde el punto de vista energético, el OLCF puede servir como un recurso para las mejores prácticas de "beneficio mutuo" en una industria que repentinamente está floreciendo.

"Estamos en una posición única para influir en todo el ecosistema de eficiencia energética de HPC, desde las aplicaciones hasta el hardware y las instalaciones. Y se necesitan ganancias de eficiencia en esas tres áreas para atacar el problema", dijo Ashley Barker, directora del programa OLCF..

"El esfuerzo por mejorar la eficiencia energética entra en juego en todos los aspectos de nuestras instalaciones. ¿Cuál es el hardware más eficiente energéticamente que podemos comprar? ¿Cuál es la forma más eficiente energéticamente en que podemos ejecutar ese hardware? ¿Y cuáles son las formas más eficientes energéticamente?¿Hay formas eficientes de modificar las aplicaciones que se ejecutan en el hardware?"

Mientras el OLCF planifica su sucesor de Frontier, llamado Discovery, esas preguntas se hacen a diario mientras diferentes equipos trabajan juntos para entregar una nueva supercomputadora para 2028 que también demostrará eficiencias energéticas de próxima generación en HPC.

hardware del sistema

Uno de los avances en eficiencia computacional más importantes de los últimos 30 años tuvo su origen en una fuente poco probable: los videojuegos.

Más específicamente, la innovación provino de los fabricantes de chips que competían para satisfacer la necesidad de la industria de los videojuegos de contar con gráficos cada vez más sofisticados.Para lograr imágenes realistas que atraían a los jugadores, las computadoras personales y las consolas de juegos requerían chips dedicados, también conocidos como unidad de procesamiento de gráficos o GPU, para representar imágenes en movimiento detalladas.

Hoy en día, las GPU son una parte indispensable de la mayoría de las supercomputadoras, especialmente las que se utilizan para entrenar modelos de inteligencia artificial.En 2012, cuando la OLCF fue pionera en el uso de GPU en HPC de escala líder con su supercomputadora Titan, el diseño se consideró un cambio audaz de los sistemas tradicionales que dependen únicamente de unidades centrales de procesamiento o CPU.

Requirió que los científicos computacionales adaptaran sus códigos para explotar plenamente la capacidad de la GPU para realizar cálculos simples y acelerar el tiempo de solución.Cuanto menos tiempo le toma a una computadora resolver un problema particular, más problemas podrá resolver en un período de tiempo determinado.

"Una GPU es, por diseño, más eficiente energéticamente que una CPU. ¿Por qué es más eficiente? Si vas a conectar electricidad a una computadora y quieres que haga cálculos de manera muy eficiente, entonces querrás que casi toda la electricidad alimenteoperaciones de punto flotante. Desea que la mayor parte del área de silicio sean solo unidades de punto flotante, no todas las demás cosas que hay en cada chip de CPU.

"Una GPU es casi pura unidad de punto flotante. Cuando se hace funcionar electricidad en una máquina con GPU, se necesita aproximadamente una décima parte de la cantidad de energía que una máquina que sólo tiene CPU", dijo Al Geist de ORNL, director del proyecto Frontier.

La apuesta de la OLCF por las GPU en 2012 dio sus frutos durante la siguiente década con sistemas cada vez más eficientes energéticamente a medida que cada generación de supercomputadoras de la OLCF aumentaba su número de GPU más rápidas.Esta evolución culminó en la arquitectura de Frontier, lanzada en 2022 como la primera supercomputadora a exaescala del mundo, capaz de realizar más de 1 trillón de cálculos por segundo y que consta de 9.408 nodos de cómputo.

Sin embargo, cuando comenzaron las discusiones sobre exaescala en 2008, el Grupo de Estudio de Exaescala emitió un informe en el que se describían suscuatro grandes desafíos, el principal de los cuales fue el consumo de energía.Preveía una factura eléctrica de potencialmente 500 millones de dólares al año.Incluso teniendo en cuenta los avances tecnológicos proyectados para 2015, el informe predijo que un sistema simplificado de 1 exaflop utilizaría 150 megavatios de electricidad.

"El DOE dijo: 'Eso no es posible'.Bueno, preguntamos qué sería aceptable y la respuesta que recibimos fue: 'No queremos que gastes más dinero en electricidad que el costo de la máquina'", dijo Geist."En el año 2009, los superordenadores costaban unos 100 millones de dólares. Tienen una vida útil de unos cinco años.

"Lo que obtenemos al final son unos 20 millones de dólares al año que podríamos gastar en electricidad. ¿Cuántos megavatios puedo obtener de 20 millones de dólares? Resulta que 1 megavatio aquí en el este de Tennessee equivale a 1 millón de dólares al año, aproximadamente. Así que"Ésa es la cifra que nos propusimos como objetivo: un sistema de 20 megavatios por exaflop".

No había un camino claro para lograr ese objetivo de consumo de energía.Entonces, en 2012, la Oficina de Ciencias del DOE lanzó los programas FastForward y DesignForward para trabajar con proveedores para avanzar en nuevas tecnologías.

FastForward se centró inicialmente en los proveedores de procesadores, memoria y almacenamiento para abordar problemas de rendimiento, consumo de energía y resiliencia.Más tarde se centró en el diseño de nodos (es decir, el servidor informático individual).DesignForward se centró inicialmente en escalar redes a los tamaños de sistema previstos y luego se centró en el empaquetado, la integración y la ingeniería de todo el sistema.

Como resultado de la inversión en FastForward, el proveedor de chips semiconductores AMD desarrolló un nodo de cómputo más rápido y potente para Frontier, que consta de una CPU EPYC de tercera generación de 64 núcleos y cuatro GPU Instinct MI250X, y descubrió una manera de fabricar las GPU.más eficiente al apagar las secciones de los chips que no se están utilizando y luego volver a encenderlas cuando sea necesario en tan solo unos milisegundos.

"En los viejos tiempos, todo el sistema se encendía y permanecía inactivo, todavía quemando electricidad. Ahora podemos apagar todo lo que no se está utilizando, y no solo una GPU completa. En Frontier, alrededor de 50 áreas diferentes en cada GPU"Se pueden apagar individualmente si no se usan. Ahora, no sólo el área de silicio está dedicada principalmente a operaciones de punto flotante, sino que, de hecho, no voy a desperdiciar energía en nada que no esté usando", Geist.dicho.

Sin embargo, con la próxima generación de supercomputadoras, el simple hecho de seguir agregando más GPU para lograr más cálculos por vatio puede haber llegado a un punto de rendimiento decreciente, incluso con arquitecturas más nuevas y avanzadas.

"Los proveedores de procesadores realmente tendrán que buscar en su bolsa de trucos para idear técnicas que les proporcionen sólo pequeñas mejoras incrementales. Y eso no sólo es cierto para la eficiencia energética, sino también para el rendimiento.obtener el mayor rendimiento posible del silicio", dijo Atchley.

"Nos hemos beneficiado de la Ley de Moore: los transistores se hicieron más pequeños, más baratos y más rápidos. Nuestras aplicaciones se ejecutaron más rápido y el precio fue el mismo o menor. Ese mundo se acabó. Existen algunas tecnologías posibles quePodría darnos algunos avances, pero lo más importante que nos ayudará es un enfoque más integrado y holístico de la eficiencia energética".

Operaciones del sistema

Feiyi Wang, líder del grupo de Métodos de análisis e inteligencia artificial a escala (AAIMS, por sus siglas en inglés) de la OLCF, ha pasado gran parte de su tiempo reflexionando sobre un objetivo difícil de alcanzar: cómo operar una supercomputadora para que utilice menos energía.Para abordar este problema, primero fue necesario reunir una enorme cantidad de datos operativos de HPC.

Mucho antes de que se construyera Frontier, él y el grupo AAIMS recopilaron más de un año de datos de perfiles de energía de Summit, la supercomputadora de 200 petaflops de OLCF lanzada en 2018. Los 4.608 nodos de Summit tienen cada uno más de 100 sensores que informan métricas a 1 hercio, lo que significa quepor cada segundo, el sistema informa más de 460.000 métricas.

Utilizando este conjunto de datos de 10 terabytes, el equipo de Wang analizó todo el sistema de Summit de un extremo a otro, incluida su planta de energía central, que contiene toda su maquinaria de refrigeración.Superpusieron el historial de asignación de trabajos del sistema en los datos de telemetría para construir perfiles detallados de consumo de energía por trabajo para más de 840.000 trabajos.Este trabajo les valió elPremio al mejor artículoen la Conferencia Internacional de Computación, Redes, Almacenamiento y Análisis de Alto Rendimiento de 2021, o SC21.

El esfuerzo también llevó a Wang a proponer algunas ideas sobre cómo se pueden utilizar esos datos para tomar decisiones operativas informadas para una mejor eficiencia energética.

Utilizando los conjuntos de datos de perfil energético de Summit, Wang y su equipo iniciaron el proyecto Smart Facility for Science para proporcionar información sobre la producción continua de los sistemas HPC y brindar a los operadores de sistemas "inteligencia operativa basada en datos", como dice Wang.

"Quiero llevar este monitoreo continuo un paso más allá hacia la 'integración continua', lo que significa que queremos tomar las métricas continuas de la computadora e integrarlas en un sistema para que el usuario pueda observar cómo será su uso de energía para su situación particular.solicitud de empleo. Llevando esto más allá, también queremos implementar una "optimización continua", pasando de simplemente monitorear e integrar a optimizar el trabajo sobre la marcha", dijo Wang.

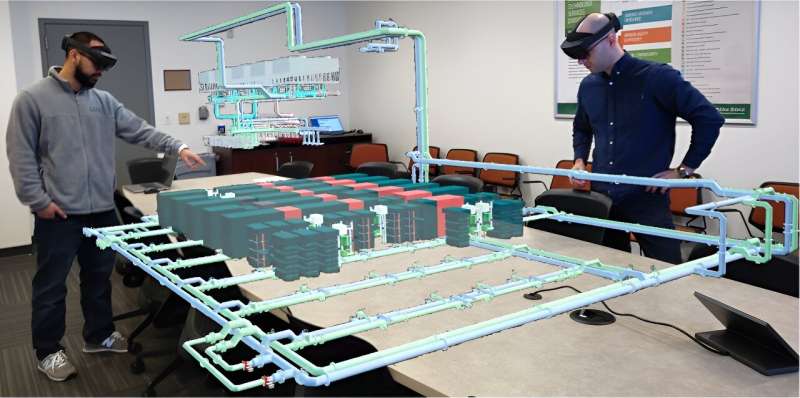

Otra de las ideas de Wang puede ayudar a lograr ese objetivo.En SC23, Wang y el autor principal Wes Brewer, científico investigador senior del grupo AAIMS, realizaron una presentación, "Hacia el desarrollo de un gemelo digital integral de una supercomputadora a exaescala".Propusieron un marco llamado ExaDIGIT que utiliza realidad aumentada, o AG, y realidad virtual, o VR, para proporcionar información holística sobre cómo opera una instalación para mejorar su eficiencia energética general.

Ahora, ExaDIGIT se ha convertido en un proyecto colaborativo de 10 socios industriales e internacionales, y Brewer presentará el trabajo del equipo.papel más nuevoenSC24en Atlanta, Georgia.

En ORNL, el grupo AAIMS lanzó el proyecto Digital Twin for Frontier para construir una simulación de la supercomputadora Frontier.Esta Frontera virtual permitirá a los operadores experimentar con "¿Qué pasaría si intentáramos esto?"escenarios de ahorro de energía antes de intentarlos en la máquina Frontier real.¿Qué pasaría si aumentaras la temperatura del agua entrante al sistema de enfriamiento de Frontier? ¿Eso aumentaría su eficiencia?¿O lo pondrá en riesgo de no enfriar el sistema lo suficiente, aumentando así su tasa de fallas?

"Frontier es un sistema tan valioso que no se puede decir simplemente: 'Probémoslo. Experimentemos con el sistema', porque las consecuencias pueden ser destructivas si se equivoca", afirmó Wang."Pero con esta idea de gemelo digital, podemos llevar todos esos datos de telemetría a un sistema donde, si tenemos suficiente fidelidad modelada para los aspectos de energía y enfriamiento del sistema, podemos experimentar. ¿Qué pasa si cambio esta configuración?"¿Tiene un efecto positivo en el sistema o no?

El gemelo digital de Frontier se puede ejecutar en una computadora de escritorio y el uso de VR y AR permite a los operadores examinar la telemetría del sistema de una manera más interactiva e intuitiva a medida que ajustan los parámetros.El grupo AAIMS también creó un sistema de programación virtual para examinar el consumo de energía del gemelo digital y cómo progresa con el tiempo a medida que realiza trabajos.

Aunque la Frontier virtual aún se está desarrollando, ya está brindando información sobre cómo las cargas de trabajo pueden afectar su sistema de enfriamiento y qué sucede con las pérdidas de energía que ocurren durante la rectificación, que es el proceso de convertir corriente alterna en corriente continua.El sistema también se utiliza para predecir las necesidades futuras de energía y refrigeración del Discovery.

"Podemos y adaptaremos nuestro desarrollo, así como el sistema, para abordar cualquier desafío apremiante actual y futuro que enfrente la OLCF", dijo Wang.

Infraestructura de las instalaciones

Alimentar una supercomputadora no significa simplemente encenderla, sino que también significa alimentar toda la instalación que la sustenta.Lo más crítico es el sistema de refrigeración que debe eliminar el calor generado por todos los gabinetes de la computadora en su centro de datos.

"Desde un punto de vista de 10.000 pies, una supercomputadora es en realidad sólo un calentador gigante: tomo electricidad de la red, la introduzco en esta caja grande y se calienta porque usa electricidad. Ahora tengo que hacer funcionar más electricidad enaire acondicionado para enfriarlo nuevamente y así poder mantenerlo funcionando y no se derrita", dijo Geist.

"Dentro del centro de datos hay mucho trabajo para enfriar estas grandes máquinas de manera más eficiente. De 2009 a 2022, hemos reducido 10 veces la energía necesaria para el enfriamiento y nuestro equipo continuará optimizando el enfriamiento en el futuro."

Gran parte de la planificación para esas optimizaciones de refrigeración está dirigida por David Grant, ingeniero mecánico líder de HPC en la División de Modernización de Laboratorios de ORNL.Grant supervisa el diseño y la construcción de nuevas instalaciones mecánicas y es el principal responsable de garantizar que cada nuevo sistema de supercomputadora instalado en el OLCF tenga la refrigeración que necesita para funcionar de manera confiable las 24 horas del día, los 7 días de la semana.

Comenzó en ORNL en 2009 y trabajó en operaciones para la supercomputadora Jaguar.Luego, participó en su transición a Titan en 2012, dirigió el diseño de infraestructura de Summit para su lanzamiento en 2018 y, más recientemente, supervisó toda la ingeniería para respaldar a Frontier.

En ese lapso de tiempo, los sistemas de enfriamiento de OLCF han evolucionado sustancialmente junto con la tecnología de chips, pasando de ventiladores ruidosos y aire acondicionado basado en enfriadores en Jaguar a enfriamiento líquido sin ventilador en Frontier.

Además, las temperaturas del agua necesarias para enfriar los nodos de cómputo han aumentado de 42 °F en Titán a 90 °F en Frontier, un objetivo establecido por el programa FastForward.Ese calor adicional genera enormes ahorros de energía porque el agua en circulación ya no necesita ser refrigerada y, en su lugar, puede enfriarse lo suficiente mediante torres de evaporación.

"Estamos tratando de obtener el agua más caliente posible de los gabinetes y al mismo tiempo suministrarles las temperaturas de suministro de agua más cálidas; cuanto más altas sean las temperaturas del suministro, mejor", dijo Grant.

"El agua más caliente que regresa a nosotros nos permite minimizar el flujo que tenemos que circular en el lado de las instalaciones del sistema, lo que ahorra energía de bombeo. Y luego las temperaturas más cálidas nos permiten ser más eficientes con nuestras torres de enfriamiento para poderRechazar ese calor a nuestro medio ambiente."

La efectividad del uso de energía de Frontier, o PUE (la relación entre la energía total utilizada por una instalación de centro de datos informáticos y la energía entregada a los equipos informáticos) es de 1,03 en el uso máximo.Básicamente, esto significa que por cada 1.000 vatios de calor, sólo se necesitan 30 vatios de energía eléctrica adicional para mantener la envoltura térmica adecuada del sistema.

El promedio global de la industria para los centros de datos es de alrededor de 1,47 PUE,según el Instituto Uptime.

Para lograr mayores reducciones en el uso de energía para un sistema más rápido como Discovery se necesitarán enfoques aún más innovadores, algo que Grant está investigando.

En primer lugar, el concepto de recuperar (o utilizar) parte del exceso de calor del Discovery puede resultar prometedor.La instalación está bien situada para reutilizar el calor residual si se puede trasladar del sistema de refrigeración al sistema de calefacción.Pero esta tarea es un desafío debido a las elevadas temperaturas del sistema de calefacción, el calor de baja calidad del sistema de enfriamiento y la naturaleza altamente dinámica del calor generado por los sistemas HPC.

En segundo lugar, el sistema Discovery entrante compartirá el sistema de refrigeración de Frontier.Se esperan eficiencias operativas adicionales de esta configuración de uso combinado.

"En este momento, Frontier tiene su propio sistema de enfriamiento y lo hemos optimizado para ese tipo de operación. Pero si tienes a Frontier exigiendo hasta 30 megavatios y luego otro sistema exigiendo tal vez esa misma cantidad nuevamente, ¿qué significa eso?a nuestro sistema de refrigeración?

"Está diseñado para poder hacer eso, pero vamos a operar en un lugar diferente en su envoltura operativa que no hemos visto antes. Por lo tanto, se presentarán nuevas oportunidades una vez que lleguemos allí.", dijo Grant.

En tercer lugar, Grant está examinando cómo las opciones de construcción y equipamiento pueden beneficiar la eficiencia energética general de la instalación.Por ejemplo, el sistema de enfriamiento de Frontier tiene 20 torres de enfriamiento individuales que requieren un proceso llamado pacificación para ayudar a proteger sus superficies metálicas internas, y este proceso implica mucho bombeo a lo largo del tiempo.Ese paso podría eliminarse con torres más nuevas que ya no requieran el proceso de pacificación.

Cuarto, el tiempo de inactividad en una supercomputadora puede consumir una gran cantidad de electricidad: las cargas inactivas de Frontier son de 7 a 8 megavatios.¿Qué pasaría si esa carga inactiva pudiera reducirse o eliminarse en gran medida?

"Cuando interactuamos con los clientes que tienen influencia en el lado del software, tratamos de comunicarles cómo sus decisiones se traducirán en el sistema de enfriamiento y en el uso de energía de las instalaciones", dijo Grant.

"Creo que hay mucho potencial en el lado del software para tratar de reducir el requisito de carga inactiva y hacer que sus modelos funcionen lo más eficientemente posible y aumentar la utilización del sistema. A cambio, obtendrán una mayor producción de su parte para eldatos que están tratando de producir".

Aplicaciones

La optimización de las aplicaciones científicas para que se ejecuten de manera más eficiente en las supercomputadoras del OLCF es el dominio de Tom Beck, jefe de la sección de Participación Científica del NCCS, y Trey White, un distinguido científico investigador del grupo de Algoritmos y Análisis de Rendimiento del NCCS.Lograr que los códigos devuelvan sus resultados más rápido no es exactamente un concepto nuevo, pero el objetivo ahora es alejarse de la pura velocidad.

"Durante mucho tiempo, la gente ha querido hacer que sus códigos se ejecuten más rápido, y eso es en lo que nos hemos concentrado: ese objetivo singular de ejecutar aplicaciones más rápidas, lo que también reduce el uso de energía", dijo White.

"La velocidad del hardware sigue aumentando, aunque no tan rápido como antes, por lo que ahora debemos analizar las aplicaciones en términos de tiempo y eficiencia energética. En su mayor parte, correr más rápido significa menos energía, pero no es una solución perfecta".correlación".

Un área que el equipo está investigando es cómo la frecuencia operativa de las GPU puede afectar su consumo de energía.La frecuencia máxima para que una GPU alcance su rendimiento más rápido puede no ser necesariamente la frecuencia con mayor eficiencia energética.

"Pero si comienzas con la frecuencia máxima y retrocedes entre un 5% y un 10%, hay algunos indicios de que podrías obtener un ahorro de energía del 20% o el 25%. Entonces, es un arbitraje: ¿estás dispuesto a renunciar a un poco?".parte de su rendimiento para obtener grandes ahorros de energía?"dijo Beck.

"Anteriormente, la frecuencia máxima de reloj que utiliza la computadora se establecía para todos los proyectos en un solo número, en general. Pero ahora estamos buscando adaptar eso por aplicación y tal vez incluso dentro de una sola ejecución", dijo White."Ese 'perilla de frecuencia' es un ejemplo de algo en lo que existe un equilibrio entre tiempo y eficiencia energética, y estamos investigando cómo darles a los usuarios esa opción".

Otra área que el equipo está explorando es el uso de la aritmética de precisión mixta.Históricamente, la aritmética de coma flotante de máxima precisión a 64 bits se consideraba el estándar para la precisión computacional en aplicaciones científicas.Las supercomputadoras cada vez más potentes desde principios de la década de 2000 hicieron que la precisión total fuera casi tan rápida de usar como la aritmética de precisión simple a 32 bits.

Ahora, con el auge del mercado de la IA, la aritmética de baja precisión (16 bits o menos) ha demostrado que es lo suficientemente precisa para entrenar redes neuronales y otras aplicaciones de ciencia de datos.Impulsados por GPU, los cálculos de baja precisión pueden ofrecer importantes aceleraciones y ahorros de energía.

"El uso de una precisión más baja es un panorama aterrador para los usuarios porque todo el mundo está acostumbrado a asumir 64 bits de precisión total y en parte simplemente porque ya está ahí y es accesible", dijo Beck.

"Y si comienzas a desviarte de los 64 bits, podrías afectar las cosas de maneras no lineales en todo tu código, donde es realmente difícil rastrear lo que está sucediendo. Así que eso es parte de nuestra estrategia de investigación: hacer un estudio amplio de los impactos derecurriendo a la aritmética de precisión mixta en algunas aplicaciones".

Otra área que puede generar aumentos en la eficiencia energética es la transferencia de datos: cuanto menor sea el movimiento de datos, menos electricidad se necesitará.Este trabajo podría lograrse mediante la construcción de algoritmos de software que reduzcan el movimiento de datos.A Beck le gustaría ofrecer a los usuarios gráficos circulares que muestren los porcentajes de potencia utilizados por cada operación diferente de un algoritmo, permitiéndoles así apuntar a posibles reducciones.

"Sin un cambio radical de hardware o una revolución en la arquitectura, las aplicaciones son realmente el lugar que la gente busca ahora para aumentareficiencia energética", dijo Beck. "Lo más probable es que este no sea un juego de obtener una mejora del 300% a través de la codificación.

"Definitivamente hay lugares donde podemos hacer mejoras, pero probablemente será un proceso más incremental del 3% aquí, 5% allá. Pero si puedes acumular eso en una serie de cambios y llegar al 20%, eso es un gran avance".logro."

Citación:Los ingenieros informáticos son pioneros en enfoques para la supercomputación energéticamente eficiente (2024, 11 de septiembre)recuperado el 11 de septiembre de 2024de https://techxplore.com/news/2024-09-approaches-energy-ficient-supercomputing.html

Este documento está sujeto a derechos de autor.Aparte de cualquier trato justo con fines de estudio o investigación privados, noparte puede ser reproducida sin el permiso por escrito.El contenido se proporciona únicamente con fines informativos.