ウォータールー大学を拠点とする研究者チームは、ChatGPT のような大規模言語モデル (LLM) がどこから情報を取得しているのか、そしてその情報が信頼できるかどうかを明らかにする新しいツール (愛称「RAGE」) を作成しました。

ChatGPT のような LLM は「教師なし深層学習」に依存しており、プログラマーやユーザーが解読するのが難しい方法でインターネット全体に接続して情報を吸収します。さらに、LLM は「幻覚」を起こしやすい傾向があります。つまり、LLM は概念や内容について説得力のある文章を書きます。ソースそれは間違っているか、存在しません。

「LLM がそれ自体を説明するということを必ずしも信頼できるわけではありません」と、ウォータールー大学のコンピューターサイエンス博士、ジョエル・ローセス氏は言う。研究の学生であり筆頭著者。またでっちあげの説明や引用が記載されている可能性があります。

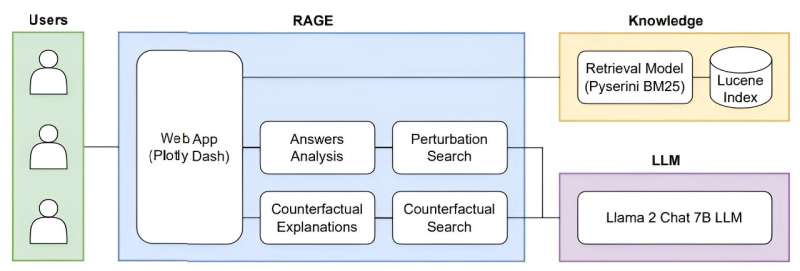

Rorseth チームの新しいツールは、特定のプロンプトに対する LLM の回答のコンテキストを理解するために、「検索拡張生成」(RAG) と呼ばれる最近開発された戦略を採用しています。

「RAGを使用すると、ユーザーはコンテキストを得るためにLLMに独自のソースを提供できます。私たちのツールは、RAGを使用するときにソースが異なると異なる答えがどのように得られるかを示し、その情報が信頼できるかどうかを評価するのに役立ちます」とRorseth氏は述べています。

彼らのツールは検索拡張生成の説明可能性に重点を置いているため、「マシンに対する「激怒」」というニックネームが付けられました。

ChatGPT のような LLM がどこで情報を取得しているかを理解し、それらが繰り返されていないことを確認する誤報ローセス氏は、医療や法律分野などの非常に機密性の高い人間中心の業界がこれらのツールを採用するにつれて、その重要性はさらに高まるだろうと述べた。

「私たちは現在、イノベーションが規制を上回っている状況にいます」と同氏は語った。「人々は潜在的なリスクを理解せずにこれらのテクノロジーを使用しているため、これらの製品が安全で、信頼でき、信頼できるものであることを確認する必要があります。」

この研究「RAGE Against the Machine: Retrieval-Augmented LLM Explains」は、第 40 回 IEEE International Conference on Data Engineering の論文集に掲載される予定です。現在は利用可能でarXivプレプリントサーバー。

詳細情報:Joel Rorseth 他、RAGE Against the Machine: 検索拡張 LLM の説明、arXiv(2024年)。DOI: 10.48550/arxiv.2405.13000

雑誌情報: arXiv

引用:ソースを知る: RAGE ツールが ChatGPT のソースを公開 (2024 年 6 月 4 日)2024 年 6 月 4 日に取得https://techxplore.com/news/2024-06-source-rage-tool-unveils-chatgpt.html より

この文書は著作権の対象です。個人的な研究や研究を目的とした公正な取引を除き、書面による許可なく一部を複製することができます。コンテンツは情報提供のみを目的として提供されています。