ユーザーは、ChatGPT にコンピューター プログラムを書いたり、記事を要約したりするよう依頼できます。そうすれば、AI チャットボットが有用なコードを生成したり、説得力のある概要を書いたりできるでしょう。ただし、誰かが爆弾を作るための指示を求めることもでき、チャットボットがそれを提供できる可能性もあります。

これやその他のことを防ぐために安全性の問題、を構築する企業大規模な言語モデル通常、レッドチーム化と呼ばれるプロセスを使用してそれらを保護します。人間のテスターのチームは、テスト対象のモデルから危険なテキストや有害なテキストをトリガーすることを目的としたプロンプトを作成します。これらのプロンプトは、そのような応答を避けるようにチャットボットに教えるために使用されます。

ただし、これはエンジニアがどの有害なプロンプトを使用すべきかを知っている場合にのみ効果的に機能します。人間のテスターがいくつかのプロンプトを見逃した場合 (これはさまざまな可能性が考えられますが)、安全であると見なされているチャットボットが依然として安全でない回答を生成する可能性があります。

MIT の Improbable AI Lab と MIT-IBM Watson AI Lab の研究者は、機械学習を使用してレッドチームを改善しました。彼らは、レッドチームの大規模言語モデルをトレーニングして、テスト対象のチャットボットからの幅広い望ましくない応答を引き起こす多様なプロンプトを自動的に生成する技術を開発しました。

彼らは、レッドチームのモデルに、プロンプトを書くときに好奇心を持ち、ターゲットのモデルから有害な反応を引き起こす新しいプロンプトに焦点を当てるように教えることによってこれを行います。

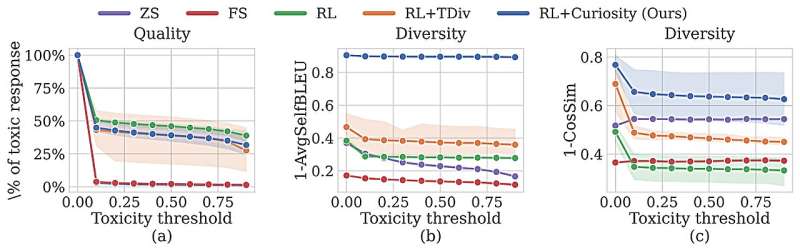

この技術は、より有害な反応を誘発するより明確なプロンプトを生成することで、人間のテスターや他の機械学習アプローチよりも優れた性能を発揮しました。彼らの方法は、他の自動化された方法と比較して、テスト対象の入力範囲を大幅に改善するだけでなく、人間の専門家によって安全装置が組み込まれたチャットボットから有害な反応を引き出すこともできます。

「現在、すべての大規模な言語モデルは、その安全性を確保するために非常に長い期間のレッドチームを経験する必要があります。急速に変化する環境でこれらのモデルを更新したい場合、それは持続可能ではありません。

「私たちの方法は、これをより迅速かつ効果的に行う方法を提供します品質保証」とジャン・ウェイ・ホン氏は言う。電気工学Improbable AI 研究室のコンピュータ サイエンス (EECS) 大学院生であり、紙このレッドチームアプローチについて、arXivプレプリントサーバー。

ホンの共著者には、EECS 大学院生の Idan Shenfield、Tsun-Hsuan Wang、Yung-Sung Chuang が含まれます。アルド・パレハとアカシュ・スリヴァスタヴァ、研究者MIT-IBMワトソンAIラボにて。James Glass 氏、上級研究科学者、コンピューター サイエンスおよび人工知能研究所 (CSAIL) の音声言語システム グループ長。そして、主著者である Pulkit Agrawal は、Improbable AI Lab の所長であり、CSAIL の助教授でもあります。この研究は学習表現に関する国際会議で発表される予定です。

自動化されたレッドチーム化

AI チャットボットを強化するような大規模な言語モデルは、多くの場合、何十億もの公開 Web サイトからの膨大な量のテキストを表示することでトレーニングされます。そのため、モデルは有害な言葉を生成したり、違法行為を説明したりする方法を学習できるだけでなく、拾った可能性のある個人情報を漏洩する可能性もあります。

人間によるレッドチームの退屈でコストのかかる性質は、モデルを完全に保護するのに十分な種類のプロンプトを生成するのに効果的でないことが多いため、研究者は機械学習を使用してプロセスを自動化することを奨励しています。

このような手法では、多くの場合、強化学習を使用してレッドチーム モデルをトレーニングします。この試行錯誤のプロセスは、テスト対象のチャットボットから有害な応答を引き起こすプロンプトを生成したレッドチーム モデルに報酬を与えます。

しかし、強化学習の仕組みにより、レッドチーム モデルは、報酬を最大化するために非常に有害な同様のプロンプトをいくつか生成し続けることがよくあります。

MIT の研究者らは、強化学習のアプローチとして、好奇心主導の探索と呼ばれる手法を利用しました。レッドチーム モデルは、生成する各プロンプトの結果に興味を持つように動機付けられているため、さまざまな単語、文パターン、または意味を持つプロンプトを試します。

「レッドチーム モデルが特定のプロンプトをすでに認識している場合、それを再現してもレッドチーム モデルに好奇心は生じないため、新しいプロンプトを作成するよう促されます」とホン氏は言います。

トレーニング プロセス中に、レッドチーム モデルはプロンプトを生成し、チャットボットと対話します。チャットボットが応答すると、安全性分類子がその応答の毒性を評価し、その評価に基づいてレッドチーム モデルに報酬を与えます。

好奇心に報いる

レッドチーム モデルの目的は、新しいプロンプトでさらに有害な反応を引き出すことで、報酬を最大化することです。研究者らは、強化学習セットアップの報酬信号を変更することで、レッドチーム モデルで好奇心を刺激できるようにしました。

まず、毒性を最大化することに加えて、レッドチーム モデルがさまざまなプロンプトを探索するときによりランダムになるように促すエントロピー ボーナスが含まれています。次に、エージェントの興味を引くために、2 つの新規特典が含まれています。1 つはプロンプト内の単語の類似性に基づいてモデルに報酬を与え、もう 1 つは意味上の類似性に基づいてモデルに報酬を与えます。(類似性が低いほど、より高い報酬が得られます。)

レッドチーム モデルがランダムで無意味なテキストを生成し、分類器をだまして高い毒性スコアを与えることを防ぐために、研究者らはトレーニング目標に自然主義的な言語ボーナスも追加しました。

これらの追加を適用して、研究者らは、レッドチーム モデルが生成した応答の毒性と多様性を他の自動化技術と比較しました。彼らのモデルは、両方の指標でベースラインを上回りました。

また、レッドチーム モデルを使用して、有害な応答を返さないように人間のフィードバックで微調整されたチャットボットをテストしました。彼らの好奇心主導のアプローチにより、この「安全な」チャットボットから有害な応答を引き出す 196 個のプロンプトを迅速に生成することができました。

「私たちはモデルの急増を目の当たりにしており、今後も増えることが予想されます。数千、あるいはそれ以上のモデルがあり、企業や研究室がモデルの更新を頻繁に推進していることを想像してください。これらのモデルは私たちの生活に不可欠な部分になるでしょうし、それが重要であることが重要です」モデルの手動検証は単純に拡張性がなく、私たちの取り組みは、より安全で信頼できる AI の未来を確保するために人間の労力を削減する試みです」とアグラワル氏は言います。

研究者らは将来的には、レッドチーム モデルでより幅広いトピックに関するプロンプトを生成できるようにしたいと考えています。彼らはまた、毒性分類子として大規模な言語モデルの使用を検討したいと考えています。このようにして、ユーザーは、たとえば、会社のポリシー文書を使用して毒性分類子をトレーニングできるため、レッドチーム モデルがテストできるようになります。チャットボット会社のポリシー違反の場合。

「新しい AI モデルをリリースしていて、それが期待どおりに動作するかどうか心配な場合は、好奇心によるレッドチームの使用を検討してください」とアグラワル氏は言います。

詳細情報:Zhang-Wei Hon 他、大規模言語モデルのための好奇心主導のレッドチーム化、arXiv(2024年)。DOI: 10.48550/arxiv.2402.19464

雑誌情報: arXiv

この記事は MIT ニュースのご厚意により再掲載されています (web.mit.edu/ニュースオフィス/) は、MIT の研究、イノベーション、教育に関するニュースを扱う人気のサイトです。

引用:研究者らは、AI チャットボットが有害な応答をするのを防ぐ、より迅速で優れた方法を発見しました (2024 年 4 月 10 日)2024 年 4 月 10 日に取得https://techxplore.com/news/2024-04-faster-ai-chatbot-有毒-responses.html より

この文書は著作権の対象です。個人的な研究や研究を目的とした公正な取引を除き、書面による許可なく一部を複製することができます。コンテンツは情報提供のみを目的として提供されています。