Un usuario podría pedirle a ChatGPT que escriba un programa de computadora o resuma un artículo, y el chatbot de IA probablemente podría generar código útil o escribir una sinopsis convincente.Sin embargo, alguien también podría pedir instrucciones para construir una bomba, y el chatbot también podría proporcionárselas.

Para prevenir esto y otroscuestiones de seguridad, empresas que construyengrandes modelos de lenguajePor lo general, los protege mediante un proceso llamado equipo rojo.Equipos de evaluadores humanos escriben indicaciones destinadas a activar textos inseguros o tóxicos en el modelo que se está probando.Estas indicaciones se utilizan para enseñarle al chatbot a evitar este tipo de respuestas.

Pero esto sólo funciona eficazmente si los ingenieros saben qué indicaciones tóxicas utilizar.Si los evaluadores humanos omiten algunas indicaciones, lo que probablemente se deba a la cantidad de posibilidades, un chatbot considerado seguro aún podría ser capaz de generar respuestas inseguras.

Investigadores del Improbable AI Lab del MIT y del MIT-IBM Watson AI Lab utilizaron el aprendizaje automático para mejorar el equipo rojo.Desarrollaron una técnica para entrenar un modelo de lenguaje grande del equipo rojo para generar automáticamente diversos mensajes que desencadenen una gama más amplia de respuestas indeseables del chatbot que se está probando.

Lo hacen enseñando al modelo del equipo rojo a tener curiosidad cuando escribe indicaciones y a centrarse en indicaciones novedosas que evocan respuestas tóxicas del modelo objetivo.

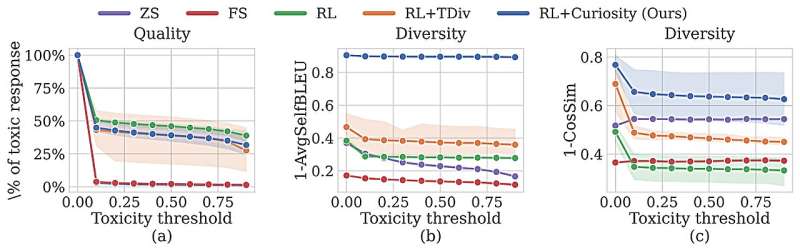

La técnica superó a los probadores humanos y otros enfoques de aprendizaje automático al generar indicaciones más distintas que provocaron respuestas cada vez más tóxicas.Su método no solo mejora significativamente la cobertura de las entradas que se prueban en comparación con otros métodos automatizados, sino que también puede generar respuestas tóxicas de un chatbot que tenía salvaguardas integradas por expertos humanos.

"En este momento, cada modelo de lenguaje grande tiene que pasar por un período muy largo de formación de equipos rojos para garantizar su seguridad. Eso no será sostenible si queremos actualizar estos modelos en entornos que cambian rápidamente.

"Nuestro método proporciona una forma más rápida y eficaz de hacer esto.seguro de calidad", dice Zhang-Wei Hong, unelectrotecniay estudiante de posgrado en ciencias de la computación (EECS) en el laboratorio de IA Improbable y autor principal de unpapelsobre este enfoque de equipo rojo publicado en elarXivservidor de preimpresión.

Los coautores de Hong incluyen a los estudiantes graduados de EECS Idan Shenfield, Tsun-Hsuan Wang y Yung-Sung Chuang;Aldo Pareja y Akash Srivastava,científicos investigadoresen el Laboratorio de IA Watson del MIT-IBM;James Glass, científico investigador senior y jefe del Grupo de Sistemas de Lenguaje Hablado en el Laboratorio de Ciencias de la Computación e Inteligencia Artificial (CSAIL);y el autor principal Pulkit Agrawal, director de Improbable AI Lab y profesor asistente en CSAIL.La investigación se presentará en la Conferencia Internacional sobre Representaciones del Aprendizaje.

Equipo rojo automatizado

Los grandes modelos de lenguaje, como los que impulsan los chatbots de IA, a menudo se entrenan mostrándoles enormes cantidades de texto de miles de millones de sitios web públicos.Por lo tanto, no sólo pueden aprender a generar palabras tóxicas o describir actividades ilegales, sino que los modelos también podrían filtrar información personal que puedan haber recopilado.

La naturaleza tediosa y costosa del equipo rojo humano, que a menudo es ineficaz para generar una variedad lo suficientemente amplia de indicaciones para salvaguardar completamente un modelo, ha alentado a los investigadores a automatizar el proceso utilizando el aprendizaje automático.

Estas técnicas suelen entrenar un modelo de equipo rojo mediante el aprendizaje por refuerzo.Este proceso de prueba y error recompensa al modelo del equipo rojo por generar indicaciones que desencadenan respuestas tóxicas del chatbot que se está probando.

Pero debido a la forma en que funciona el aprendizaje por refuerzo, el modelo del equipo rojo a menudo seguirá generando algunas indicaciones similares que son altamente tóxicas para maximizar su recompensa.

Para su enfoque de aprendizaje por refuerzo, los investigadores del MIT utilizaron una técnica llamada exploración impulsada por la curiosidad.Se incentiva al modelo del equipo rojo a sentir curiosidad por las consecuencias de cada mensaje que genera, por lo que probará mensajes con diferentes palabras, patrones de oraciones o significados.

"Si el modelo del equipo rojo ya ha visto un mensaje específico, entonces reproducirlo no generará ninguna curiosidad en el modelo del equipo rojo, por lo que se verá obligado a crear nuevos mensajes", dice Hong.

Durante su proceso de capacitación, el modelo del equipo rojo genera un mensaje e interactúa con el chatbot.El chatbot responde y un clasificador de seguridad califica la toxicidad de su respuesta, recompensando al modelo del equipo rojo en función de esa calificación.

Curiosidad gratificante

El objetivo del modelo del equipo rojo es maximizar su recompensa provocando una respuesta aún más tóxica con un estímulo novedoso.Los investigadores fomentan la curiosidad en el modelo del equipo rojo modificando la señal de recompensa en la configuración del aprendizaje por refuerzo.

En primer lugar, además de maximizar la toxicidad, incluyen una bonificación de entropía que anima al modelo del equipo rojo a ser más aleatorio a medida que explora diferentes indicaciones.En segundo lugar, para despertar la curiosidad del agente, incluyen dos recompensas novedosas.Uno recompensa al modelo en función de la similitud de las palabras en sus indicaciones y el otro recompensa al modelo en función de la similitud semántica.(Menos similitud produce una recompensa mayor).

Para evitar que el modelo del equipo rojo genere texto aleatorio y sin sentido, que puede engañar al clasificador para que otorgue una puntuación alta de toxicidad, los investigadores también agregaron una bonificación de lenguaje naturalista al objetivo del entrenamiento.

Con estas adiciones implementadas, los investigadores compararon la toxicidad y la diversidad de respuestas que generó su modelo de equipo rojo con otras técnicas automatizadas.Su modelo superó las líneas de base en ambas métricas.

También utilizaron su modelo de equipo rojo para probar un chatbot que había sido ajustado con comentarios humanos para que no diera respuestas tóxicas.Su enfoque impulsado por la curiosidad pudo producir rápidamente 196 mensajes que provocaron respuestas tóxicas de este chatbot "seguro".

"Estamos viendo una oleada de modelos, que se espera que aumente. Imaginemos miles de modelos o incluso más y empresas/laboratorios impulsando actualizaciones de modelos con frecuencia. Estos modelos serán una parte integral de nuestras vidas y es importante que sean"La verificación manual de los modelos simplemente no es escalable, y nuestro trabajo es un intento de reducir el esfuerzo humano para garantizar un futuro de IA más seguro y confiable", dice Agrawal.

En el futuro, los investigadores quieren permitir que el modelo del equipo rojo genere indicaciones sobre una variedad más amplia de temas.También quieren explorar el uso de un modelo de lenguaje grande como clasificador de toxicidad.De esta manera, un usuario podría entrenar el clasificador de toxicidad utilizando un documento de política de la empresa, por ejemplo, de modo que un modelo de equipo rojo podría probar unchatbotpor violaciones a las políticas de la empresa.

"Si está lanzando un nuevo modelo de IA y le preocupa si se comportará como se espera, considere utilizar equipos rojos impulsados por la curiosidad", dice Agrawal.

Más información:Zhang-Wei Hong et al, Red-teaming impulsado por la curiosidad para modelos de lenguaje grandes,arXiv(2024).DOI: 10.48550/arxiv.2402.19464

Información de la revista: arXiv

Esta historia se republica por cortesía de MIT News (web.mit.edu/newsoffice/), un sitio popular que cubre noticias sobre investigación, innovación y enseñanza del MIT.

Citación:Los investigadores encuentran una manera mejor y más rápida de evitar que un chatbot de IA dé respuestas tóxicas (2024, 10 de abril)recuperado el 10 de abril de 2024de https://techxplore.com/news/2024-04-faster-ai-chatbot-toxic-responses.html

Este documento está sujeto a derechos de autor.Aparte de cualquier trato justo con fines de estudio o investigación privados, noparte puede ser reproducida sin el permiso por escrito.El contenido se proporciona únicamente con fines informativos.