Google で検索したり、Siri に話しかけたり、ChatGPT に何かを依頼したり、何らかの意味で AI を使用したりするには、膨大な量のエネルギーが必要であるという事実は、徐々に常識になりました。

ある研究は、2027 年までに AI サーバーがアルゼンチンやスウェーデンと同じくらいのエネルギーを消費すると予測しています。実際、1 つの ChatGPT プロンプトは、平均して、携帯電話の料金 40 回分と同じくらいのエネルギーを消費すると推定されています。しかし、研究コミュニティコペンハーゲン大学のコンピューターサイエンスの研究者らは、エネルギー効率が高く、より気候に優しいAIモデルの開発に業界はまだ焦点を当てていない、と指摘する。

「今日、開発者は、結果の精度という点で効果的な AI モデルを構築することに重点を置いています。それは、燃料の使用量を考慮せずに、目的地に早く到着するため自動車が効果的であると言っているようなものです。その結果、AI モデルはエネルギー消費の点で非効率であることがよくあります」と、AI の二酸化炭素排出量削減の可能性を研究しているコンピューターサイエンス学部のラガベンドラ・セルバン助教授は言います。

しかし新しい研究彼とコンピューターサイエンスの学生ペドラム・バクティアリファルドが著者の2人であり、大量の二酸化炭素を抑制するのは簡単であることを実証しています。2AI モデルの精度を損なうことなく。そのためには、AI モデルの設計とトレーニングの段階から気候変動コストを念頭に置く必要があります。この研究は、音響、音声、信号処理に関する国際会議(ICASP-2024)。

「最初からエネルギー効率の高いモデルを組み立てれば、モデルの『ライフサイクル』の各段階で二酸化炭素排出量が削減されます。これは、モデルのトレーニングと、そのアプリケーションの両方に当てはまります。モデルのトレーニングは、多くの場合、数週間から数か月かかることが多く、特にエネルギーを大量に消費するプロセスです。」とセルバン氏は言います。

AI業界向けレシピ本

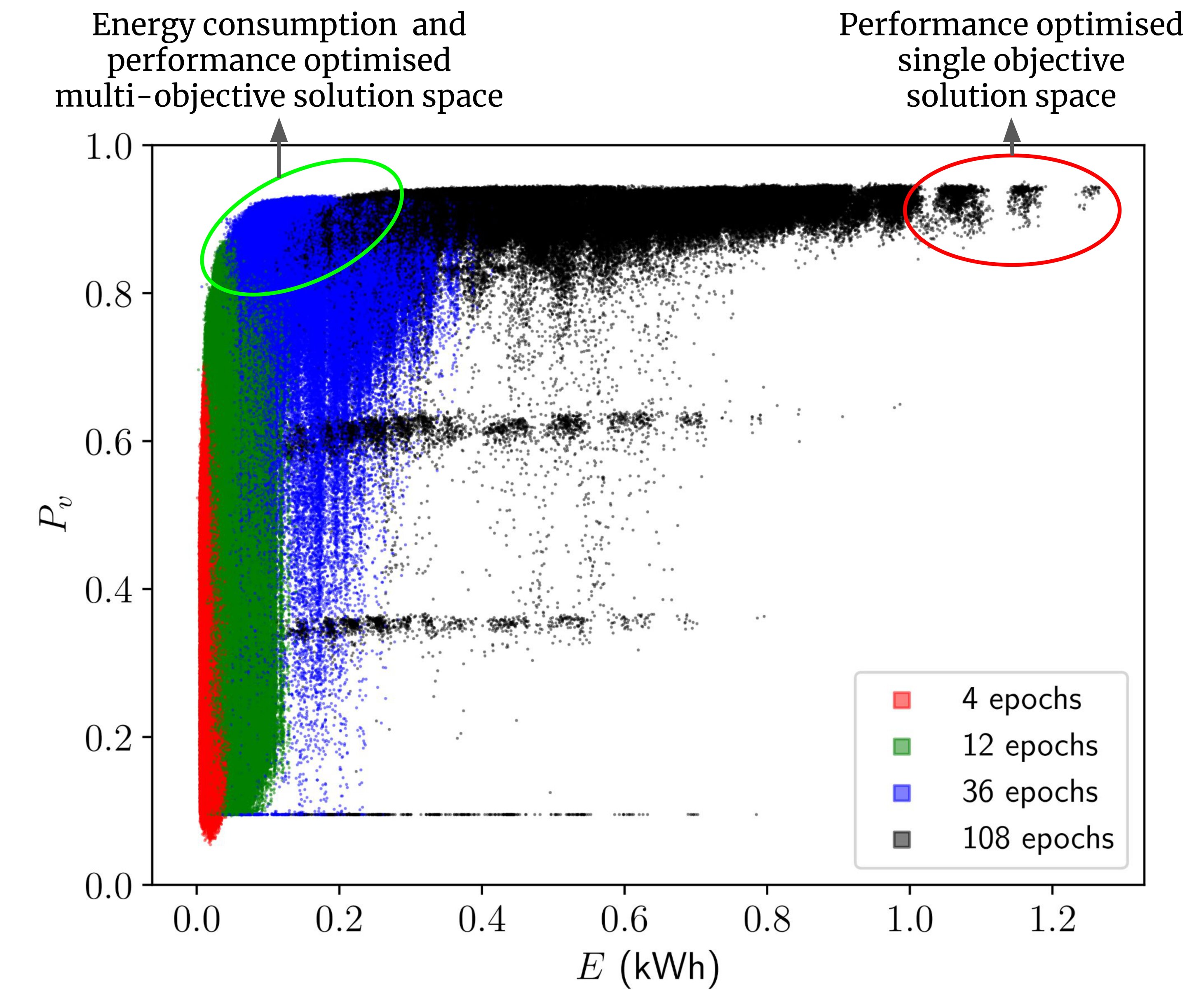

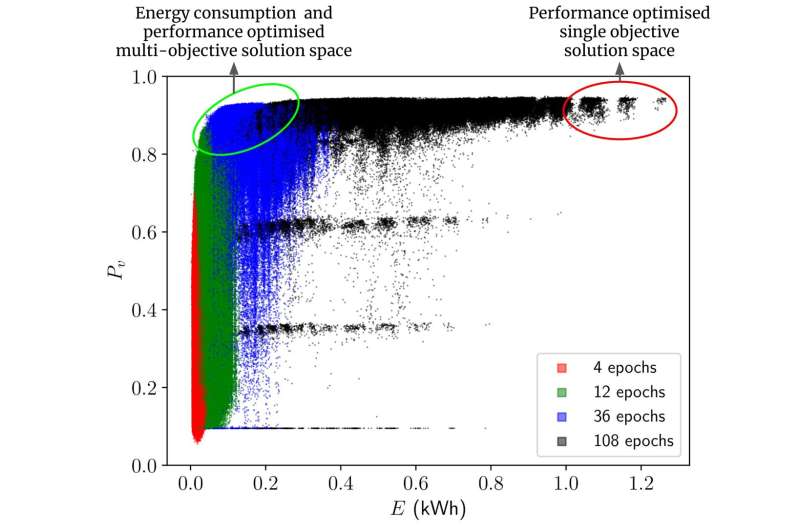

彼らの研究では、研究者らは 400,000 を超える畳み込みニューラル ネットワーク タイプの AI モデルをトレーニングするのに必要なエネルギーを計算しました。これは、これらすべてのモデルを実際にトレーニングすることなく行われました。畳み込みニューラル ネットワークは、とりわけ、医療画像の分析、言語翻訳、物体と顔の認識 (スマートフォンのカメラ アプリでおなじみの機能) に使用されます。

計算に基づいて、研究者らは、特定のタスクを解決するために消費するエネルギーが少なくても、ほぼ同じレベルでパフォーマンスを発揮する AI モデルのベンチマーク コレクションを提示します。調査によると、他のタイプのモデルを選択するか、モデルを調整することで、70 ~ 80% のエネルギーの節約パフォーマンスの低下はわずか 1% 以下で、トレーニングおよび導入フェーズ中に達成できます。研究者らによれば、これは控えめな推定値です。

「私たちの結果を AI 専門家向けのレシピ本と考えてください。レシピには、さまざまなアルゴリズムのパフォーマンスだけでなく、それらのアルゴリズムのエネルギー効率も記載されています。そして、モデルの設計においてある成分を別の成分と交換することで、次のことが可能になります。多くの場合、同じ結果が得られます。そのため、実践者はパフォーマンスと両方に基づいて必要なモデルを選択できるようになりました。エネルギー消費最初に各モデルをトレーニングする必要はありません」と、Pedram Bakhtiarifard 氏は言います。

「多くの場合、特定のタスクを解決するのに最も適していると思われるモデルを見つける前に、多くのモデルがトレーニングされます。これにより、AI の開発は非常にエネルギーを消費します。したがって、適切なモデルを選択する方が気候に優しいでしょう。」最初から、トレーニング段階では電力をあまり消費しないものを選択します。」

研究者らは、自動運転車や医療の特定分野などの一部の分野では、モデルの精度が安全性にとって重要となる可能性があることを強調している。ここで、パフォーマンスに妥協しないことが重要です。ただし、これが他の領域での高いエネルギー効率の追求を妨げるものであってはなりません。

「AI には驚くべき可能性があります。しかし、持続可能で責任ある AI 開発を確実にしたいのであれば、モデルのパフォーマンスだけでなく気候への影響も考慮した、より総合的なアプローチが必要です。ここで、私たちはより良い方法を見つけることが可能であることを示しています。」AI モデルがさまざまなタスク用に開発される場合、エネルギー効率は他の多くの業界の標準であるように、固定基準となるべきです」と Raghavendra Selvan 氏は結論づけています。

この研究でまとめられた「レシピブック」は、他の研究者が実験できるオープンソース データセットとして利用できます。これら 400,000 を超えるアーキテクチャすべてに関する情報は、次のサイトで公開されています。ギットハブAI 実践者は、単純な Python スクリプトを使用してアクセスできます。

UCPH の研究者は、として知られる 429,000 個の AI サブタイプ モデルをトレーニングするのにどれくらいのエネルギーが必要かを推定しました。畳み込みニューラル ネットワークこのデータセットでは。これらは、特に、物体検出、言語翻訳、医療画像分析に使用されます。

この研究で対象となった 429,000 個のニューラル ネットワークのトレーニングだけでも、263,000 kWh が必要になると推定されています。これは、平均的なデンマーク国民が 46 年間に消費するエネルギー量に相当します。そして、1 台のコンピューターでトレーニングを行うには約 100 年かかります。この研究の著者らは、実際にこれらのモデルを自分たちでトレーニングしたのではなく、別の AI モデルを使用してこれらを推定し、必要なエネルギーの 99% を節約しました。

AI の二酸化炭素排出量はなぜこれほど大きいのでしょうか?

AIモデルの学習には大量のエネルギーが消費され、大量のCOが排出されます。2e.これは、モデルのトレーニング中に集中的な計算が実行され、通常は強力なコンピューターで実行されるためです。

これは、ChatGPT の背後にある言語モデルなどの大規模なモデルに特に当てはまります。AI タスクは多くの場合、データセンター、コンピューターの動作と冷却を維持するために大量の電力を必要とします。これらのセンターのエネルギー源は化石燃料に依存している可能性があり、二酸化炭素排出量に影響を与えます。

詳細情報:Pedram Bakhtiarifard 他、EC-NAS: ニューラル アーキテクチャ検索のためのエネルギー消費を考慮した表形式のベンチマーク、ICASSP 2024 - 2024 IEEE 音響、音声および信号処理に関する国際会議 (ICASSP)(2024年)。DOI: 10.1109/ICASP48485.2024.10448303

引用:コンピューター科学者がその方法を示す: AI モデルはそれほど電力を消費する必要はない (2024 年 4 月 3 日)2024 年 4 月 3 日に取得https://techxplore.com/news/2024-04-scientists-ai-power-hungry.html より

この文書は著作権の対象です。個人的な研究や研究を目的とした公正な取引を除き、書面による許可なく一部を複製することができます。コンテンツは情報提供のみを目的として提供されています。