El hecho de que se necesitan cantidades colosales de energía para buscar en Google, hablar con Siri, pedirle a ChatGPT que haga algo o usar IA en cualquier sentido, se ha vuelto gradualmente de conocimiento común.

un estudioestima que para 2027 los servidores de IA consumirán tanta energía como Argentina o Suecia.De hecho, se estima que un solo mensaje ChatGPT consume, en promedio, tanta energía como cuarenta cargas de teléfonos móviles.Pero elcomunidad de investigacióny la industria aún tiene que centrarse en el desarrollo de modelos de IA que sean energéticamente eficientes y, por tanto, más respetuosos con el clima, señalan investigadores en informática de la Universidad de Copenhague.

"Hoy en día, los desarrolladores se centran exclusivamente en construir modelos de IA que sean eficaces en términos de precisión de sus resultados. Es como decir que un coche es eficaz porque te lleva a tu destino rápidamente, sin tener en cuenta la cantidad de combustible que utiliza.Como resultado, los modelos de IA suelen ser ineficientes en términos de consumo de energía", afirma el profesor asistente Raghavendra Selvan del Departamento de Ciencias de la Computación, cuya investigación analiza las posibilidades de reducir la huella de carbono de la IA.

Peroun nuevo estudio, del que él y el estudiante de informática Pedram Bakhtiarifard son dos de los autores, demuestra que es fácil frenar una gran cantidad de CO2e sin comprometer la precisión de un modelo de IA.Para ello es necesario tener en cuenta los costos climáticos desde las fases de diseño y entrenamiento de los modelos de IA.El estudio será presentado en laCongreso Internacional sobre Acústica, Habla y Procesamiento de Señales(ICASSP-2024).

"Si se crea un modelo que sea energéticamente eficiente desde el principio, se reduce la huella de carbono en cada fase del 'ciclo de vida' del modelo.Esto se aplica tanto al entrenamiento del modelo, que es un proceso especialmente intensivo en energía que a menudo lleva semanas o meses, como a su aplicación", afirma Selvan.

Libro de recetas para la industria de la IA

En su estudio, los investigadores calcularon cuánta energía se necesita para entrenar más de 400.000 modelos de IA de tipo red neuronal convolucional; esto se hizo sin entrenar realmente todos estos modelos.Entre otras cosas, las redes neuronales convolucionales se utilizan para analizar imágenes médicas, traducir idiomas y reconocer objetos y rostros, una función que quizás conozca desde la aplicación de la cámara de su teléfono inteligente.

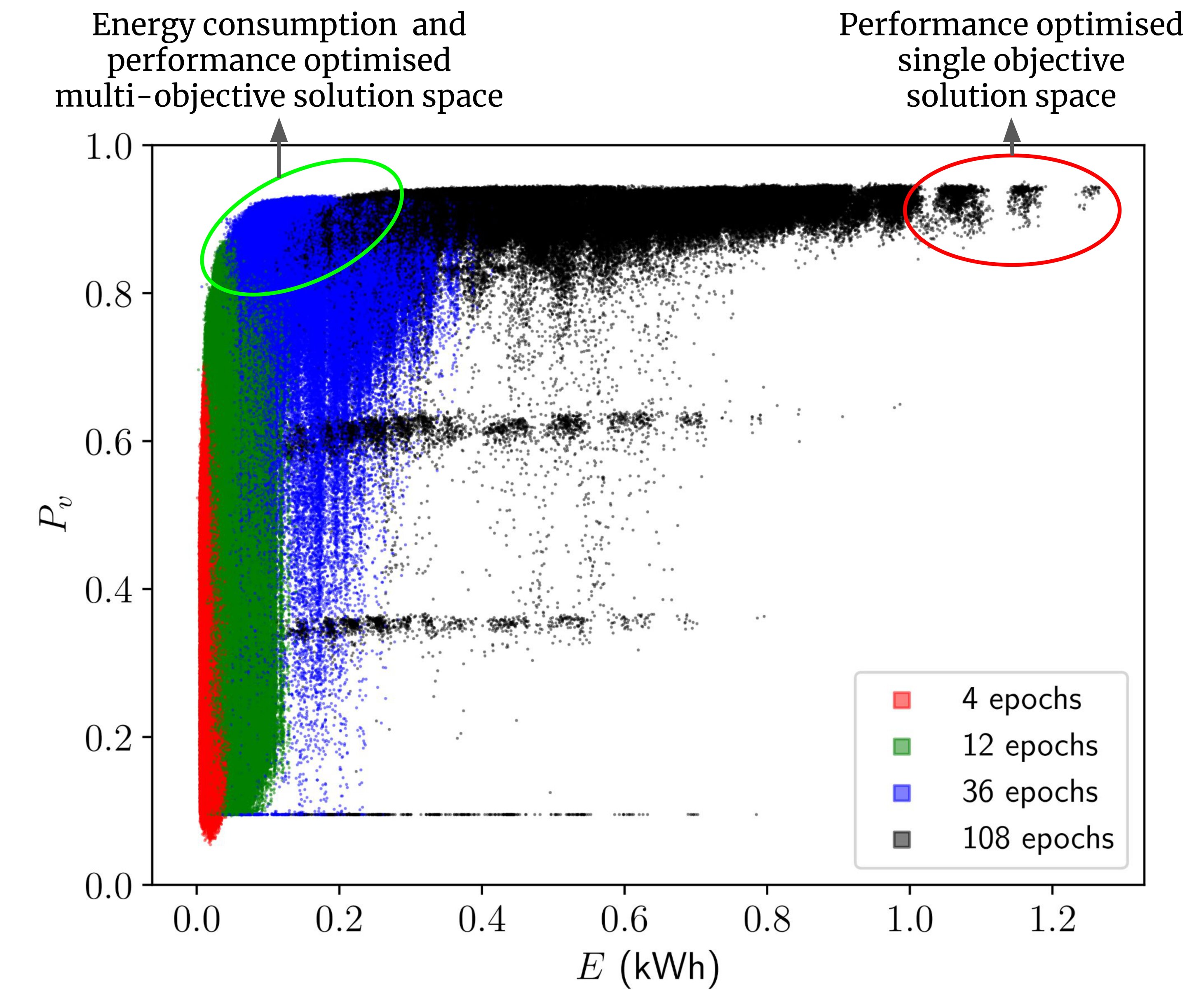

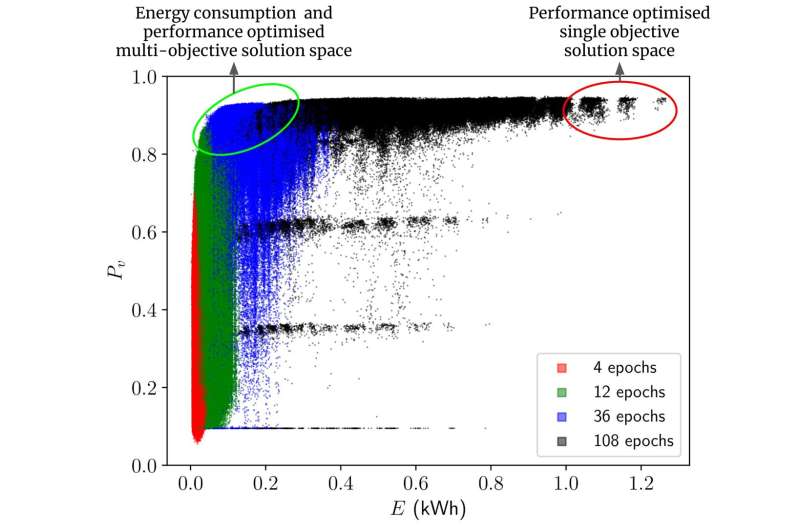

Basándose en los cálculos, los investigadores presentan una colección de referencia de modelos de IA que utilizan menos energía para resolver una tarea determinada, pero que funcionan aproximadamente al mismo nivel.El estudio demuestra que al optar por otro tipo de modelos o ajustar modelos, entre el 70 y el 80%ahorro de energíase puede lograr durante la fase de capacitación e implementación, con solo una disminución del rendimiento del 1 % o menos.Y según los investigadores, esta es una estimación conservadora.

"Considere nuestros resultados como un libro de recetas para los profesionales de la IA. Las recetas no solo describen el rendimiento de diferentes algoritmos, sino también su eficiencia energética. Y al intercambiar un ingrediente con otro en el diseño de un modelo, se puedea menudo logran el mismo resultado, por lo que ahora los profesionales pueden elegir el modelo que desean en función tanto del rendimiento como del rendimiento.consumo de energíay sin necesidad de entrenar primero cada modelo", afirma Pedram Bakhtiarifard.

"A menudo, se entrenan muchos modelos antes de encontrar el que se sospecha que es el más adecuado para resolver una tarea particular. Esto hace que el desarrollo de la IA consuma mucha energía. Por lo tanto, sería más respetuoso con el clima elegir el modelo correctodesde el principio, eligiendo uno que no consuma demasiada energía durante la fase de entrenamiento".

Los investigadores subrayan que en algunos campos, como los vehículos autónomos o determinadas áreas de la medicina, la precisión del modelo puede ser fundamental para la seguridad.Aquí es importante no comprometer el rendimiento.Sin embargo, esto no debería ser un impedimento para luchar por una alta eficiencia energética en otros ámbitos.

"La IA tiene un potencial asombroso. Pero si queremos garantizar un desarrollo sostenible y responsable de la IA, necesitamos un enfoque más holístico que no sólo tenga en mente el rendimiento del modelo, sino también el impacto climático. Aquí, demostramos que es posible encontrar una mejorCuando se desarrollan modelos de IA para diferentes tareas, la eficiencia energética debería ser un criterio fijo, tal como es estándar en muchas otras industrias", concluye Raghavendra Selvan.

El "libro de recetas" elaborado en este trabajo está disponible como un conjunto de datos de código abierto para que otros investigadores experimenten.La información sobre todas estas más de 400.000 arquitecturas está publicada enGitHuba los que los profesionales de la IA pueden acceder mediante simples scripts de Python.

Los investigadores de la UCPH estimaron cuánta energía se necesita para entrenar 429.000 modelos del subtipo de IA conocidos comoredes neuronales convolucionalesen este conjunto de datos.Estos se utilizan, entre otras cosas, para la detección de objetos, la traducción de idiomas y el análisis de imágenes médicas.

Se estima que sólo el entrenamiento de las 429.000 redes neuronales analizadas en el estudio requeriría 263.000 kWh.Esto equivale a la cantidad de energía que consume un ciudadano danés medio durante 46 años.Y a una computadora le llevaría unos 100 años realizar el entrenamiento.En realidad, los autores de este trabajo no entrenaron estos modelos ellos mismos, sino que los estimaron utilizando otro modelo de IA, ahorrando así el 99% de la energía que habría consumido.

¿Por qué la huella de carbono de la IA es tan grande?

Entrenar modelos de IA consume mucha energía y, por lo tanto, emite mucho CO2mi.Esto se debe a los cálculos intensivos que se realizan durante el entrenamiento de un modelo, que normalmente se ejecutan en computadoras potentes.

Esto es especialmente cierto para modelos grandes, como el modelo de lenguaje detrás de ChatGPT.Las tareas de IA a menudo se procesan encentros de datos, que exigen cantidades significativas de energía para mantener las computadoras en funcionamiento y refrigeradas.La fuente de energía de estos centros, que pueden depender de combustibles fósiles, influye en su huella de carbono.

Más información:Pedram Bakhtiarifard et al, EC-NAS: Puntos de referencia tabulares conscientes del consumo de energía para la búsqueda de arquitectura neuronal,ICASSP 2024 - Conferencia internacional IEEE 2024 sobre acústica, habla y procesamiento de señales (ICASSP)(2024).DOI: 10.1109/ICASSP48485.2024.10448303

Citación:Los informáticos muestran el camino: los modelos de IA no tienen por qué consumir tanta energía (2024, 3 de abril)recuperado el 3 de abril de 2024de https://techxplore.com/news/2024-04-scientists-ai-power-hungry.html

Este documento está sujeto a derechos de autor.Aparte de cualquier trato justo con fines de estudio o investigación privados, noparte puede ser reproducida sin el permiso por escrito.El contenido se proporciona únicamente con fines informativos.