一組研究人員推出了一種時間序列機器學習技術,旨在解決資料漂移挑戰。這種創新方法由UNIST工業工程系和人工智慧研究生院的Sungil Kim教授和Dongyoung Lim教授領導,有效處理現實世界時間序列資料中的不規則採樣間隔和缺失值,為確保人工智慧(AI) 模型的最佳性能。

紙張是發表於arXiv預印本伺服器。

時間序列資料以連續時間順序收集資料為特徵,普遍存在於金融、交通和醫療保健等各個行業。然而,資料漂移(影響資料產生的外部因素的變化)的存在為人工智慧模型中有效利用時間序列資料帶來了重大障礙。

金教授強調對抗數據有害影響的至關重要性漂移關於時間序列學習模型,強調解決這個阻礙人工智慧模型中時間序列資料最佳利用的持續問題的迫切性。

為了應對這項挑戰,研究團隊引入了一種利用神經隨機微分方程(Neural SDE)來建構彈性神經網路結構的新穎方法,能夠減輕資料漂移的影響。

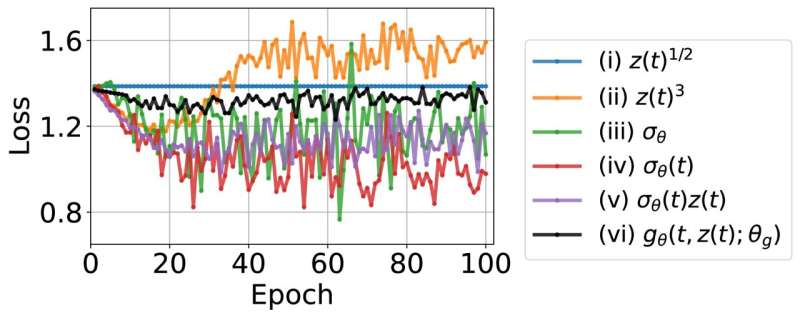

神經 SDE 是神經常微分方程 (ODE) 的擴展,代表殘差神經網路模型的連續版本,並構成團隊創新方法的基石。透過實作三種不同的神經 SDE 模型(朗之萬型 SDE、線性雜訊 SDE 和幾何 SDE),研究人員在插值、預測和分類任務中展示了穩定且出色的性能,即使存在資料漂移也是如此。

傳統上,解決資料漂移需要進行勞力密集且成本高昂的工程調整,以適應不斷變化的資料環境。然而,該團隊的方法提供了一種主動的解決方案,確保人工智慧模型從一開始就對資料漂移保持彈性,從而避免了廣泛的重新學習過程。

Lim 教授強調了這項研究對於增強時間序列人工智慧模型針對動態資料環境的彈性的重要性,從而實現跨產業的實際應用。主要作者 YongKyung Oh 強調了團隊致力於推進監控技術時間序列數據漂移和重建數據,為韓國企業的廣泛採用鋪平了道路。

這項研究被認為是國際學習表徵會議 (ICLR) 的前 5% 焦點論文,它代表了人工智慧和資料科學領域的潛在重大進步。

更多資訊:YongKyung Oh 等人,分析不規則時間序列資料中的穩定神經隨機微分方程,arXiv(2024)。DOI:10.48550/arxiv.2402.14989

期刊資訊: arXiv

引文:研究人員推出時間序列深度學習技術,以實現 AI 模型的最佳效能(2024 年,4 月 5 日)檢索日期:2024 年 4 月 5 日來自 https://techxplore.com/news/2024-04-unveil-series-deep-technique-optimal.html

本文檔受版權保護。除了出於私人學習或研究目的的任何公平交易外,不得未經書面許可,不得複製部分內容。所提供的內容僅供參考。