機器人和自動駕駛汽車是技術領域中成長最快的領域之一,有可能使工作和交通更安全、更有效率。由於機器人和自動駕駛汽車都需要準確感知周圍環境,因此 3D 物件偵測方法是一個活躍的研究領域。

大多數 3D 物體偵測方法都採用 LiDAR 感測器來創建其環境的 3D 點雲。簡而言之,LiDAR 感測器使用雷射光束快速掃描和測量光源周圍物體和表面的距離。然而,由於光達對雜訊的高敏感性,單獨使用光達資料可能會導致錯誤,特別是在降雨期間等惡劣天氣條件下。

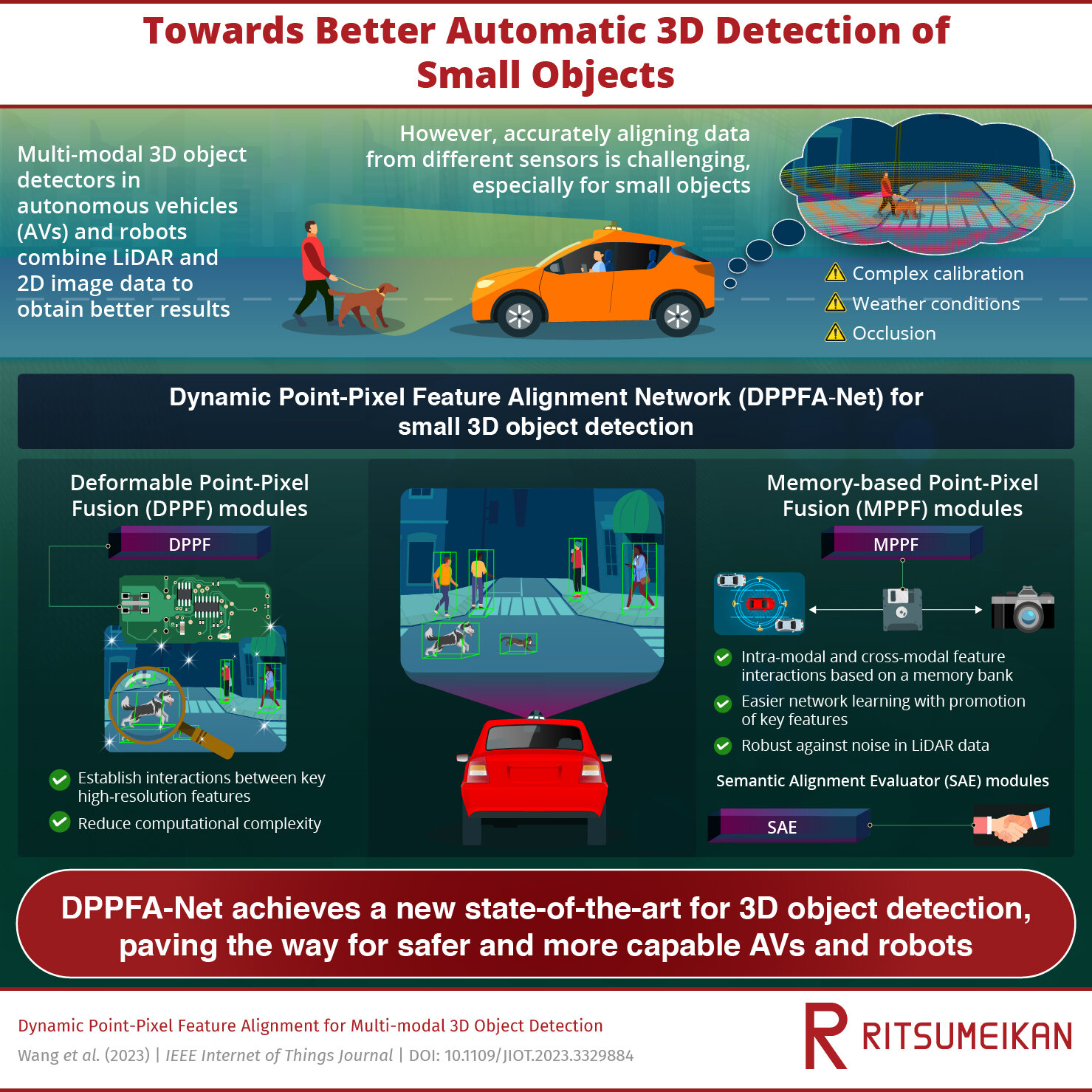

為了解決這個問題,科學家們開發了多模態 3D 物體偵測方法,將 3D LiDAR 資料與標準相機拍攝的 2D RGB 影像結合。雖然 2D 影像和 3D LiDAR 數據的融合可以帶來更準確的 3D 檢測結果,但它仍然面臨一系列挑戰,精確檢測小物體仍然很困難。

問題主要在於如何充分對齊從 2D 和 3D 資料集中獨立提取的語義訊息,由於校準不精確或遮蔽等問題,這很難。

在此背景下,由日本立命館大學 Hiroyuki Tomiyama 教授領導的研究團隊開發了一種創新方法,使多模態 3D 物件偵測更加準確且穩健。他們的論文中描述了所提出的方案,稱為「動態點像素特徵對齊網路」(DPPFA-Net)發表於IEEE 物聯網期刊。

該模型由三個新穎模組的多個實例組成:基於記憶體的點像素融合(MPPF)模組、可變形點像素融合(DPPF)模組和語義對齊評估器(SAE)模組。

MPPF 模組的任務是在模式內特徵(2D 與 2D 以及 3D 與 3D)和跨模態特徵(2D 與 3D)之間執行明確交互作用。使用2D影像作為儲存庫降低了網路學習的難度,並使系統對D點雲中的雜訊具有更強的穩健性。此外,它促進了更全面和更具區分性的特徵的使用。

相較之下,DPPF 模組僅在關鍵位置的像素處進行交互,這些像素是透過智慧採樣策略確定的。這允許以低計算複雜度進行高解析度特徵融合。最後,SAE 模組有助於確保融合過程中兩種資料表示之間的語義對齊,從而減輕特徵模糊的問題。

研究人員透過將 DPPFA™Net 與廣泛使用的 KITTI Vision Benchmark 的最佳表現進行比較來進行測試。值得注意的是,所提出的網路在不同噪音條件下平均精度提高了 7.18%。為了進一步測試模型的功能,團隊透過將降雨形式的人工多模態雜訊引入 KITTI 資料集,創建了一個新的雜訊資料集。

結果表明,所提出的網路不僅在面對嚴重遮蔽的情況下,而且在各種級別的惡劣天氣條件下都比現有模型表現更好。「我們對 KITTI 資料集和具有挑戰性的多模態雜訊案例進行的廣泛實驗表明,DPPFA-Net 達到了新的最先進水平,」Tomiyama 教授說。

值得注意的是,準確的 3D 物體偵測方法可以透過多種方式改善我們的生活。依賴此類技術的自動駕駛汽車有可能減少事故並改善交通流量和安全性。此外,機器人領域的影響也不應被低估。「我們的研究可以促進機器人更好地理解和適應其工作環境,從而更精確地感知小目標,」富山教授解釋道。

“這些進步將有助於提高機器人在各種應用中的能力。”3D 物件偵測網路的另一個用途是為深度學習感知系統預先標記原始資料。這將顯著降低手動註釋的成本,加速該領域的發展。

更多資訊:Jun Cheng Wang 等人,多模態 3D 物件偵測的動態點像素特徵對齊,IEEE 物聯網期刊(2023)。DOI:10.1109/JIOT.2023.3329884

引文:網路結合 3D LiDAR 和 2D 影像數據,實現更穩健的小物體偵測(2024 年 1 月 9 日)檢索日期:2024 年 1 月 9 日取自 https://techxplore.com/news/2024-01-network-combines-3d-lidar-2d.html

本文檔受版權保護。除了出於私人學習或研究目的的任何公平交易外,不得未經書面許可,不得複製部分內容。所提供的內容僅供參考。