在打击非法偷猎和人口贩运等复杂问题时,高效而广泛的地理空间搜索工具可以为查找和阻止活动提供关键帮助。圣路易斯华盛顿大学麦凯维工程学院的研究人员开发了一种用于地理空间探索的视觉主动搜索(VAS)框架,它使用新颖的视觉推理模型和航空图像来学习如何更有效地搜索物体。

由叶夫根尼·沃罗贝奇克 (Yevgeniy Vorobeychik) 和内森·雅各布斯 (Nathan Jacobs) 教授领导的团队电脑科学与工程,旨在转变计算机视觉– 这个领域通常关注计算机如何学习视觉信息– 面向现实世界的应用和影响。他们的尖端框架将计算机视觉与自适应学习相结合,以提高搜索通过使用以前的搜索来为将来的搜索提供信息的技术。

“这项工作是关于当你在本地实际搜索的次数受到限制时如何指导物理搜索过程,”雅各布斯说。“例如,如果你只被允许打开五个盒子,你会先打开哪个?然后,根据你发现的东西,你接下来要搜索哪里?”

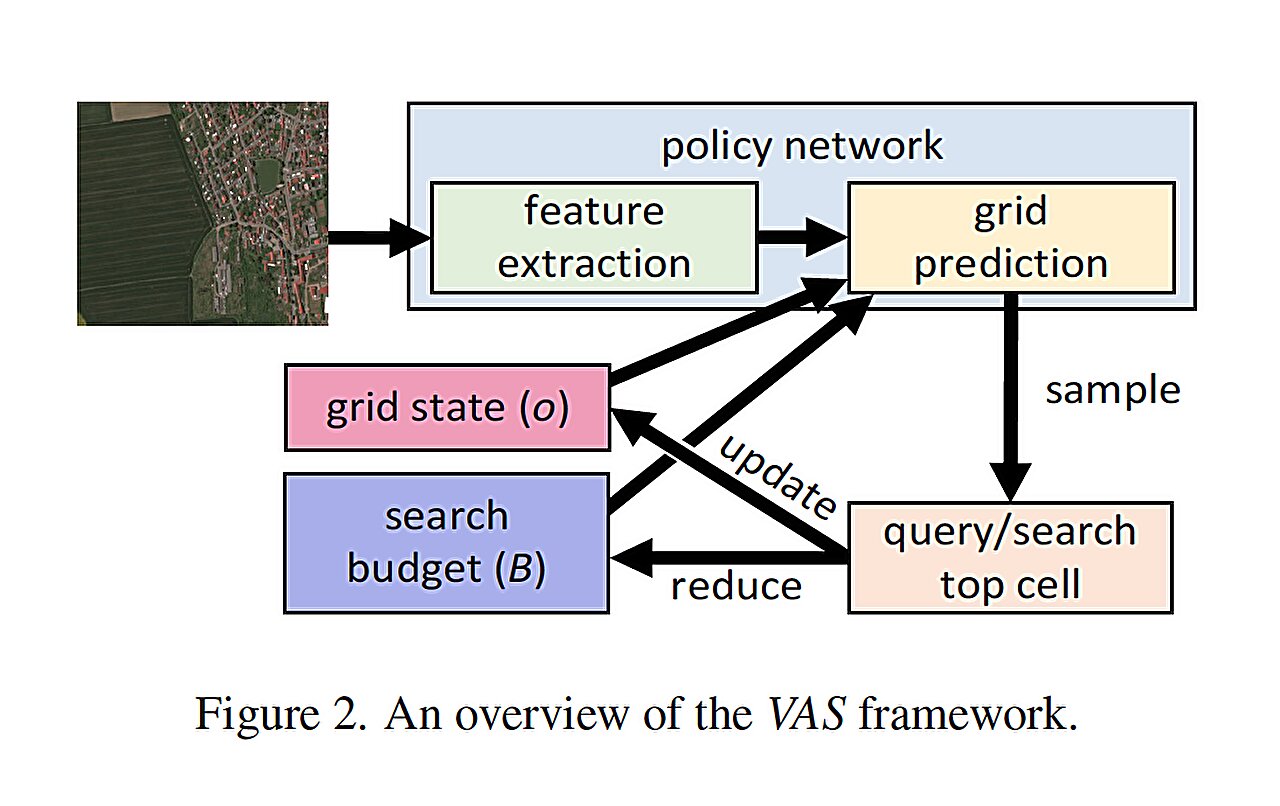

该团队的 VAS 方法建立在合作者、麦凯维工程学院计算机科学与工程副教授 Roman Garnett 之前的工作基础上。它与主动搜索结合在一起,加内特在这一领域利用视觉推理进行了开创性研究,并依赖于人类和人工智能 (AI) 之间的团队合作。人类进行本地搜索,人工智能整合航空地理空间图像和地面人员的观察结果来指导后续搜索。

新颖的VAS框架包括三个关键组件:整个搜索区域的图像,细分为多个区域;本地搜索功能,确定特定对象是否存在于给定区域中;以及固定的搜索预算,限制本地搜索功能可以执行的次数。目标是在分配的搜索预算内最大限度地检测物体,事实上,团队发现他们的方法优于所有基线。

第一作者 Anindya Sarkar 是 Vorobeychik 实验室的博士生,他于 1 月 6 日在冬季会议上介绍了这一发现会议夏威夷威可洛亚的计算机视觉应用。相关研究还可用的于arXiv预印本服务器。

萨卡说:“我们的方法利用区域之间的空间相关性来扩大和调整主动搜索,以便能够覆盖大片区域。”

“框架的交互性——从之前的搜索中学习——已经被提出,但更新底层模型的成本非常高,而且最终无法扩展到大的视觉空间。扩大大量图像数据是我们的巨大贡献为此,我们改变了与以前技术相比的基本原理。”

展望未来,该团队预计探索扩展其框架以用于各种应用程序的方法,包括专门针对不同领域从野生动物保护到搜救行动再到环境监测。他们最近提出了一个他们的搜索框架的高度适应性版本即使搜索的对象与模型训练的对象有很大差异,也可以产生最有效的搜索。

“世界看起来不一样了不同的地方,人们会想要寻找不同的东西,”雅各布斯说。“我们的框架需要能够适应这两种考虑因素,才能有效地作为搜索方法的基础。我们特别希望该工具能够动态学习和适应,因为我们并不总是提前知道我们在寻找什么或在寻找什么。”

更多信息:Anindya Sarkar 等人,地理空间探索的视觉主动搜索框架,arXiv(2022)。DOI:10.48550/arxiv.2211.15788

期刊信息: arXiv

引文:研究人员创建大规模地理空间探索框架(2024 年,1 月 17 日)检索日期:2024 年 1 月 17 日来自 https://techxplore.com/news/2024-01-framework-large-scale-geospatial-exploration.html

本文档受版权保护。除了出于私人学习或研究目的的任何公平交易外,不得未经书面许可,不得复制部分内容。所提供的内容仅供参考。