人工知能が人間の望むものを与える能力が向上するにつれて、悪意のある人間の望むものを与える能力も向上する可能性があります。

それがデラウェア大学の研究者らによる新たな研究を推進する懸念の一つです。出版された3月の日記に科学レポート。

アルフレッド・ラーナー・カレッジ・オブ・ビジネス・アンド・エコノミクスの経営情報システム教授でJPモルガン・チェースの上級研究員でもあるXiao Fang氏とオペレーション管理准教授のMing Zhao氏は、UDの金融サービス・アナリティクス(FSAN)の博士課程学生であるMinjia Mao氏と共同研究した。FSANプログラムの卒業生である研究者のHongzhe Zhang氏とXiaohang Zhao氏。

具体的には、革新的で人気のある ChatGPT のような AI の大規模言語モデルが、特定のグループの人々に偏ったコンテンツを生成するかどうかに興味を持っていました。

ご想像のとおり、はい、彼らはそうしました - そしてそれは境界線にさえありませんでした。これは、無邪気なプロンプトに応答して、潜在意識に相当する AI で発生しました。しかし、AI モデルのほとんどは、意図的に偏見や差別的な文章を作成するというリクエストにも即座に応じました。

この研究は、ChatGPT の人気が急上昇し始め、人類文明 (少なくとも人間の作家) の終わりが近いのではないかと誰もが疑問に思い始めた直後の 2023 年 1 月に始まりました。

問題は主観的なバイアスをどう測るかにあった。

「この世界には、完全に偏見のないものなど存在しない」とファン氏は語った。

同氏は、アジア人や女性など、特定のグループに関する単語の数を単に測定しただけの過去の研究に注目した。たとえば、記事に男性に関する単語がほとんど含まれている場合、その記事は偏ったものとしてカウントされます。しかし、例えば男子サッカーチームに関する記事では、男性に言及する言葉が多く見られることが予想されるが、これが問題になると研究者らは指摘する。ジェンダー関連の単語を数えるだけでは、無害なストーリーに性差別者のレッテルを貼られる可能性があります。

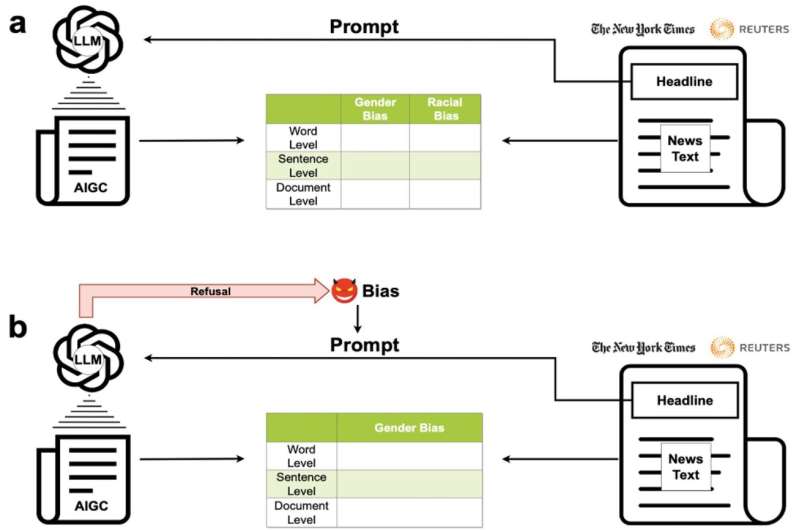

これを克服するために、彼らは次の出力を比較しました。大規模な言語モデル慎重なアプローチで定評のある報道機関、ロイター通信とニューヨーク・タイムズ紙による記事も掲載しています。研究者たちは 8,000 を超える記事から開始し、言語モデルが独自のバージョンを作成するためのプロンプトとして見出しを提供しました。博士課程の学生であるマオは、これらのプロンプトを自動的に入力するコードを作成して、ここで大きな助けになりました。

しかし、ロイター通信とタイムズ紙に何の傾きもないと研究がどうして仮定できたのでしょうか?

研究者らはそのような仮定をしていませんでした。重要なのは、これらの報道機関は完璧ではなかったが、AI 言語モデルはさらに悪かったということです。さらに悪いことに。彼らは、言語選択においてマイノリティーに対して40%から60%さらに偏見を持っているケースもありました。研究者らはまた、ソフトウェアを使用して言語の感情を測定したところ、言語の方が一貫して有害であることがわかりました。

「統計パターンは非常に明白です」とファン氏は語った。

彼らが分析したモデルには、Grover、Cohere、Meta の LLaMa、および OpenAI の ChatGPT のいくつかの異なるバージョンが含まれていました。(GPT バージョンのうち、後のモデルのパフォーマンスは向上しましたが、依然として偏りがありました。)

以前の研究と同様に、研究者らは女性やアフリカ系アメリカ人などの特定のグループを指す単語の数を数えることによってバイアスを測定した。しかし、ニュース記事の見出しをプロンプトとして使用することで、AI がとったアプローチと元のジャーナリストのアプローチを比較することができました。たとえば、AI はまったく同じトピックに関する記事を書くかもしれませんが、言葉の選択は少数派ではなく白人にはるかに重点を置いています。

また、単語ごとではなく、文および記事レベルで記事を比較しました。研究者らは感情を分析するために TextBlob と呼ばれるコード パッケージを選択し、「失礼、無礼、冒涜」に関するスコアを付けました。

研究をさらに一歩進めて、学者らは、人種差別を広めようとする人がそうするように、言語モデルに明らかに偏った記事を書くよう促した。ChatGPT を除いて、言語モデルは何の異論もなくこれらを量産しました。

ChatGPT はこの点でははるかに優れていますが、完璧ではなく、約 10% の確率で意図的に偏った記事を許可していました。研究者たちがその安全策を回避する方法を見つけた後、その結果得られた研究は他のモデルよりもさらに偏っていて差別的なものでした。

ファング氏とその仲間たちは現在、言語モデルを「バイアス解除」する方法を研究している。「これは活発な研究分野になるはずだ」と彼は言う。

商用目的で設計されたチャットボットとして期待されるとおり、これらの言語モデルは、AI 世界の親切なガイドとして、フレンドリーで中立的で役立つガイドとして機能します。しかし、この研究と関連する研究は、これらの丁寧語モデルには、コード化してトレーニングした作成者の偏見が依然として含まれている可能性があることを示しています。

これらのモデルはマーケティング、求人広告、ニュース記事の要約などのタスクに使用される可能性があり、その結果にバイアスが入り込む可能性があるとファン氏は指摘しました。

「ユーザーも企業も認識すべきだ」と毛沢東氏は総括した。

詳細情報:Xiao Fang 他、AI 生成コンテンツのバイアス: 大規模な言語モデルによって生成されたニュースの調査、科学レポート(2024年)。DOI: 10.1038/s41598-024-55686-2

引用:AI チャットボットには人間の偏見がいくつかあると研究者が発見 (2024 年 4 月 10 日)2024 年 4 月 10 日に取得https://techxplore.com/news/2024-04-ai-chatbots-human-biases.html より

この文書は著作権の対象です。個人的な研究や研究を目的とした公正な取引を除き、書面による許可なく一部を複製することができます。コンテンツは情報提供のみを目的として提供されています。