Pídale a un modelo de lenguaje grande (LLM) como GPT-4 que huela un campamento empapado de lluvia y lo rechazará cortésmente.Pídale al mismo sistema que le describa ese aroma y se volverá poético sobre "un aire cargado de anticipación" y "un aroma que es a la vez fresco y terroso", a pesar de no tener experiencia previa con la lluvia ni una nariz que lo ayude.hacer tales observaciones.Una posible explicación para este fenómeno es que el LLM simplemente imita el texto presente en sus vastos datos de entrenamiento, en lugar de trabajar con una comprensión real de la lluvia o el olor.

Pero, ¿la falta de ojos significa que los modelos lingüísticos nunca pueden "comprender" que un león es "más grande" que un gato doméstico?Tanto los filósofos como los científicos han considerado durante mucho tiempo la capacidad de asignar significado al lenguaje como un sello distintivo de la inteligencia humana y se han preguntado qué ingredientes esenciales nos permiten hacerlo.

Al analizar este enigma, investigadores del Laboratorio de Ciencias de la Computación e Inteligencia Artificial (CSAIL) del MIT han descubierto resultados intrigantes que sugieren que los modelos de lenguaje pueden desarrollar su propia comprensión de la realidad como una forma de mejorar sus habilidades generativas.

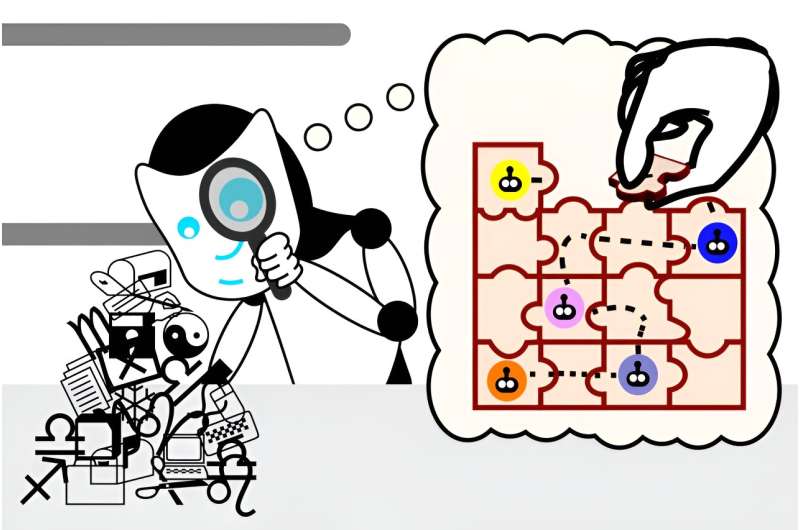

El equipo primero desarrolló un conjunto de pequeños rompecabezas de Karel, que consistían en encontrar instrucciones para controlar un robot en un entorno simulado.Luego capacitaron a un LLM sobre las soluciones, pero sin demostrar cómo funcionaban realmente las soluciones.Finalmente, utilizando una técnica de aprendizaje automático llamada "sondeo", observaron el interior del "proceso de pensamiento" del modelo a medida que generaba nuevas soluciones.

Después de entrenar en más de 1 millón de acertijos aleatorios, descubrieron que el modelo desarrolló espontáneamente su propia concepción de la simulación subyacente, a pesar de nunca haber estado expuesto a esta realidad durante el entrenamiento.Estos hallazgos ponen en duda nuestras intuiciones sobre qué tipos de información son necesarios para aprender el significado lingüístico y si algún día los LLM podrán comprender el lenguaje a un nivel más profundo que el actual.

"Al comienzo de estos experimentos, el modelo de lenguaje generaba instrucciones aleatorias que no funcionaban. Cuando completamos el entrenamiento, nuestro modelo de lenguaje generó instrucciones correctas a una tasa del 92,4 por ciento", dice Ingeniería Eléctrica e Informática del MIT (EECS).) Doctorado.Charles Jin, estudiante y afiliado de CSAIL, quien es el autor principal de un nuevo artículo sobre el trabajo.

"Este fue un momento muy emocionante para nosotros, porque pensamos que si su modelo de lenguaje podía completar una tarea con ese nivel de precisión, podríamos esperar que también comprendiera los significados del lenguaje. Esto nos dio un punto de partida para explorar"Si los LLM realmente entienden el texto, y ahora vemos que son capaces de mucho más que simplemente unir palabras a ciegas".

el papel espublicadoen elarXivservidor de preimpresión.

Dentro de la mente de un LLM

Elsondaayudó a Jin a presenciar este progreso de primera mano.Su función era interpretar lo que el LLM pensaba que significaban las instrucciones, revelando que el LLM desarrolló su propia simulación interna de cómo se mueve el robot en respuesta a cada instrucción.A medida que mejoró la capacidad del modelo para resolver acertijos, estas concepciones también se volvieron más precisas, lo que indica que el LLM estaba comenzando a comprender las instrucciones.En poco tiempo, el modelo estaba juntando las piezas correctamente para formar instrucciones de trabajo.

Jin señala que la comprensión del lenguaje por parte del LLM se desarrolla en fases, de manera muy similar a cómo un niño aprende el habla en múltiples pasos.Al principio, es como el balbuceo de un bebé: repetitivo y casi ininteligible.Luego, el modelo de lenguaje adquiere la sintaxis o las reglas del lenguaje.Esto le permite generar instrucciones que podrían parecer soluciones genuinas, pero aún así no funcionan.

Sin embargo, las instrucciones del LLM mejoran gradualmente.Una vez que el modelo adquiere significado, comienza a producir instrucciones que implementan correctamente las especificaciones solicitadas, como un niño que forma oraciones coherentes.

Separando el método del modelo: Un 'Mundo Bizarro'

La sonda sólo estaba destinada a "entrar en el cerebro de un LLM", como la caracteriza Jin, pero había una remota posibilidad de que también pensara en parte para el modelo.Los investigadores querían asegurarse de que su modelo entendiera las instrucciones independientemente de la sonda, en lugar de que la sonda infiriera los movimientos del robot a partir de la comprensión de la sintaxis del LLM.

"Imagínese que tiene un montón de datos que codifican el proceso de pensamiento del LM", sugiere Jin."La sonda es como un analista forense: le entregas este montón de datos al analista y le dices: 'Así es como se mueve el robot, ahora intenta encontrar los movimientos del robot en el montón de datos'.Más tarde, el analista le dice que sabe lo que está pasando con el robot en la pila de datos, pero ¿qué pasa si la pila de datos en realidad solo codifica las instrucciones sin procesar y el analista ha descubierto alguna forma inteligente de extraer las instrucciones y seguirlas?en consecuencia? Entonces el modelo de lenguaje no ha aprendido realmente lo que significan las instrucciones".

Para desenredar sus roles, los investigadores invirtieron los significados de las instrucciones de una nueva sonda.En este "Mundo Bizarro", como lo llama Jin, direcciones como "arriba" ahora significan "abajo" dentro de las instrucciones que mueven al robot a través de su cuadrícula.

"Si la sonda traduce instrucciones a las posiciones del robot, debería poder traducir igualmente bien las instrucciones según los significados extraños", dice Jin."Pero si la sonda realmente encuentra codificaciones de los movimientos originales del robot en el proceso de pensamiento del modelo de lenguaje, entonces debería tener dificultades para extraer los extraños movimientos del robot del proceso de pensamiento original".

Al final resultó que, la nueva sonda experimentó errores de traducción, incapaz de interpretar un modelo de lenguaje que tenía diferentes significados de las instrucciones.Esto significó que la semántica original estaba integrada dentro del modelo de lenguaje, lo que indica que el LLM entendió qué instrucciones eran necesarias independientemente del clasificador de sondeo original.

"Esta investigación apunta directamente a una pregunta central en la inteligencia artificial moderna: ¿Las sorprendentes capacidades de los grandes modelos de lenguaje se deben simplemente a correlaciones estadísticas a escala, o los grandes modelos de lenguaje desarrollan una comprensión significativa de la realidad con la que se les pide que trabajen? EstoLa investigación indica que el LLM desarrolla un modelo interno de la realidad simulada, aunque nunca fue capacitado para desarrollar este modelo", dice Martin Rinard, profesor del MIT en EECS, miembro de CSAIL y autor principal del artículo.

Este experimento apoyó aún más la hipótesis del equipo de que los modelos de lenguaje pueden desarrollar una comprensión más profunda del lenguaje.Aún así, Jin reconoce algunas limitaciones de su artículo: utilizaron un lenguaje de programación muy simple y un modelo relativamente pequeño para recopilar sus conocimientos.En un próximo trabajo, buscarán utilizar una configuración más general.Si bien la última investigación de Jin no describe cómo hacer que el modelo de lenguaje aprenda el significado más rápido, cree que el trabajo futuro puede aprovechar estos conocimientos para mejorar la forma en que se entrenan los modelos de lenguaje.

"Una pregunta abierta intrigante es si el LLM realmente está utilizando su modelo interno de la realidad para razonar sobre esa realidad mientras resuelve el problema de navegación del robot", dice Rinard."Si bien nuestros resultados son consistentes con los del LLM que utiliza el modelo de esta manera, nuestros experimentos no están diseñados para responder la siguiente pregunta".

"Hoy en día hay mucho debate sobre si los LLM realmente 'comprenden' el lenguaje, o más bien si su éxito puede atribuirse a lo que son esencialmente trucos y heurísticas que surgen al sorber grandes volúmenes de texto", dice Ellie Pavlick, asistenteprofesor deCiencias de la Computacióny lingüística en la Universidad de Brown, que no participó en el artículo.

"Estas preguntas están en el centro de cómo construimos la IA y cuáles esperamos que sean las posibilidades o limitaciones inherentes de nuestra tecnología. Este es un buen artículo que analiza esta cuestión de una manera controlada: los autores explotan el hecho de que el código de computadora, como el lenguaje natural, tiene sintaxis y semántica, pero a diferencialenguaje natural, la semántica se puede observar y manipular directamente con fines experimentales.Eldiseño experimentales elegante y sus hallazgos son optimistas, lo que sugiere que tal vez los LLM puedan aprender algo más profundo sobre lo que el lenguaje 'significa'".

Más información:Charles Jin et al, Representaciones emergentes de la semántica de programas en modelos de lenguaje entrenados en programas,arXiv(2023).DOI: 10.48550/arxiv.2305.11169

Información de la revista: arXiv

Esta historia se vuelve a publicar por cortesía de MIT News (web.mit.edu/newsoffice/), un sitio popular que cubre noticias sobre investigación, innovación y enseñanza del MIT.

Citación:Los experimentos revelan que los LLM desarrollan su propia comprensión de la realidad a medida que mejoran sus habilidades lingüísticas (2024, 14 de agosto)recuperado el 14 de agosto de 2024de https://techxplore.com/news/2024-08-reveal-llms-reality-language-abilities.html

Este documento está sujeto a derechos de autor.Aparte de cualquier trato justo con fines de estudio o investigación privados, noparte puede ser reproducida sin el permiso por escrito.El contenido se proporciona únicamente con fines informativos.