Los modelos de inteligencia artificial (IA) generativa como GPT-4o de OpenAI o Stable Diffusion de Stability AI son sorprendentemente capaces de crear nuevos textos, códigos, imágenes y videos.Sin embargo, entrenarlos requiere cantidades tan grandes de datos que los desarrolladores ya se están enfrentando a limitaciones de suministro y pronto podrían agotar por completo los recursos de capacitación.

En este contexto de escasez de datos, utilizardatos sintéticosentrenar generaciones futuras de modelos de IA puede parecer una opción atractiva para las grandes tecnologías por varias razones, entre ellas: los datos sintetizados por IA son más baratos que los datos del mundo real y prácticamente ilimitados en términos de suministro;plantea menos riesgos para la privacidad (como en el caso de los datos médicos);y en algunos casos, los datos sintéticos pueden incluso mejorar el rendimiento de la IA.

Sin embargo, un trabajo reciente del grupo de Procesamiento de Señales Digitales de la Universidad Rice ha descubierto que una dieta de datos sintéticos puede tener impactos negativos significativos en las iteraciones futuras de los modelos generativos de IA.

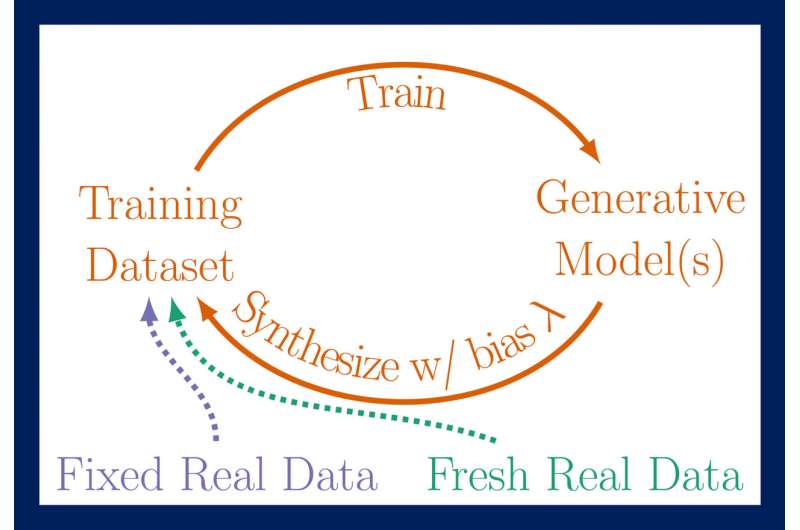

"Los problemas surgen cuando este entrenamiento de datos sintéticos se repite inevitablemente, formando una especie de circuito de retroalimentación, lo que llamamos un circuito autofago o 'autoconsumidor'", dijo Richard Baraniuk, profesor de electricidad C. Sidney Burrus de Rice.e Ingeniería Informática."Nuestro grupo ha trabajado extensamente en estos circuitos de retroalimentación, y la mala noticia es que incluso después de unas pocas generaciones de ese entrenamiento, los nuevos modelos pueden corromperse irreparablemente. Esto ha sido llamado "colapso del modelo" por algunos (más recientemente por colegas).en el campo en el contexto de grandes modelos de lenguaje (LLM, por sus siglas en inglés), sin embargo, encontramos más apropiado el término 'Trastorno de autofagia modelo' (MAD, por analogía con la enfermedad de las vacas locas).

La enfermedad de las vacas locas es una enfermedad neurodegenerativa mortal que afecta a las vacas y tiene un equivalente humano causada por el consumo de carne infectada.Un brote importante en los años 1980 y 1990 llamó la atención sobre el hecho de queenfermedad de las vacas locasProliferó como resultado de la práctica de alimentar a las vacas con los restos procesados de sus pares sacrificadas (de ahí el término "autofagia", del griego auto, que significa "yo" y fagia, "comer").

"Capturamos nuestros hallazgos sobre MADness en un artículo presentado en mayo en laConferencia Internacional sobre Representaciones del Aprendizaje (ICLR)", dijo Baraniuk.

El estudio, titulado "Los modelos generativos de autoconsumo se vuelven locos," es el primer trabajo revisado por pares sobre autofagia de IA y se centra en modelos de imágenes generativas como el popular DALL·E 3, Midjourney y Stable Diffusion.

"Elegimos trabajar en modelos visuales de IA para resaltar mejor los inconvenientes del entrenamiento autófago, pero los mismos problemas de corrupción de las vacas locas ocurren con los LLM, como han señalado otros grupos", dijo Baraniuk.

Internet suele ser la fuente de los conjuntos de datos de entrenamiento de los modelos generativos de IA, por lo que a medida que los datos sintéticos proliferan en línea, es probable que surjan bucles de autoconsumo con cada nueva generación de un modelo.Para obtener información sobre diferentes escenarios de cómo podría desarrollarse esto, Baraniuk y su equipo estudiaron tres variaciones de ciclos de entrenamiento autónomos diseñados para proporcionar una representación realista de cómo se combinan los datos reales y sintéticos en conjuntos de datos de entrenamiento para modelos generativos:

- Bucle totalmente sintético: las generaciones sucesivas de un modelo generativo fueron alimentadas con una dieta de datos totalmente sintéticos tomados de la producción de generaciones anteriores.

- Bucle de aumento sintético: el conjunto de datos de entrenamiento para cada generación del modelo incluía una combinación de datos sintéticos muestreados de generaciones anteriores y un conjunto fijo de datos de entrenamiento reales.

- Bucle de datos nuevos: cada unogeneracióndel modelo se entrena con una combinación de datos sintéticos de generaciones anteriores y un nuevo conjunto de datos reales.capacitacióndatos.

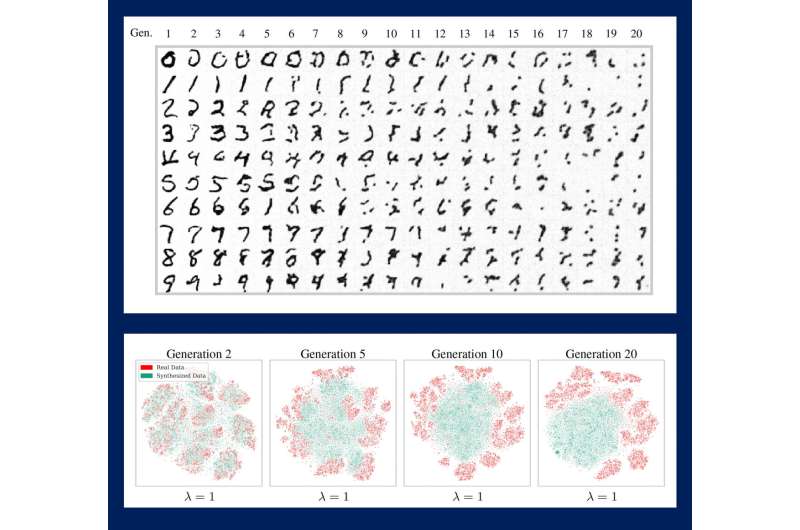

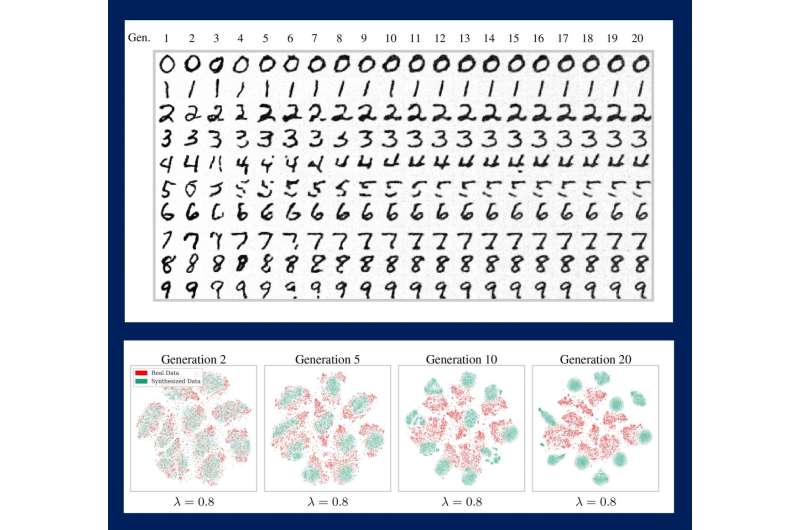

Las iteraciones progresivas de los bucles revelaron que con el tiempo y en ausencia de suficientes datos reales nuevos, los modelos generarían resultados cada vez más deformados, carentes de calidad, diversidad o ambas.En otras palabras, cuantos más datos nuevos, más saludable será la IA.

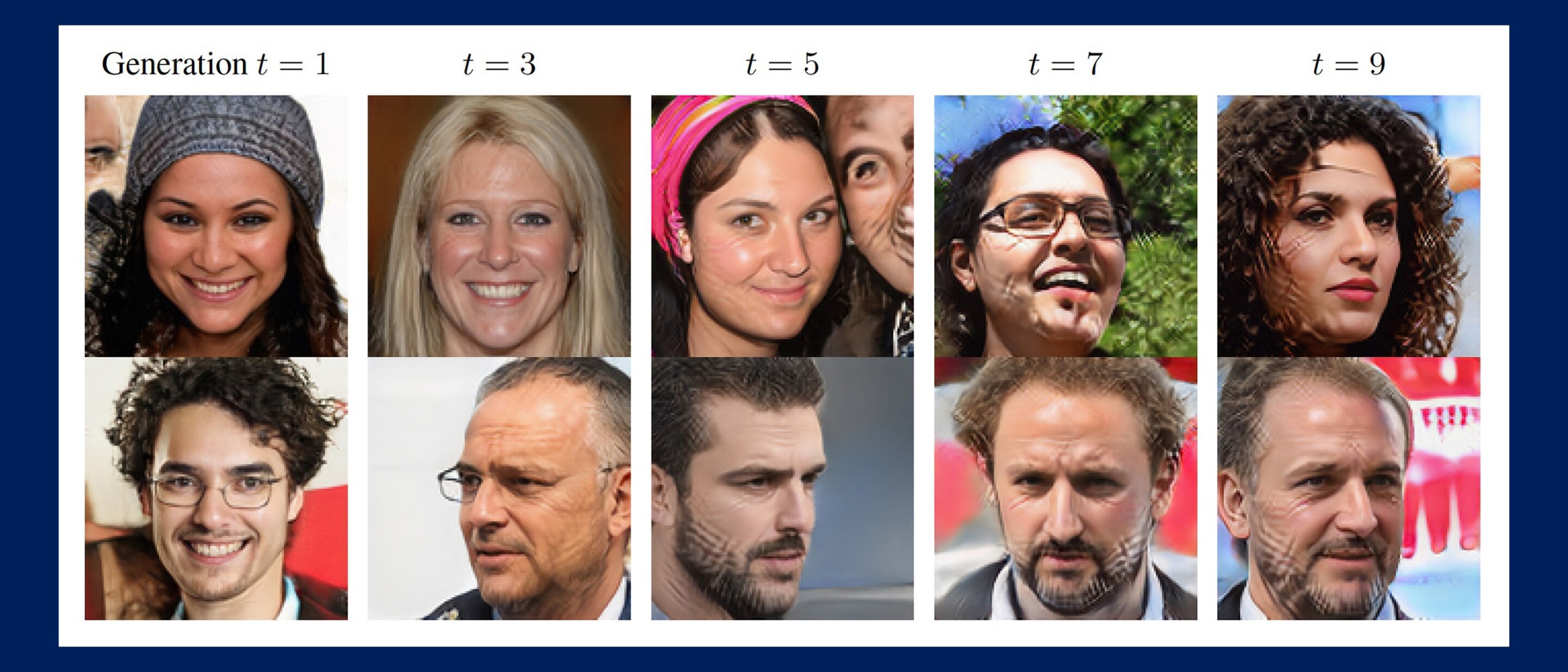

Las comparaciones lado a lado de conjuntos de datos de imágenes resultantes de generaciones sucesivas de un modelo pintan un panorama inquietante de los futuros potenciales de la IA.Los conjuntos de datos que consisten en rostros humanos están cada vez más surcados de cicatrices en forma de cuadrícula (lo que los autores llaman "artefactos generativos") o se parecen cada vez más a la misma persona.Los conjuntos de datos que consisten en números se transforman en garabatos indescifrables.

"Nuestros análisis teóricos y empíricos nos han permitido extrapolar lo que podría suceder a medida que los modelos generativos se vuelvan ubicuos y entrenen modelos futuros en bucles de autoconsumo", dijo Baraniuk."Algunas ramificaciones son claras: sin suficientes datos reales y frescos, los futuros modelos generativos están condenados a la locura".

Para hacer estas simulaciones aún más realistas, los investigadores introdujeron un parámetro de sesgo de muestreo para tener en cuenta la "selección selectiva": la tendencia de los usuarios a favorecer la calidad de los datos sobre la diversidad, es decir, sacrificar la variedad en los tipos de imágenes y textos en unconjunto de datos para imágenes o textos que se ven o suenan bien.

El incentivo para elegir cuidadosamente es que la calidad de los datos se conserva en un mayor número de iteraciones del modelo, pero esto se produce a expensas de una disminución aún más pronunciada de la diversidad.

"Un escenario apocalíptico es que, si no se controla durante muchas generaciones, MAD podría envenenar la calidad y la diversidad de los datos de todo Internet", dijo Baraniuk."A falta de esto, parece inevitable que surjan consecuencias no deseadas hasta ahora invisibles de la autofagia de la IA, incluso en el corto plazo".

Además de Baraniuk, los autores del estudio incluyen a Rice Ph.D.los estudiantes Sina Alemohammad;Josué Casco-Rodríguez;Ahmed Imtiaz Humayun;Hossein Babaei;Doctorado en arroz.el ex alumno Lorenzo Luzi;Doctorado en arroz.el ex alumno y actual estudiante postdoctoral de Stanford, Daniel LeJeune;y el becario postdoctoral de Simons, Ali Siahkoohi.

Citación:Breaking MAD: La IA generativa podría romper Internet (30 de julio de 2024)recuperado el 30 de julio de 2024de https://techxplore.com/news/2024-07-mad-generative-ai-internet.html

Este documento está sujeto a derechos de autor.Aparte de cualquier trato justo con fines de estudio o investigación privados, noparte puede ser reproducida sin el permiso por escrito.El contenido se proporciona únicamente con fines informativos.