Investigadores de ingeniería de la Universidad de Minnesota Twin Cities han demostrado un dispositivo de hardware de última generación que podría reducir el consumo de energía para aplicaciones informáticas de inteligencia artificial (IA) en un factor de al menos 1.000.

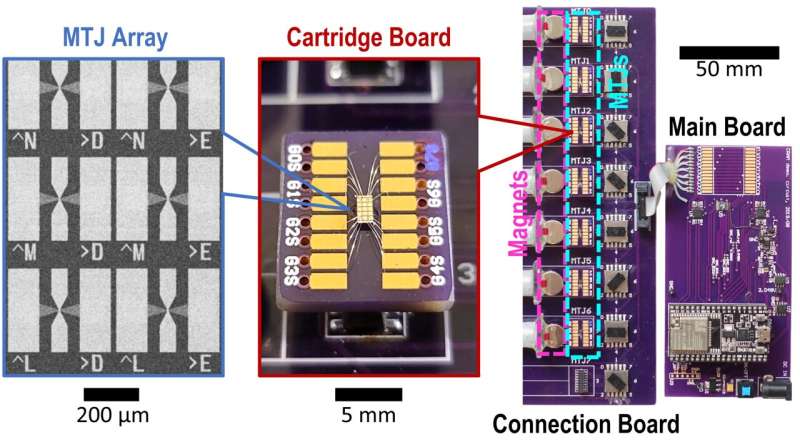

La investigación espublicadoennpj Computación no convencionaltitulado "Demostración experimental de memoria de acceso aleatorio computacional basada en uniones de túnel magnético".Los investigadores tienen múltiples patentes sobre la tecnología utilizada en el dispositivo.

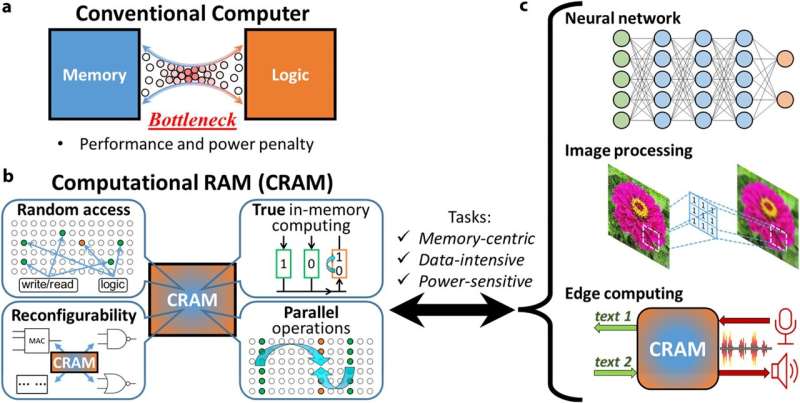

Con la creciente demanda de aplicaciones de IA, los investigadores han estado buscando formas de crear un proceso más eficiente desde el punto de vista energético, manteniendo al mismo tiempo el rendimiento alto y los costos bajos.Comúnmente, los procesos de máquinas o de inteligencia artificial transfieren datos entre la lógica (donde se procesa la información dentro de un sistema) y la memoria (donde se almacenan los datos), consumiendo una gran cantidad de potencia y energía.

Un equipo de investigadores de la Facultad de Ciencias e Ingeniería de la Universidad de Minnesota demostró un nuevo modelo en el que los datos nunca salen de la memoria, llamado memoria computacional de acceso aleatorio (CRAM).

"Este trabajo es la primera demostración experimental de CRAM, donde los datos se pueden procesar completamente dentro de la matriz de memoria sin la necesidad de salir de la red donde una computadora almacena información", dijo Yang Lv, del Departamento de Ingeniería Eléctrica e Informática de la Universidad de Minnesota.Investigador postdoctoral y primer autor del artículo.

La Agencia Internacional de Energía (AIE) emitió unpronóstico del uso global de energíaen marzo de 2024, pronosticando queconsumo de energíaEs probable que el consumo de IA se duplique de 460 teravatios-hora (TWh) en 2022 a 1.000 TWh en 2026. Esto equivale aproximadamente al consumo de electricidad de todo el país de Japón.

Según los autores del nuevo artículo, se estima que un acelerador de inferencia de aprendizaje automático basado en CRAM logrará una mejora del orden de 1.000.Otro ejemplo mostró un ahorro de energía de 2.500 y 1.700 veces en comparación con los métodos tradicionales.

Esta investigación lleva más de dos décadas en desarrollo.

"Nuestro concepto inicial de utilizar células de memoria directamente para la computación hace 20 años se consideró una locura", dijo Jian-Ping Wang, autor principal del artículo y profesor distinguido de McKnight y catedrático Robert F. Hartmann en el Departamento de Ingeniería Eléctrica e Informática dela Universidad de Minnesota.

"Con un grupo de estudiantes en evolución desde 2003 y un verdadero equipo docente interdisciplinario creado en la Universidad de Minnesota, desde física,ciencias de los materialese ingeniería, informática e ingeniería, hasta modelado y evaluación comparativa, y creación de hardware... pudimos obtener resultados positivos y ahora hemos demostrado que este tipo de tecnología es factible y está lista para ser incorporada a la tecnología", afirmó Wang.

Esta investigación es parte de un esfuerzo coherente y de larga data que se basa en la innovadora investigación patentada de Wang y sus colaboradores sobre dispositivos de uniones de túnel magnético (MTJ), que son dispositivos nanoestructurados utilizados para mejorar discos duros, sensores y otros sistemas microelectrónicos, incluidosMemoria magnética de acceso aleatorio (MRAM), que se ha utilizado en sistemas integrados como microcontroladores y relojes inteligentes.

La arquitectura CRAM permite la verdadera computación en y mediante la memoria y derriba el muro entre la computación y la memoria como cuello de botella en la arquitectura tradicional de von Neumann, un diseño teórico para una computadora con programa almacenado que sirve como base para casi todas las computadoras modernas.

"Como sustrato de computación en memoria digital extremadamente eficiente desde el punto de vista energético, CRAM es muy flexible en el sentido de que el cálculo se puede realizar en cualquier ubicación de la matriz de memoria. En consecuencia, podemos reconfigurar CRAM para que se adapte mejor a las necesidades de rendimiento de un conjunto diverso deAlgoritmos de IA", dijo Ulya Karpuzcu, experto en arquitectura informática, coautor del artículo y profesor asociado en el Departamento de Ingeniería Eléctrica e Informática de la Universidad de Minnesota.

"Es más eficiente energéticamente que los componentes tradicionales de los sistemas de IA actuales".

CRAM realiza cálculos directamente dentrocélulas de memoria, utilizando la estructura de la matriz de manera eficiente, lo que elimina la necesidad de transferencias de datos lentas y que consumen mucha energía, explicó Karpuzcu.

El acceso aleatorio a corto plazo más eficientememoriaEl dispositivo, o RAM, utiliza cuatro o cinco transistores para codificar un uno o un cero, pero un MTJ, un dispositivo espintrónico, puede realizar la misma función con una fracción de energía, con mayor velocidad y es resistente a entornos hostiles.Los dispositivos espintrónicos aprovechan el espín de los electrones en lugar delcarga electricapara almacenar datos, proporcionando una alternativa más eficiente a los chips tradicionales basados en transistores.

Actualmente, el equipo ha estado planeando trabajar con líderes de la industria de semiconductores, incluidos aquellos de Minnesota, para realizar demostraciones a gran escala y producir el hardware para mejorar la funcionalidad de la IA.

Además de Lv, Wang y Karpuzcu, el equipo incluyó a los investigadores del Departamento de Ingeniería Eléctrica e Informática de la Universidad de Minnesota, Robert Bloom y Husrev Cilasun;el distinguido profesor McKnight y presidente Robert y Marjorie Henle, Sachin Sapatnekar;y los ex investigadores postdoctorales Brandon Zink, Zamshed Chowdhury y Salonik Resch;junto con investigadores de la Universidad de Arizona: Pravin Khanal, Ali Habiboglu y el profesor Weigang Wang.

Más información:Yang Lv et al, Demostración experimental de memoria de acceso aleatorio computacional basada en uniones de túnel magnético,npj Computación no convencional(2024).DOI: 10.1038/s44335-024-00003-3

Citación:Los ingenieros desarrollan un dispositivo basado en uniones de túneles magnéticos para hacer que la IA sea más eficiente energéticamente (26 de julio de 2024)recuperado el 26 de julio de 2024de https://techxplore.com/news/2024-07-magnetic-tunnel-junctionbased-device-ai.html

Este documento está sujeto a derechos de autor.Aparte de cualquier trato justo con fines de estudio o investigación privados, noparte puede ser reproducida sin el permiso por escrito.El contenido se proporciona únicamente con fines informativos.