Una cosa que hace que los modelos de lenguajes grandes (LLM) sean tan poderosos es la diversidad de tareas a las que se pueden aplicar.El mismo modelo de aprendizaje automático que puede ayudar a un estudiante de posgrado a redactar un correo electrónico también podría ayudar a un médico a diagnosticar el cáncer.

Sin embargo, la amplia aplicabilidad de estos modelos también dificulta su evaluación de forma sistemática.Sería imposible crear un conjunto de datos de referencia para probar un modelo en cada tipo de pregunta que se pueda formular.

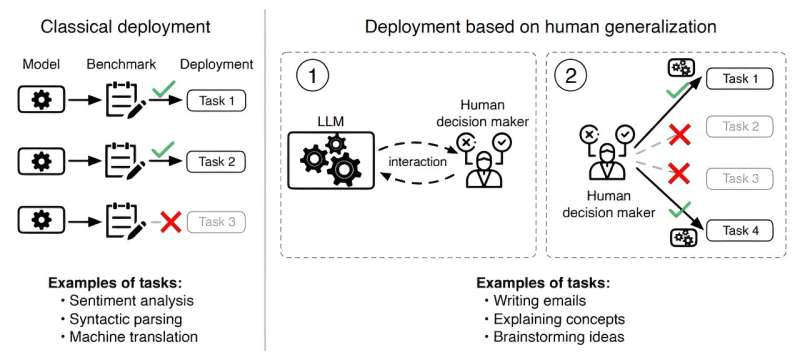

en unpapel nuevopublicado en elarXivservidor de preimpresión, los investigadores del MIT adoptaron un enfoque diferente.Argumentan que, debido a que los humanos deciden cuándo desplegargrandes modelos de lenguaje, evaluar un modelo requiere comprender cómo las personas forman creencias sobre sus capacidades.

Por ejemplo, el estudiante de posgrado debe decidir si el modelo podría ser útil para redactar un correo electrónico en particular, y el médico debe determinar en qué casos sería mejor consultar el modelo.

A partir de esta idea, los investigadores crearon un marco para evaluar un LLM en función de su alineación con las creencias humanas sobre cómo se desempeñará en una determinada tarea.

Introducen una función de generalización humana: un modelo de cómo las personas actualizan sus creencias sobre las capacidades de un LLM después de interactuar con él.Luego, evalúan qué tan alineados están los LLM con esta función de generalización humana.

Sus resultados indican que cuando los modelos no están alineados con la función de generalización humana, un usuario podría tener demasiada o poca confianza en dónde implementarlos, lo que podría provocar que un modelo falle inesperadamente.Además, debido a esta desalineación, los modelos más capaces tienden a tener peor desempeño que los modelos más pequeños en situaciones de alto riesgo.

"Estas herramientas son interesantes porque tienen un propósito general, pero como tienen un propósito general, colaborarán con personas, por lo que debemos tener en cuenta al ser humano involucrado", dice el coautor del estudio Ashesh Rambachan, profesor asistente deeconomía e investigador principal en el Laboratorio de Sistemas de Información y Decisión (LIDS).

A Rambachan se unen en el artículo el autor principal Keyon Vafa, postdoctorado en la Universidad de Harvard;y Sendhil Mullainathan, profesor del MIT en los departamentos de Ingeniería Eléctrica e Informática y de Economía, y miembro de LIDS.La investigación se presentará en la Conferencia Internacional sobre Aprendizaje Automático (ICML 2024) celebrada en Viena, Austria, del 21 al 27 de julio.

Generalización humana

A medida que interactuamos con otras personas, nos formamos creencias sobre lo que creemos que saben y lo que no saben.Por ejemplo, si tu amigo es meticuloso a la hora de corregir la gramática de las personas, podrías generalizar y pensar que también destacaría en la construcción de oraciones, aunque nunca le hayas hecho preguntas sobre la construcción de oraciones.

"Los modelos lingüísticos a menudo parecen muy humanos. Queríamos ilustrar que esta fuerza de generalización humana también está presente en la forma en que las personas forman creencias sobre los modelos lingüísticos", dice Rambachan.

Como punto de partida, los investigadores definieron formalmente la función de generalización humana, que implica hacer preguntas, observar cómo responde una persona o LLM y luego hacer inferencias sobre cómo esa persona o modelo respondería a preguntas relacionadas.

Si alguien ve que un LLM puede responder correctamente preguntas sobre inversión de matrices, también podría asumir que puede responder preguntas sobre aritmética simple.Un modelo que no esté alineado con esta función (uno que no funcione bien en las preguntas que un ser humano espera que responda correctamente) podría fallar cuando se implemente.

Con esa definición formal en la mano, los investigadores diseñaron una encuesta para medir cómo las personas generalizan cuando interactúan con LLM y otras personas.

Mostraron a los participantes de la encuesta preguntas que una persona o LLM acertó o no y luego les preguntaron si pensaban que esa persona o LLM respondería correctamente una pregunta relacionada.A través de la encuesta, generaron un conjunto de datos de casi 19.000 ejemplos de cómo los humanos generalizan sobre el desempeño del LLM en 79 tareas diversas.

Medición de desalineación

Descubrieron que a los participantes les fue bastante bien cuando se les preguntó si un humano que respondiera correctamente una pregunta respondería correctamente a una pregunta relacionada, pero fueron mucho peores a la hora de generalizar sobre el desempeño de los LLM.

"La generalización humana se aplica a los modelos de lenguaje, pero eso fracasa porque estos modelos de lenguaje en realidad no muestran patrones de experiencia como lo haría la gente", dice Rambachan.

También era más probable que las personas actualizaran sus creencias sobre un LLM cuando respondía preguntas incorrectamente que cuando respondía correctamente.También tendían a creer que el desempeño del LLM en preguntas simples tendría poca relación con su desempeño en preguntas más complejas.

En situaciones en las que las personas dan más importancia a las respuestas incorrectas, los modelos más simples superaron a los modelos muy grandes como GPT-4.

"Los modelos de lenguaje que mejoran casi pueden engañar a las personas haciéndoles creer que se desempeñarán bien en preguntas relacionadas cuando, en realidad, no es así", afirma.

Una posible explicación de por qué los humanos son peores generalizando para los LLM podría provenir de su novedad: las personas tienen mucha menos experiencia interactuando con los LLM que con otras personas.

"En el futuro, es posible que mejoremos simplemente interactuando más con los modelos de lenguaje", dice.

Con este fin, los investigadores quieren realizar estudios adicionales sobre cómo las creencias de las personas sobre los LLM evolucionan con el tiempo a medida que interactúan con un modelo.También quieren explorar cómo se podría incorporar la generalización humana en el desarrollo de LLM.

"Cuando entrenamos estos algoritmos en primer lugar, o intentamos actualizarlos con retroalimentación humana, debemos tener en cuenta la función de generalización humana en la forma en que pensamos acerca de medir el desempeño", dice.

Mientras tanto, los investigadores esperan que su conjunto de datos pueda usarse como punto de referencia para comparar el desempeño de los LLM en relación con la función de generalización humana, lo que podría ayudar a mejorar el desempeño de los modelos implementados en situaciones del mundo real.

"Para mí, la contribución del documento es doble. La primera es práctica: el documento descubre un problema crítico con la implementación de LLM para uso general del consumidor. Si las personas no tienen la comprensión correcta de cuándo los LLM serán precisos y cuándo seránSi fallan, será más probable que vean errores y tal vez se desanimen de seguir utilizándolos.

"Esto pone de relieve la cuestión de alinear los modelos con la comprensión de la gente sobre la generalización", dice Alex Imas, profesor de ciencias del comportamiento y economía en la Escuela de Negocios Booth de la Universidad de Chicago, que no participó en este trabajo.

"La segunda contribución es más fundamental: la falta degeneralizacióna los problemas y dominios esperados ayuda a tener una mejor idea de lo que hacen los modelos cuando resuelven un problema "correctamente".Proporciona una prueba de si los LLM 'entienden' el problema que están resolviendo".

Más información:Keyon Vafa et al, ¿Los modelos de lenguaje grandes funcionan como la gente espera?Medición de la función de generalización humana,arXiv(2024).DOI: 10.48550/arxiv.2406.01382

Información de la revista: arXiv

Esta historia se vuelve a publicar por cortesía de MIT News (web.mit.edu/newsoffice/), un sitio popular que cubre noticias sobre investigación, innovación y enseñanza del MIT.

Citación:Los modelos de lenguaje grandes no se comportan como personas, aunque esperemos que lo hagan (2024, 23 de julio)recuperado el 23 de julio de 2024de https://techxplore.com/news/2024-07-large-language-dont-people.html

Este documento está sujeto a derechos de autor.Aparte de cualquier trato justo con fines de estudio o investigación privados, noparte puede ser reproducida sin el permiso por escrito.El contenido se proporciona únicamente con fines informativos.