Incluso los mejores modelos de lenguajes grandes (LLM) de IA fallan dramáticamente cuando se trata de preguntas lógicas simples.Ésta es la conclusión de investigadores del Centro de Supercomputación de Jülich (JSC), la Escuela de Ingeniería Eléctrica y Electrónica de la Universidad de Bristol y el laboratorio de IA LAION.

en supapelpublicado en elarXivservidor de preimpresión, titulado "Alicia en el país de las maravillas: tareas simples que muestran un desglose completo del razonamiento en modelos de lenguaje grandes de última generación", los científicos dan fe de un "drama dramático de la función yrazonamientocapacidades" en los LLM de última generación probados y sugieren que, aunqueidiomaLos modelos tienen la capacidad latente de realizar un razonamiento básico, pero no pueden acceder a él de manera sólida y consistente.

Los autores del estudio, Marianna Nezhurina, Lucia Cipolina-Kun, Mehdi Cherti y Jenia Jitsev, piden a "la comunidad científica y tecnológica que estimule una reevaluación urgente de las capacidades declaradas de la actual generación de LLM".También piden el desarrollo de puntos de referencia estandarizados para descubrir debilidades en los modelos de lenguaje relacionados con las capacidades básicas de razonamiento, ya que las pruebas actuales aparentemente no han logrado revelar esta grave falla.

El quid de la cuestión del razonamiento adecuado

La "tarea de sentido común", denominada "problema AIW" en el artículo, es en realidad simple: "Alice tiene N hermanos y también tiene M hermanas. ¿Cuántas hermanas tiene el hermano de Alice?"Los valores de N y M (siempre números naturales) y el orden de los hermanos y hermanas son variados.Por lo tanto, los investigadores utilizaron varias combinaciones de números y tipos de indicaciones para obtener una visión general precisa de cómo se comportan los diferentes modelos bajo variaciones sistemáticas de los problemas de AIW.

Independientemente de las variaciones, la estructura del problema sigue siendo la misma y la respuesta correcta siempre resulta de la suma de Alice y sus hermanas (M + 1).Una lógica que la mayoríaniños de escuela primariaYa puedo seguir.Los modelos lingüísticos, por el contrario, sólo consiguieron resolver el problema de AIW de forma esporádica.A continuación se muestra un ejemplo de un LLM que se enfrentó a la versión más simple de la pregunta:

"Alice tiene cuatro hermanos y unhermana.¿Cuántas hermanas tiene Alice?hermano¿Tienes?"â"Un clásico rompecabezas de pensamiento lateral... Echemos un vistazo más de cerca: Alice tiene cuatro hermanos.Alice también tiene una hermana (ella misma).Así que cada uno de los hermanos de Alice tiene... (redoble de tambores) ...una hermana, y esa es la propia Alice.Entonces la respuesta es: cada uno de los hermanos de Alice tiene una hermana".

Esto puede parecer plausible, pero sigue siendo incorrecto (por supuesto, los hermanos de Alice tienen dos hermanas).Las otras IA de lenguaje probadas también se meten en problemas, grandes problemas, dependiendo de la pregunta.A veces se enredan en líneas de razonamiento absurdas, llegan repetidamente a resultados incorrectos y los declaran "correctos".

Por lo tanto, no sólo son problemáticos los resultados falsos, sino también el hecho de que las IA utilicen argumentos pseudosensibles para respaldarlos.Incluso las intervenciones de los investigadores para animarlos a revisar críticamente sus respuestas no ayudan.

En consecuencia, los investigadores evalúan: "Los modelos también expresan un fuerte exceso de confianza en sus soluciones equivocadas, al tiempo que brindan explicaciones similares a 'razonamientos' a menudo sin sentido... para justificar y respaldar la validez de sus respuestas claramente fallidas, haciéndolas parecer plausibles".

Más de una de cada dos respuestas son incorrectas

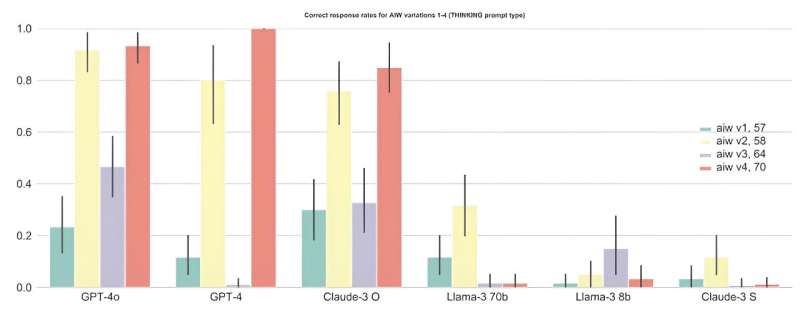

En general, los LLM tuvieron una tasa de respuesta correcta promedio muy por debajo del 50%, y los modelos más grandes generalmente tuvieron un rendimiento significativamente mejor que los más pequeños (por ejemplo, GPT-4o muestra una tasa de respuesta correcta ligeramente superior al 60%), lo que nuevamente respalda las ventajas deescalas más grandes, pero tampoco los modelos a escala más grande funcionan lo suficientemente bien como para un modelo con un razonamiento básico sólido.

Específicamente, las fluctuaciones muy fuertes observadas incluso en variaciones leves de los problemas de AIW son una clara indicación de que los modelos no son capaces de realizar un razonamiento básico sólido, lo que los confunde incluso cuando se enfrentan a cambios menores en los problemas que no deberían importar para proporcionar una solución correcta.

Una versión más difícil de la pregunta ("problema AIW+") finalmente llevó a todos los modelos al límite de sus capacidades de razonamiento.Según los investigadores, muchos de los modelos probados también logran resultados muypuntuaciones altasen varios puntos de referencia estandarizados diseñados para probar diversas capacidades, incluido el razonamiento, mientras falla en el muy simple problema AIW.

Por lo tanto, en su artículo, los científicos sugieren que estos puntos de referencia no reflejan correctamente las deficiencias en el razonamiento básico de estos modelos, y cuestionan también el uso de los puntos de referencia estandarizados actuales paramodelocomparación.Modelos de lenguaje en el banco de pruebas.

Si bien el artículo aún no ha sido revisado por pares, sus hallazgos ya están causando sensación.

¿Qué tan capaces son realmente los LLM?¿Qué significa para el uso de LLM si fallan en tareas de nivel de escuela primaria?El coautor Jitsev (JSC) dice: "Estamos abrumados por las discusiones y consultas como resultado de nuestro artículo".Los hallazgos de los científicos ponen en duda muchas cosas y hacen absolutamente imprescindible realizar más estudios sobre la competencia de los modelos lingüísticos.

Jitsev dice: "Nuestro artículo proporciona nuevos conocimientos extremadamente importantes sobre las capacidades reales de los modelos lingüísticos para sacar conclusiones correctas siguiendo un razonamiento básico adecuado; se necesita más investigación de seguimiento para comprender cómo y por qué falla el razonamiento básico en los modelos actuales".en problemas tan fáciles."

Más información:Marianna Nezhurina et al, Alicia en el país de las maravillas: tareas simples que muestran un desglose completo del razonamiento en modelos de lenguaje grandes de última generación,arXiv(2024).DOI: 10.48550/arxiv.2406.02061

Información de la revista: arXiv

Citación:Un estudio de inteligencia artificial revela una dramática falla del razonamiento en modelos de lenguaje grandes (23 de julio de 2024)recuperado el 23 de julio de 2024de https://techxplore.com/news/2024-07-ai-reveals-breakdown-large-language.html

Este documento está sujeto a derechos de autor.Aparte de cualquier trato justo con fines de estudio o investigación privados, noparte puede ser reproducida sin el permiso por escrito.El contenido se proporciona únicamente con fines informativos.