"Escalar" es un lema en la industria de la inteligencia artificial a medida que las empresas de tecnología se apresuran a mejorar sus sistemas de inteligencia artificial con conjuntos de datos de Internet cada vez mayores.

También es una señal de alerta para Abeba Birhane de Mozilla, una experta en inteligencia artificial que durante años ha desafiado los valores y prácticas de su campo y la influencia que está teniendo en el mundo.

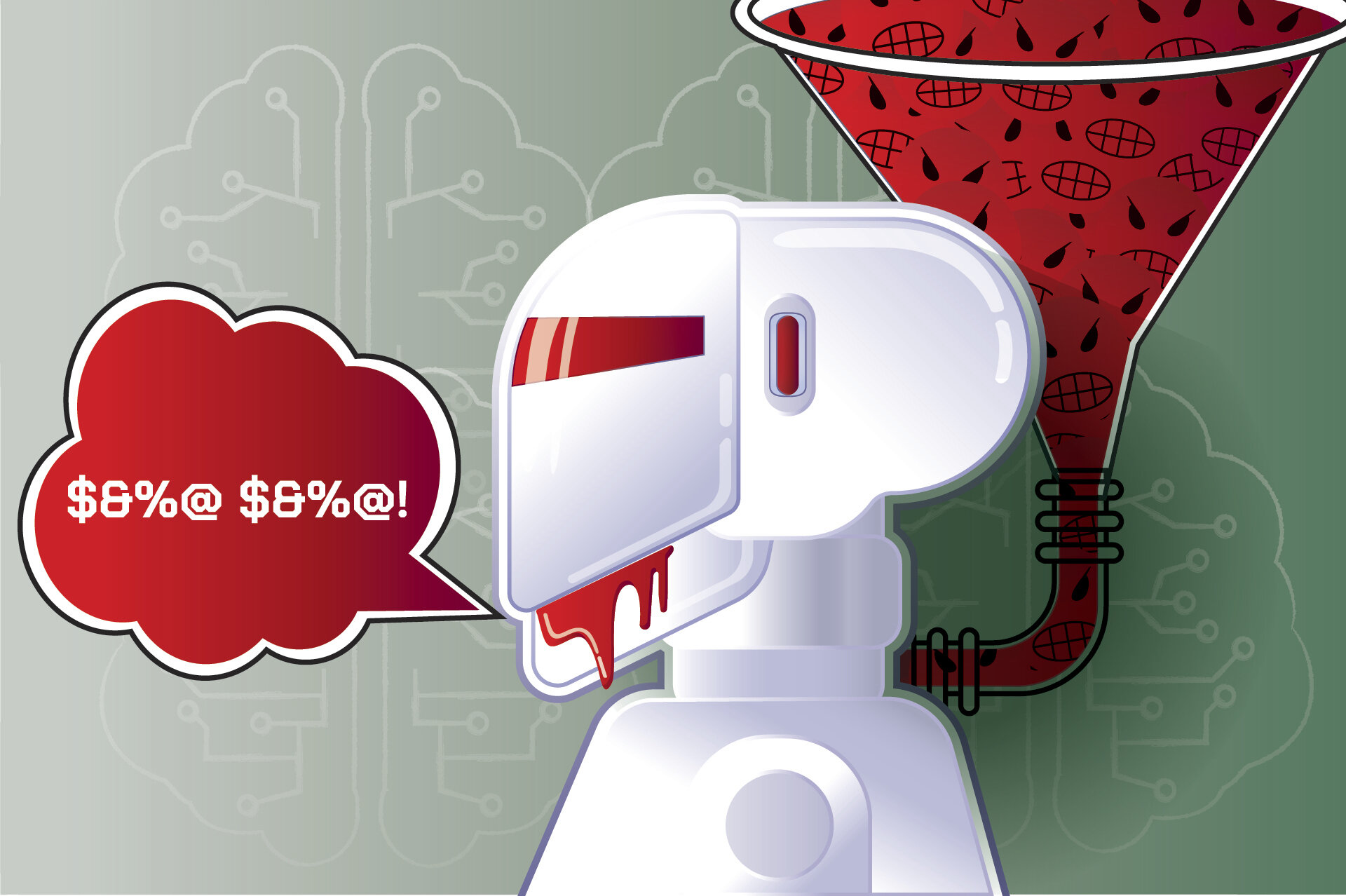

Su última investigacióndescubre que la ampliación de los datos en línea utilizados para entrenar herramientas populares de generación de imágenes de inteligencia artificial está generando resultados racistas de manera desproporcionada, especialmente contra los hombres negros.

Birhane es asesor principal en responsabilidad de IA en la Fundación Mozilla, la organización matriz sin fines de lucro de la empresa de software libre que ejecuta el navegador web Firefox.Criada en Etiopía y residente en Irlanda, también es profesora adjunta adjunta en el Trinity College Dublin.

Su entrevista con The Associated Press ha sido editada para mayor extensión y claridad.

P: ¿Cómo empezaste en el campo de la IA?

R: Soy un científico cognitivo de formación.Cog sci no tiene su propio departamento dondequiera que lo estudies.Entonces donde estudié fue en informática.Me colocaron en un laboratorio lleno de aprendices automáticos.Estaban haciendo tantas cosas increíbles y nadie prestaba atención a los datos.Lo encontré muy divertido y también muy interesante porque pensé que los datos eran uno de los componentes más importantes para el éxito de su modelo.Pero me pareció extraño que la gente no prestara tanta atención ni tiempo a preguntar: "¿Qué hay en mi conjunto de datos?"Así fue como me interesé por este espacio.Y finalmente comencé a realizar auditorías de conjuntos de datos a gran escala.

P: ¿Puedes hablar sobre tu trabajo sobre los fundamentos éticos de la IA?

R: Todo el mundo tiene una opinión sobre lo queaprendizaje automáticose trata de.Entonces, los aprendices automáticos (personas de la comunidad de IA) te dicen que no tiene valor.Es sólo matemática, es objetivo, es neutral y demás.Mientras que los estudiosos de las ciencias sociales dicen que, como cualquier tecnología, el aprendizaje automático codifica los valores de quienes lo impulsan.Entonces, lo que hicimos fue estudiar sistemáticamente cien de los artículos más influyentes sobre aprendizaje automático para descubrir qué es lo que realmente importa en este campo y hacerlo de una manera muy rigurosa.

R: ¿Y uno de esos valores fue la ampliación de escala?

P: La escala se considera el santo grial del éxito.Hay investigadores de grandes empresas como DeepMind, Google y Meta, que afirman que la escala supera al ruido y la escala cancela el ruido.La idea es que a medida que se amplía, todo en su conjunto de datos debería igualarse, debería equilibrarse.Y debería terminar con algo así como una distribución normal o algo más cercano a la verdad fundamental.Esa es la idea.

P: Pero su investigación ha explorado cómo la ampliación puede provocar daños.¿Cuáles son algunos de ellos?

R: Al menos en lo que respecta acontenido odiosoo toxicidad, etc., al escalar estos conjuntos de datos también se escalan los problemas que contienen.Más específicamente, en el contexto de nuestro estudio, ampliar los conjuntos de datos también aumenta el contenido de odio en el conjunto de datos.Medimos la cantidad de contenido de odio en dos conjuntos de datos.El contenido de odio, el contenido dirigido y el contenido agresivo aumentaron a medida queconjunto de datosse escaló de 400 millones a 2 mil millones.Ese fue un hallazgo muy concluyente que muestra que las leyes de escalamiento realmente no se sostienen cuando se trata de datos de entrenamiento.(En otro artículo) descubrimos que a las mujeres de piel más oscura, y a los hombres en particular, se les tiende a asignar etiquetas de persona sospechosa o criminal en una proporción mucho mayor.

P: ¿Qué esperanza o confianza tiene en que la industria de la IA realizará los cambios que ha propuesto?

R: Estos no son sólo resultados puramente matemáticos y técnicos.También son herramientas que dan forma a la sociedad, que influyen en la sociedad.Las recomendaciones son que también incentivemos y prestemos atención a valores como la justicia, la equidad, la privacidad, etc.Mi respuesta honesta es que no tengo ninguna confianza en que la industria acepte nuestras recomendaciones.Nunca han seguido recomendaciones como ésta que realmente los alienten a tomar en serio estos problemas sociales.Probablemente nunca lo harán.Las corporaciones y las grandes empresas tienden a actuar cuando es legalmente requerido.Necesitamos una regulación muy fuerte y aplicable.También reaccionan ante la indignación pública y la conciencia pública.Si llega a un estado en el que su reputación se ve dañada, tienden a realizar cambios.

© 2024 The Associated Press.Reservados todos los derechos.Este material no puede publicarse, transmitirse, reescribirse ni redistribuirse sin permiso.

Citación:La industria de la IA está influyendo en el mundo.El asesor de Mozilla, Abeba Birhane, desafía sus valores fundamentales (22 de julio de 2024)recuperado el 22 de julio de 2024de https://techxplore.com/news/2024-07-ai-industry-world-mozilla-abeba.html

Este documento está sujeto a derechos de autor.Aparte de cualquier trato justo con fines de estudio o investigación privados, noparte puede ser reproducida sin el permiso por escrito.El contenido se proporciona únicamente con fines informativos.