Si le pides a un generador de imágenes de IA que te dé una imagen de algo, los resultados pueden variar desde apropiados hasta desorientados y francamente ofensivos.Es particularmente malo para las culturas que no están bien representadas en los datos de Internet.

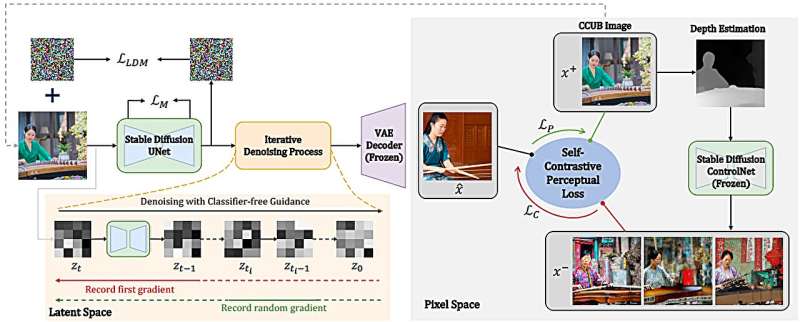

Un equipo internacional dirigido por la Universidad Carnegie Mellon ha utilizado el sistema Bridges-2 de PSC y las aportaciones de variosdiferentes culturasdesarrollar un enfoque de ajuste eficaz, el ajuste fino autocontrastivo (SCoFT, pronunciado "suave"), para volver a entrenar un generador de imágenes popular para que pueda generar imágenes equitativas para culturas subrepresentadas.

Si le has pedido a algún motor de búsqueda que te proporcione una imagen de un objeto o una escena, es posible que hayas notado algo extraño.De vez en cuando obtienes lo que estás pidiendo;otras veces, los resultados son desconcertantes.Y a veces son francamente desagradables.

El problema se magnifica cuando alguien le pide a un generador de imágenes de IA que cree una imagen.Una imagen en el sitio web de una organización que sea ofensiva en un país determinado puede costarle negocios o relaciones en ese país.

Algunas investigaciones sugieren quejóvenesQuienes encuentran imágenes negativas de personas como ellos en línea pueden sufrir tasas más altas de depresión y autolesiones.Y luego está simplemente la vergüenza de compartir una imagen que resulta, bueno, despistada, y mucho menos ofensiva.

"Queríamos utilizarrepresentación visualcomo una forma universal de comunicación entre personas de todo el mundo", afirmó Jean Oh, profesor asociado de investigación en el Instituto de Robótica de CMU. "Por ejemplo, las imágenes generadas pueden ayudar a los adultos mayores a aprender idiomas extranjeros en nuestro proyecto de colaboración internacional dentro de NSF AI-CARINGprograma.

"Pero cuando comenzamos a generar imágenes sobre Corea, China y Nigeria, inmediatamente observamos que los modelos de base populares no tienen ni idea del mundo fuera de los EE. UU. Si volvemos a dibujar el mapa mundial basándonos en lo que estos modelos saben, estará bastante sesgado.".

Esto no es sorprendente.Estos modelos han sido entrenados con datos de Internet.E Internet, si bien es global, tiende a estar dominada por contenidos occidentales y particularmente estadounidenses e ingleses.

Un equipo de investigación dirigido por Oh está trabajando en cómo hacer que los modelos generativos de IA sean conscientes de la diversidad de personas y culturas.Con este objetivo, su equipo desarrolló un novedoso enfoque de ajuste y, gracias a una asignación del proyecto ACCESS de la NSF, utilizó la supercomputadora Bridges-2 del PSC para entrenar nuevos modelos y ejecutar conjuntos de experimentos para verificar el rendimiento del enfoque propuesto.

Cómo ayudó PSC

En un momento, los científicos que desarrollaban los enfoques de IA subyacentes a la generación de imágenes pensaron que cuantos más datos tuviéramos, mejores serían los resultados.Internet, sin embargo, no resultó así.Además de estar dominados por imágenes y datos occidentales, hay cosas realmente malas por ahí.Por muchas razones, los datos masivos no siempre nos señalan la dirección correcta.

Las IA de aprendizaje profundo aprenden por fuerza bruta, comenzando por hacer conjeturas aleatorias sobre undatos de entrenamientoconjunto en el que los humanos han etiquetado las respuestas "correctas".A medida que la computadora hace conjeturas buenas o malas, utiliza estas etiquetas para corregirse y eventualmente se vuelve lo suficientemente precisa como para probar datos para los cuales no se le han dado las respuestas.

Para la tarea de generar imágenes basadas en solicitudes realizadas con texto, una herramienta de inteligencia artificial llamada Stable Diffusion es un ejemplo de lo último en tecnología, habiéndose entrenado en el conjunto de datos LAION de 5,85 mil millones de pares de texto a imagen.

Pero pídale a Stable Diffusion que le dé una imagen de una calle moderna en Ibadan, Nigeria, y creará algo que se parece más al estereotipo negativo occidental de una calle de ciudad africana: un camino de tierra deteriorado con basura en la calle y ropa.colgando de las ventanas.Otras imágenes que surgen, para otras culturas, pueden ser menos ofensivas.En cierto modo eso es peor, porque es más difícil de identificar.

Para mejorar esto, el equipo del Instituto de Robótica reclutó a personas de cinco culturas para seleccionar un conjunto de datos pequeño y culturalmente relevante.Aunque este conjunto de datos de Cross-Cultural Understanding Benchmark (CCUB) tenía solo un promedio de aproximadamente 140 pares de texto e imagen para cada cultura, permitió al equipo volver a capacitar a Stable Diffusion para enseñarle a generar imágenes que representen cada cultura con mayor precisión y con menos estereotipos.en comparación con el modelo de referencia.El equipo también agregó el mismo paso de ajuste a las imágenes generadas por el popular generador de imágenes de IA GPT-3.

"Utilizo un modo compartido de GPU para mis fines de entrenamiento", dijo Zhixuan Liu, estudiante de posgrado del grupo de Oh y primer autor del nuevo artículo que describe el trabajo."Mi investigación requiere realizar múltiples estudios de ablación en varios dominios culturales, lo que hace que sea inviable completar estos experimentos sin realizar tareas paralelas en la plataforma [Bridges-2].

"Además, el proyecto implica el ajuste de un modelo de conversión de texto a imagen a gran escala, lo que exige importantes recursos de capacitación que PSC ofrece fácilmente".

Bridges-2 resultó ideal para el trabajo.El sistema insignia de PSC ofrece potentes unidades de procesamiento de gráficos (GPU) fáciles de reconocer de imágenes y patrones, y una arquitectura diseñada para ayudar a que grandes datos se muevan eficientemente a través de la computadora sin atascos.Esto permitió a los científicos ajustar la IA en pasos progresivos que mejoraron significativamente las impresiones que 51 personas de cinco culturas receptoras tenían a partir de las imágenes resultantes.

Su método SCoFT mejoró la percepción de los jueces sobre qué tan bien la imagen coincidía con la consulta de texto, qué tan bien representaba sus culturas y también redujo el carácter ofensivo de las imágenes.

El equipo presentará un artículo sobre su trabajo en la Conferencia de reconocimiento de patrones y visión por computadora IEEE/CVF de 2024 (CVPR 24), que comienza el 19 de junio de 2024. Actualmente se encuentradisponibleen elarXivservidor de preimpresión.

Los objetivos futuros incluyen adaptar SCoFT a algo más que culturas nacionales.En una aplicación ampliada, por ejemplo, SCoFT mejoró las imágenes de personas con prótesis vistas por esa comunidad.

Más información:Zhixuan Liu et al, SCoFT: ajuste fino autocontrastivo para una generación de imágenes equitativa,arXiv(2024).DOI: 10.48550/arxiv.2401.08053

Información de la revista: arXiv

Citación:La supercomputadora ayuda a reentrenar a las IA para evitar crear imágenes ofensivas para culturas específicas (2024, 4 de junio)recuperado el 4 de junio de 2024de https://techxplore.com/news/2024-06-supercomputer-retrain-ais-offensive-pictures.html

Este documento está sujeto a derechos de autor.Aparte de cualquier trato justo con fines de estudio o investigación privados, noparte puede ser reproducida sin el permiso por escrito.El contenido se proporciona únicamente con fines informativos.