Cada día que pasa, parece que cada vez es más difícil confiar en lo que ves (y oyes) en Internet.Los deepfakes y el audio manipulado se han vuelto más fáciles de crear con solo presionar un botón.Una nueva investigación realizada por tres estudiantes y ex alumnos de la Escuela de Información facilitará la determinación de la autenticidad de un clip de audio.

Romit Barua, Gautham Koorma y Sarah Barrington (todos MIMS '23) presentaron por primera vez su investigación sobre clonación de voz como su proyecto final para el programa de Maestría en Sistemas y Gestión de la Información.Barrington es ahora un Ph.D.Estudiante de la I Escuela.

Trabajando con el profesor Hany Farid, el equipo examinó diferentes técnicas para diferenciar una voz real de una clonada diseñada para hacerse pasar por una persona específica.

"Cuando este equipo se acercó a mí por primera vez a principios de la primavera de 2022, les dije que no se preocuparan por los deepfake.audioporque la clonación de voz simplemente no era muy buena y pasaría un tiempo antes de que tuviéramos que preocuparnos por ello.Me equivoqué y, unos meses más tarde, la clonación de voz impulsada por IA fue sorprendentemente buena y reveló lo rápido que evoluciona esta tecnología", afirmó el profesor Farid. "El equipo ha realizado un trabajo importante al presentar una serie de ideas para detectar la nueva amenaza.de audio deepfake."

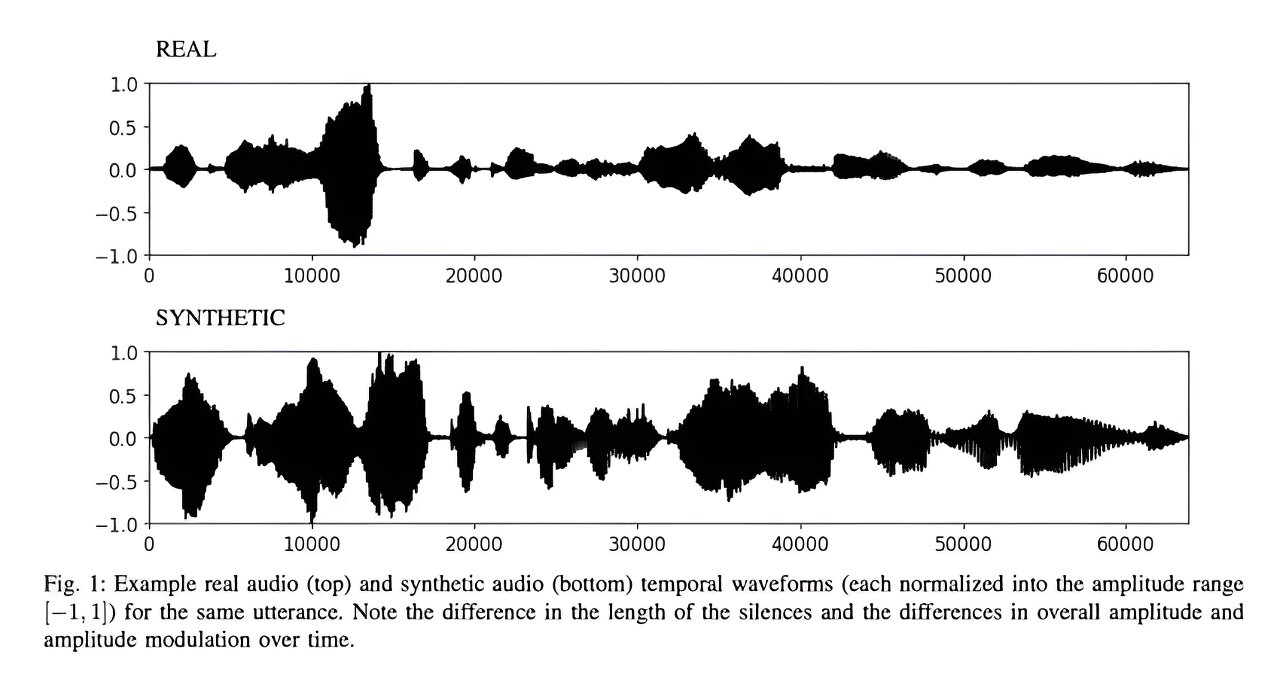

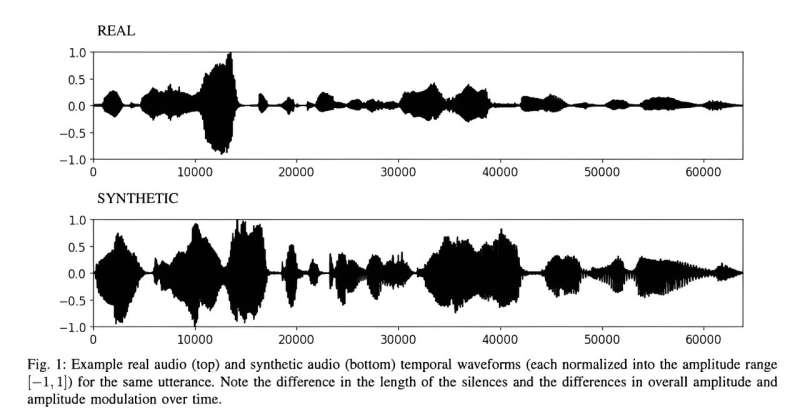

Para comenzar, el equipo primero analizó muestras de audio de voces reales y falsas observando características o patrones de percepción que pueden identificarse visualmente.A través de esta lente, se concentraron en observar las ondas de audio y notaron que las voces humanas reales a menudo tenían más pausas y variaban en volumen a lo largo del clip.Esto se debe a que las personas tienden a utilizar palabras de relleno y pueden moverse y alejarse del micrófono mientras graban.

Al analizar estas características, el equipo pudo identificar las pausas y la amplitud (consistencia y variación en la voz) como factores clave a buscar al intentar determinar la autenticidad de una voz.Sin embargo, también descubrieron que este método, si bien es fácil de entender, puede producir resultados menos precisos.

Luego, el equipo adoptó un enfoque más detallado, observando las características espectrales generales utilizando un paquete de análisis de ondas de audio "disponible en el mercado".El programa extrae más de 6000 funciones, incluidas estadísticas resumidas (media,desviación estándar, etc.), coeficientes de regresión y más, antes de reducir el número a los 20 más importantes.Al analizar estas funciones extraídas y compararlas con otros clips de audio, Barrington, Barua y Koorma utilizaron estas funciones para crear un método más preciso.

Sin embargo, sus resultados más precisos se produjeron con las funciones aprendidas, lo que implica entrenar un modelo de aprendizaje profundo.Para hacerlo, el equipo alimenta el audio sin procesar al modelo, del cual procesa y extrae representaciones multidimensionales, llamadas incrustaciones.Una vez generado, el modelo utiliza estas incrustaciones para distinguir el audio real y sintético.

Este método ha superado consistentemente a las dos técnicas anteriores en cuanto a precisión y ha registrado tan solo un 0% de error en entornos de laboratorio.A pesar de la alta tasa de precisión, el equipo ha observado que este método podría resultar difícil de entender sin el contexto adecuado.

El equipo cree que esta investigación puede abordar las crecientes preocupaciones sobre el usovozclonación y deepfakes con fines nefastos."La clonación de voz es uno de los primeros casos en los que somos testigos de deepfakes con utilidad en el mundo real, ya sea para eludir la verificación biométrica de un banco o para llamar a un miembro de la familia pidiendo dinero", explicó Barrington.

Más información:Sarah Barrington et al, Detección de voz clonada de uno o varios hablantes: de las funciones perceptuales a las aprendidas,arXiv(2023).DOI: 10.48550/arxiv.2307.07683

Información de la revista: arXiv

Citación:Una nueva investigación combate la creciente amenaza del audio deepfake (26 de enero de 2024)recuperado el 26 de enero de 2024de https://techxplore.com/news/2024-01-combats-burgeoning-threat-deepfake-audio.html

Este documento está sujeto a derechos de autor.Aparte de cualquier trato justo con fines de estudio o investigación privados, noparte puede ser reproducida sin el permiso por escrito.El contenido se proporciona únicamente con fines informativos.